Cos'è la Crawlability?

Il significato di crawlability di una pagina web si riferisce alla facilità con cui i motori di ricerca (come Google) possono scoprire la pagina.

Google scopre le pagine web attraverso un processo chiamato crawling o scansionamento, utilizzando programmi informatici chiamati web crawler (detti anche bot o spider). Questi programmi seguono i link tra le pagine per scoprire pagine nuove o aggiornate.

L'indicizzazione segue solitamente lo scansionamento.

Cos'è l'Indexability e come influisce nelle SERP?

L'indexability o "indicizzabilità" di una pagina web significa che i motori di ricerca (come Google) sono in grado di aggiungere la pagina al loro indice.

Il processo di aggiunta di una pagina web a un indice si chiama indicizzazione. Significa che Google analizza la pagina e il suo contenuto e la aggiunge a un database di miliardi di pagine (chiamato indice di Google), che poi compariranno nelle SERP per le query corrispondenti.

In Che Modo la Capacità di Crawling e Indicizzazione Influiscono sulla SEO?

Sia la crawlability che la indexability sono fondamentali per la SEO.

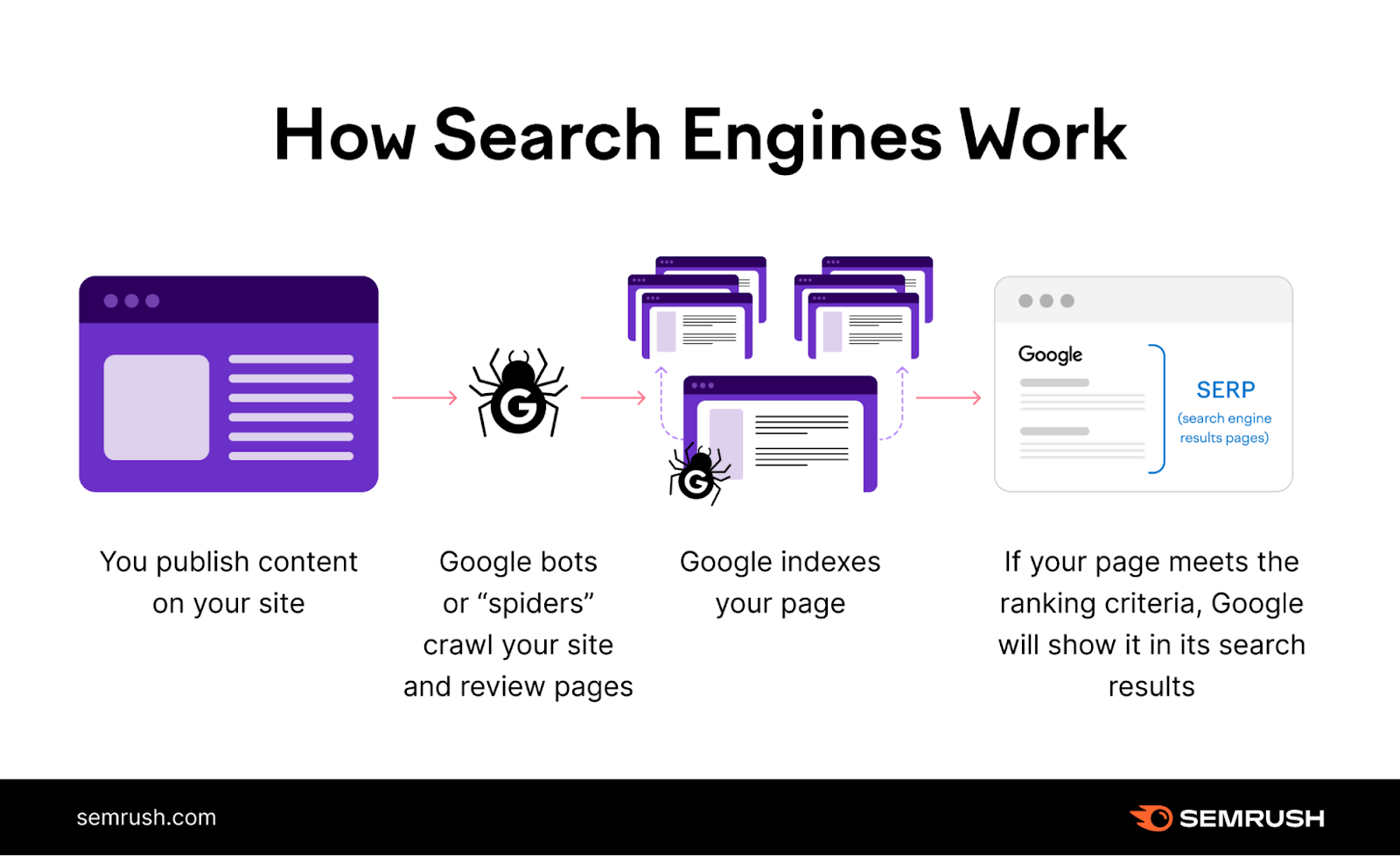

Ecco una semplice illustrazione che mostra come funziona Google:

Per prima cosa, Google scansiona la pagina. Poi la indicizza. Solo allora può classificare la pagina per le query di ricerca pertinenti.

In altre parole: Se non viene prima scansionata e indicizzata, la pagina non viene classificata da Google.

Nessun posizionamento in SERP = nessun traffico di ricerca.

Matt Cutts, ex responsabile del web spam di Google, spiega il processo in questo video:

Non sorprende che una parte importante della SEO sia assicurarsi che le pagine del tuo sito web siano scansionabili e indicizzabili.

Ma come si fa?

Inizia conducendo un audit di SEO tecnica del tuo sito web.

Utilizza lo strumento Site Audit di Semrush per scoprire i problemi di crawlability e indexability (lo approfondiremo più avanti in questo post).

Cosa Influenza la Capacità di Crawling e di Indicizzazione?

Link Interni

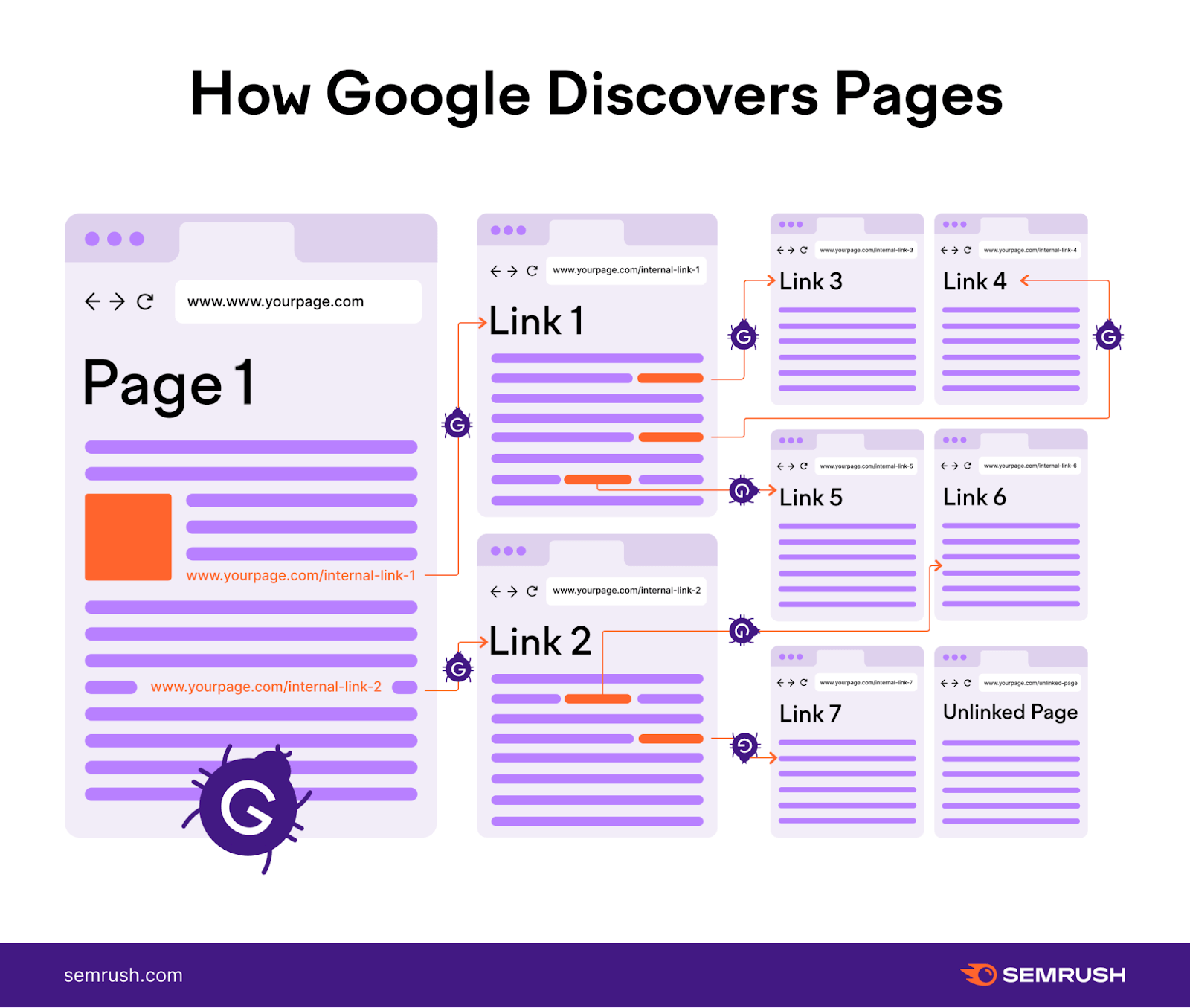

I link interni hanno un impatto diretto sulla crawlability e indexability del tuo sito web.

Ricorda: i motori di ricerca utilizzano i bot per scansionare e scoprire le pagine web. I link interni fungono da cartina stradale, guidando i bot da una pagina all'altra del tuo sito web.

Link interni ben posizionati rendono più facile per i bot dei motori di ricerca trovare tutte le pagine del tuo sito web.

Quindi, assicurati che ogni pagina del tuo sito sia linkata da qualche altra parte all'interno del sito stesso.

Inizia con l'includere un menu di navigazione, link a piè di pagina e link contestuali all'interno dei tuoi contenuti.

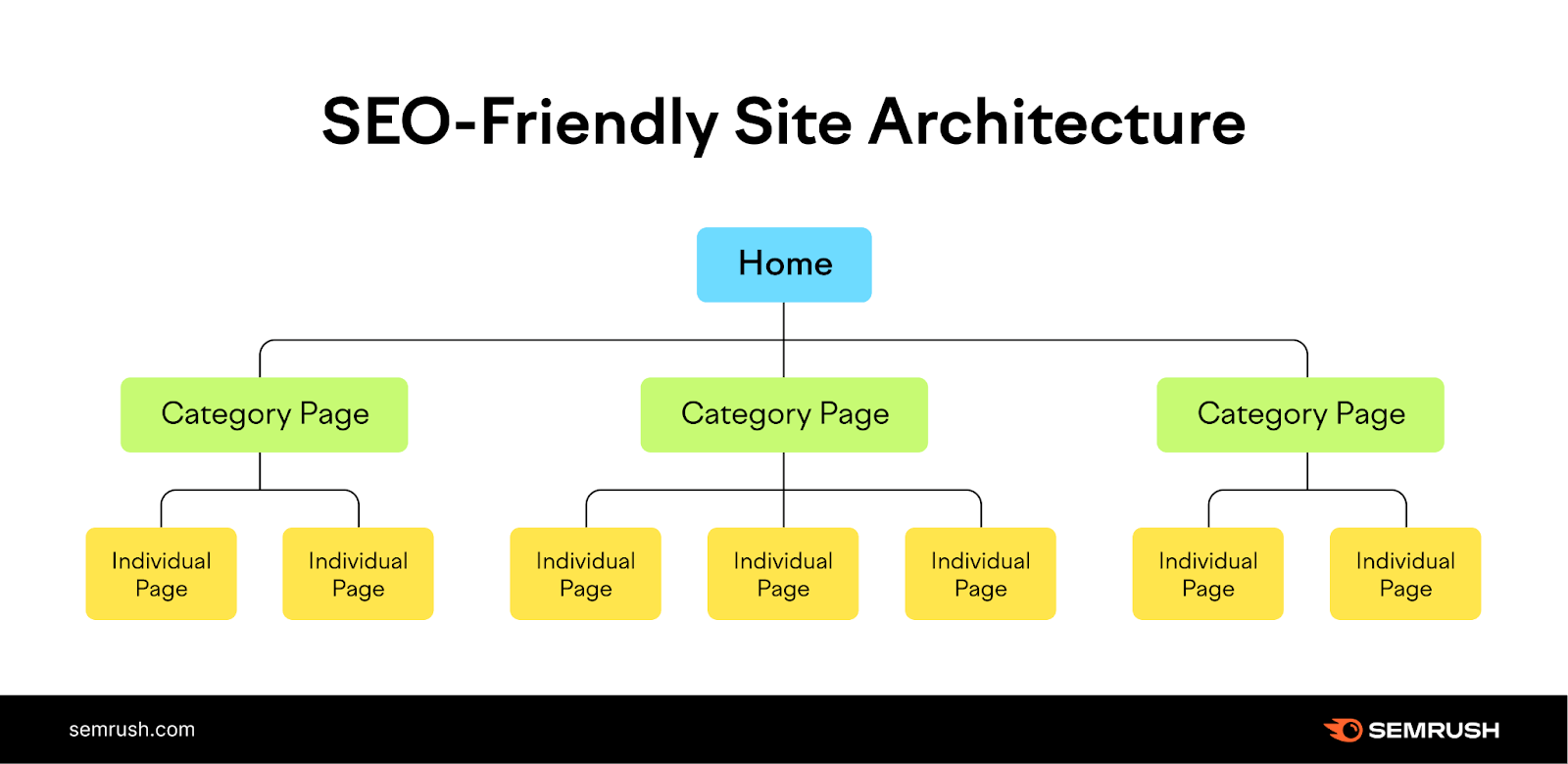

Se sei nelle prime fasi di sviluppo di un sito web, la creazione di una struttura logica del sito può aiutarti a creare una solida base di link interni.

Una struttura logica del sito organizza il tuo sito in categorie. Poi queste categorie si collegano alle singole pagine del sito.

Ad esempio:

La homepage si collega alle pagine di ogni categoria. Poi, le pagine di ogni categoria si collegano a specifiche sottopagine del sito.

Adattando questa struttura, costruirai una solida base per consentire ai motori di ricerca di navigare e indicizzare facilmente i tuoi contenuti.

Robots.txt

Il file Robots.txt è come un buttafuori all'ingresso di una festa.

Si tratta di un file sul tuo sito web che indica ai bot dei motori di ricerca a quali pagine possono accedere.

Ecco un esempio di file robots.txt:

User-agent: *

Allow:/blog/

Disallow:/blog/admin/

Vediamo di capire ogni componente di questo file.

- User-agent: *: Questa riga specifica che le regole si applicano a tutti i bot dei motori di ricerca.

- Allow: /blog/: Questa direttiva permette ai bot dei motori di ricerca di scansionare le pagine all'interno della directory "/blog/". In altre parole, tutti i post del blog possono essere scansionati.

- Disallow: /blog/admin/: Questa direttiva indica ai bot dei motori di ricerca di non scansionare l'area amministrativa del blog.

Quando i motori di ricerca inviano i loro bot per esplorare il tuo sito web, per prima cosa controllano il file robots.txt per verificare la presenza di restrizioni.

Fai attenzione a non bloccare accidentalmente le pagine importanti che vuoi far trovare ai motori di ricerca. Ad esempio i post del tuo blog e le pagine standard del tuo sito web.

Sebbene il robots.txt controlli gli accessi per lo scansionamento, non ha un impatto diretto sull'indicizzazione del tuo sito web.

I motori di ricerca possono comunque scoprire e indicizzare le pagine linkate da altri siti web, anche se queste pagine sono bloccate nel file robots.txt.

Per assicurarti che alcune pagine, come le landing page del pay-per-click (PPC) e le pagine di ringraziamento, non vengano indicizzate, implementa un tag "noindex".

Leggi la nostra guida al meta robots tag per conoscere questo tag e come implementarlo.

Sitemap XML

La sitemap XML svolge un ruolo fondamentale nel migliorare la crawlability e l'indicizzazione del tuo sito web.

Mostra ai bot dei motori di ricerca tutte le pagine importanti del tuo sito web che vuoi far scansionare e indicizzare.

È come fornire loro una mappa del tesoro per scoprire più facilmente i tuoi contenuti.

Quindi, includi tutte le pagine essenziali nella tua sitemap. Comprese quelle che potrebbero essere difficili da trovare attraverso la normale navigazione.

In questo modo i bot dei motori di ricerca potranno scansionare e indicizzare il tuo sito in modo efficiente.

Qualità dei Contenuti

La qualità dei contenuti influisce sul modo in cui i motori di ricerca fanno il crawl del tuo sito web e lo indicizzano.

I bot dei motori di ricerca amano i contenuti di alta qualità. Se i tuoi contenuti sono ben scritti, informativi e rilevanti per gli utenti, possono attirare maggiormente l'attenzione dei motori di ricerca.

I motori di ricerca vogliono fornire i migliori risultati ai loro utenti, per questo motivo daranno priorità alla scansione e indicizzazione del tuo sito web se rilevano che contiene contenuti di prim'ordine.

Concentrati sulla creazione di contenuti originali, di valore e ben scritti.

Utilizza una formattazione corretta, titoli chiari e una struttura organizzata per facilitare lo scansionamento e la comprensione dei tuoi contenuti da parte dei bot dei motori di ricerca.

Per ulteriori consigli sulla creazione di contenuti di qualità, consulta la nostra guida.

Problemi Tecnici

I problemi tecnici possono impedire ai bot dei motori di ricerca di scansionare e indicizzare efficacemente il tuo sito web.

Se il tuo sito web ha tempi di caricamento delle pagine lenti, link rotti o redirect, la capacità dei bot di navigare nel tuo sito può essere compromessa.

Anche i problemi tecnici possono impedire ai motori di ricerca di indicizzare correttamente le tue pagine web.

Ad esempio, se il tuo sito web ha problemi di contenuti duplicati o utilizza in modo improprio i tag canonici, i motori di ricerca potrebbero avere difficoltà a capire quale versione di una pagina indicizzare e classificare.

Problemi come questi sono dannosi per la visibilità del tuo sito web sui motori di ricerca. Identifica e risolvi questi problemi il prima possibile.

Come Trovare i Problemi di Crawlability e Indexability del tuo Sito

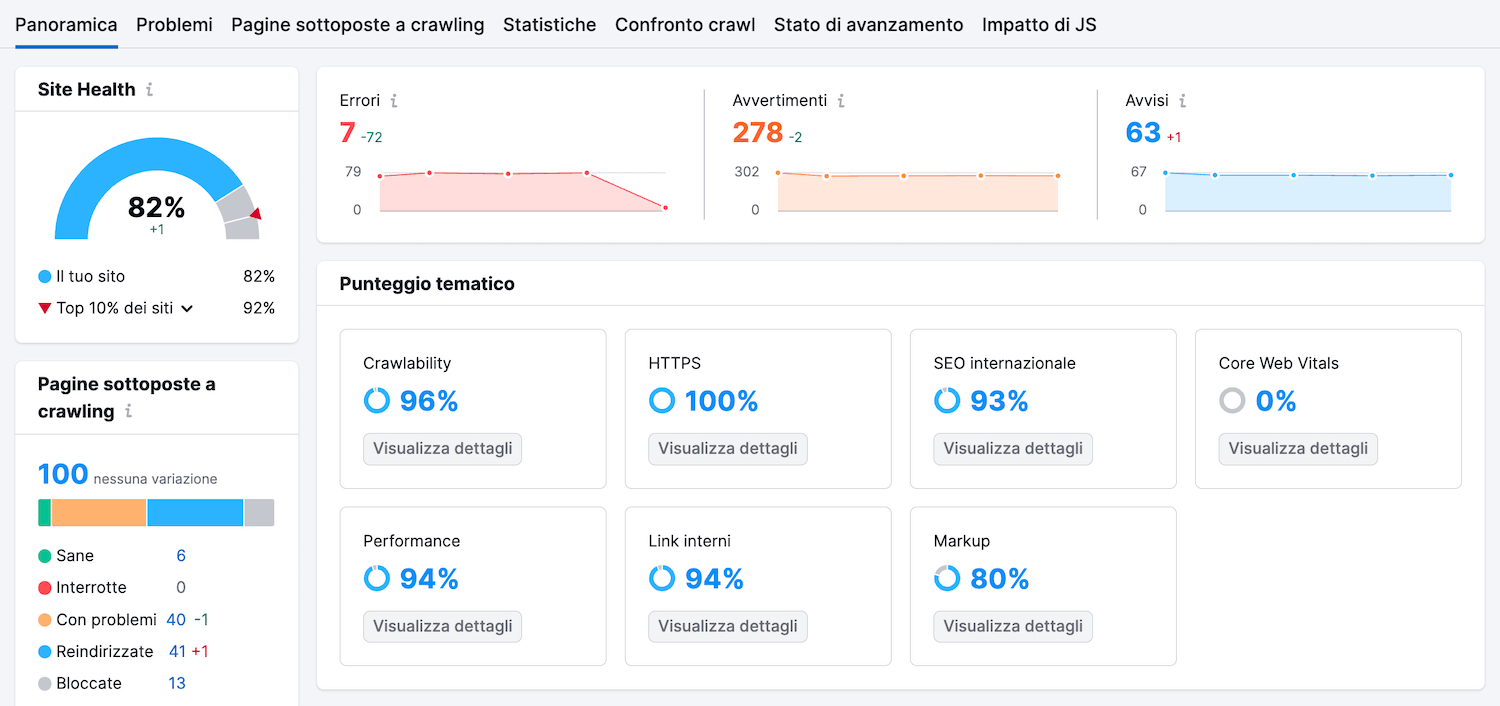

Usa lo strumento Site Audit di Semrush per trovare i problemi tecnici che influenzano la crawlability e l'indicizzazione del tuo sito web.

Lo strumento può aiutarti a trovare e risolvere problemi quali:

- Contenuti duplicati

- Circuiti di redirect

- Link interni rotti

- Errori lato server

- E molto altro ancora.

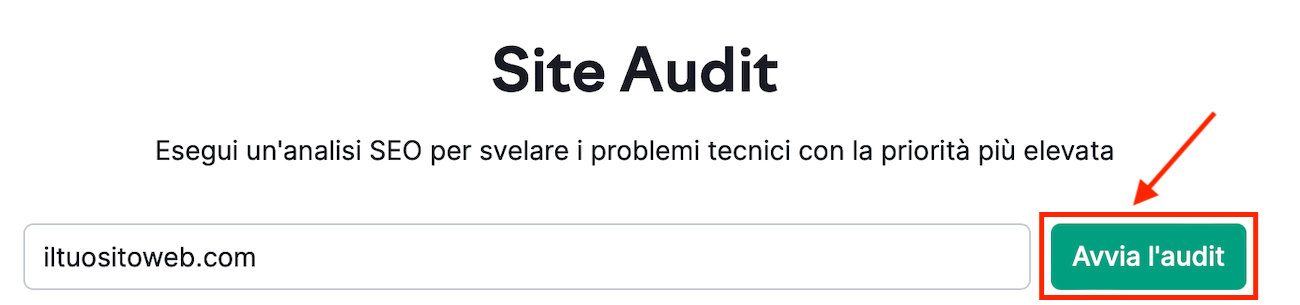

Per iniziare, inserisci l'URL del tuo sito web e clicca su "Avvia l'audit".

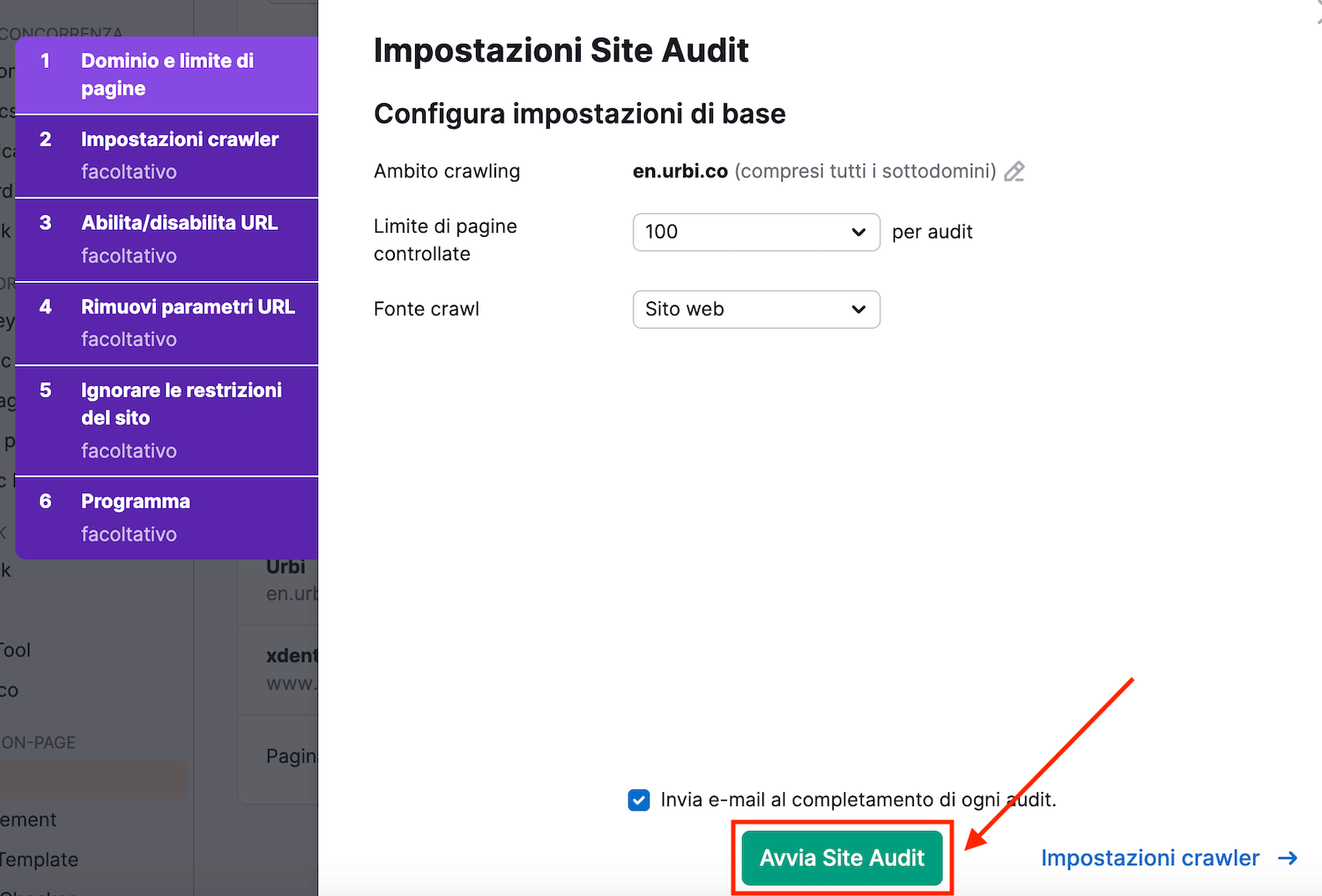

Successivamente, configura le impostazioni di audit. Una volta terminato, clicca su "Avvia Site Audit".

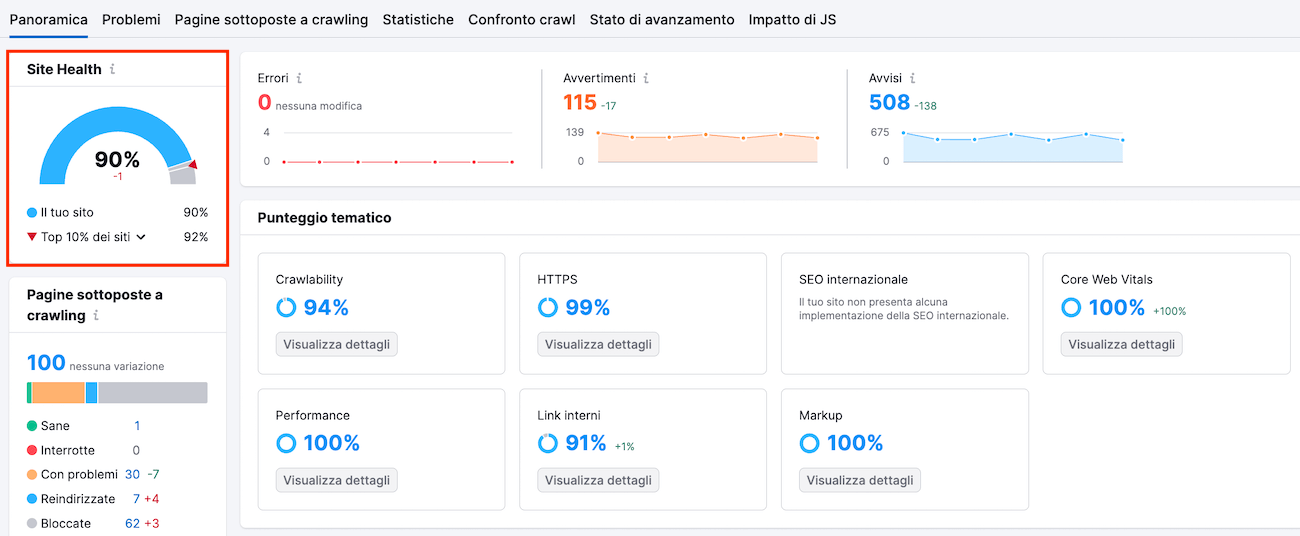

Lo strumento inizierà a verificare la presenza di problemi tecnici nel tuo sito web. Al termine, mostrerà una panoramica della salute tecnica del tuo sito con la metrica "Site Health".

Questo indicatore misura lo stato di salute tecnica generale del tuo sito web su una scala da 0 a 100.

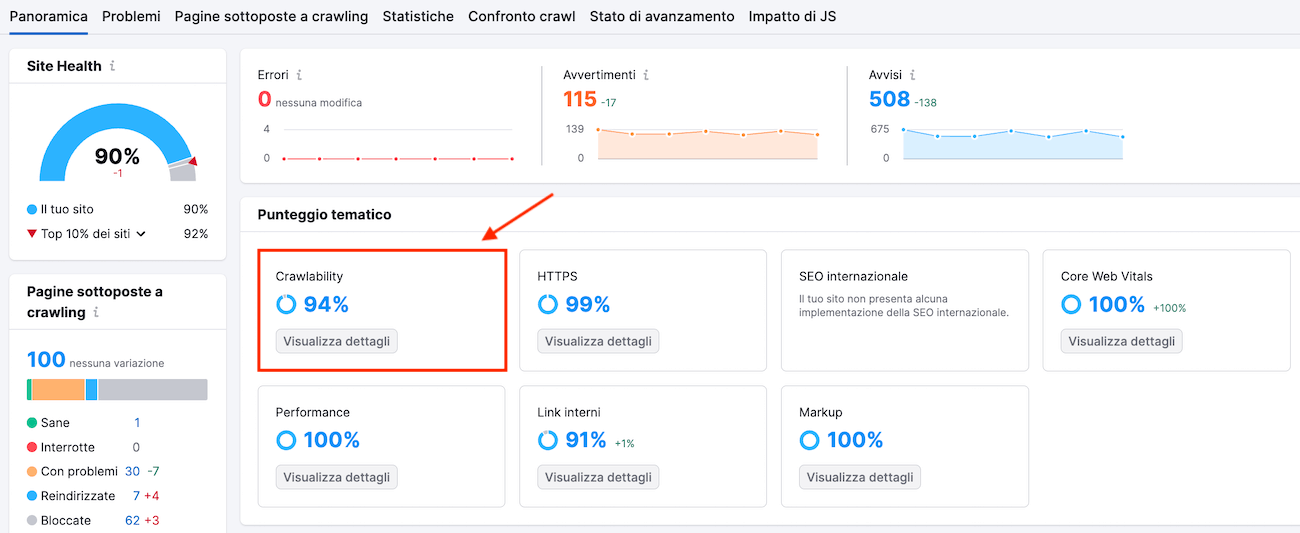

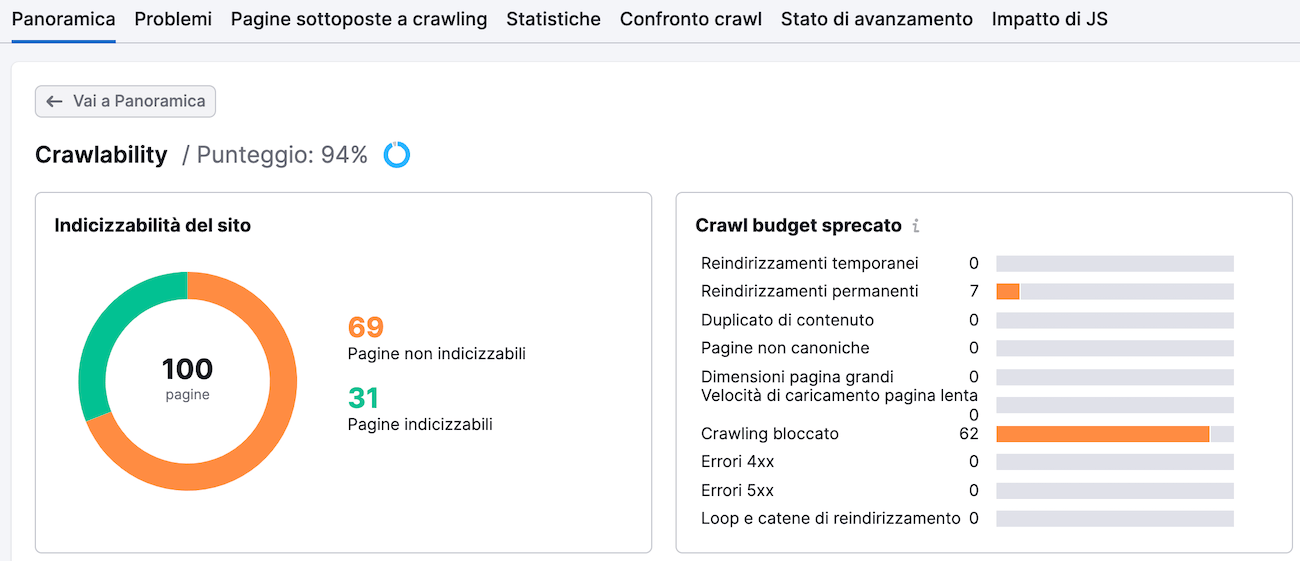

Per vedere i problemi relativi alla crawlability e all'indicizzazione, vai su "Crawlability" e clicca su "Visualizza dettagli".

In questo modo si aprirà un report dettagliato che evidenzia i problemi di crawlability e indicizzazione del tuo sito web.

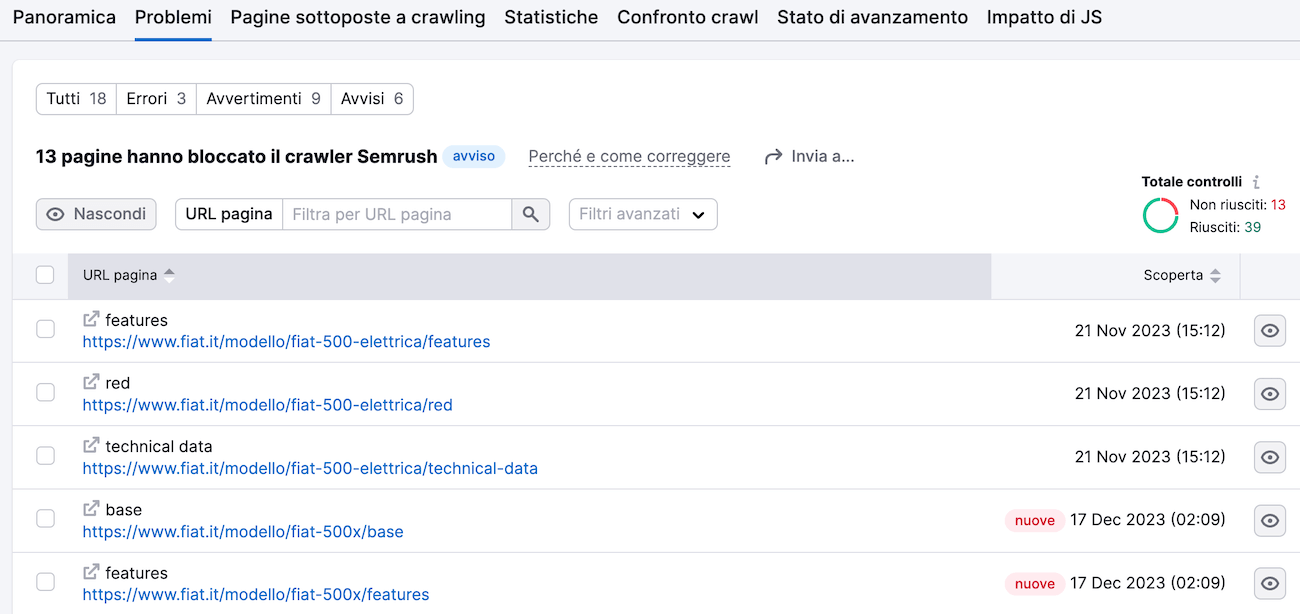

Clicca sul grafico a barre orizzontali accanto a ciascun problema. Lo strumento ti mostrerà tutte le pagine interessate.

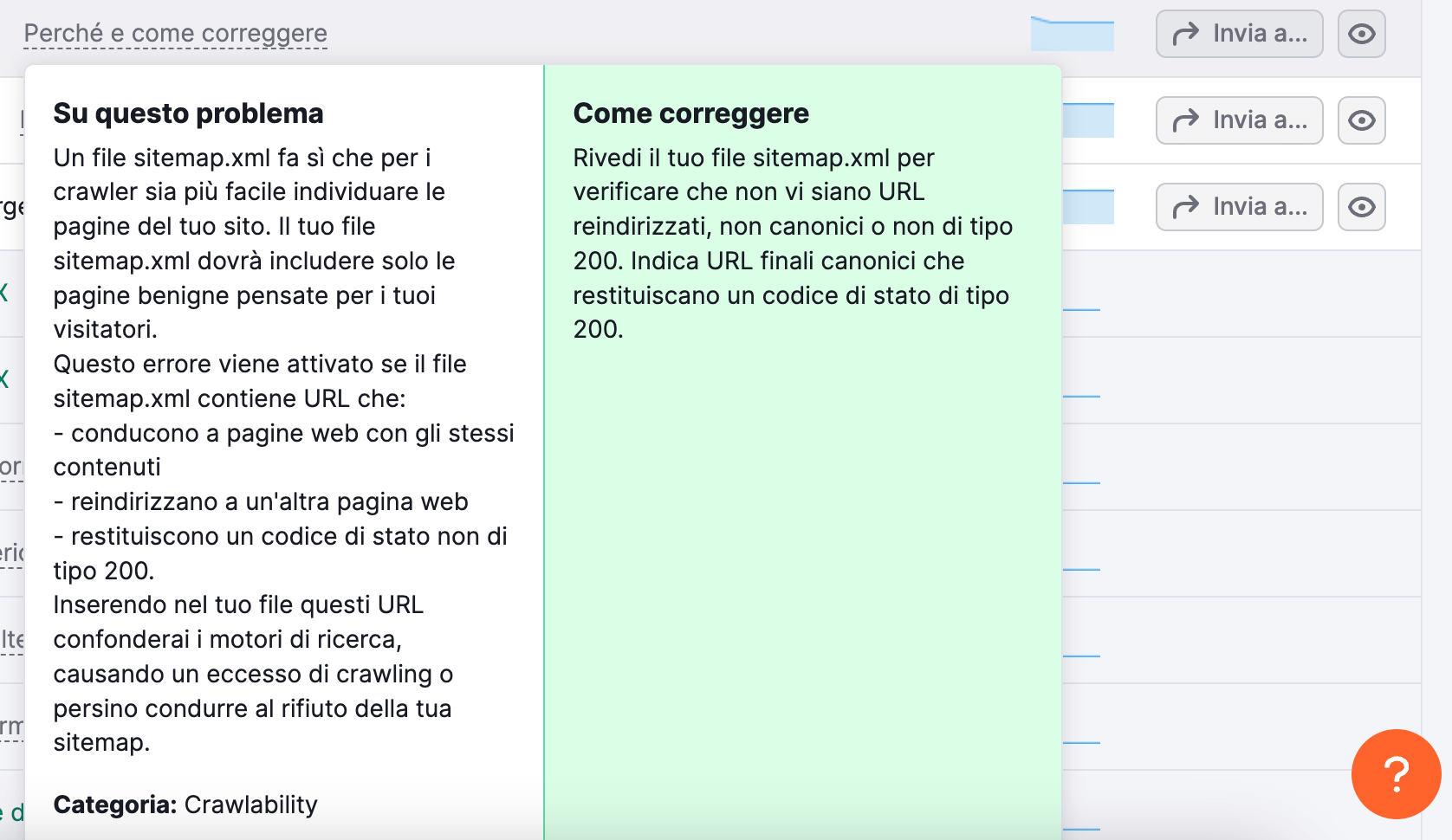

Se non sei sicuro di come risolvere un particolare problema, clicca sul link "Perché e come correggere".

Vedrai una breve descrizione del problema e i consigli su come risolverlo.

Affrontando tempestivamente ogni problema e mantenendo un sito web tecnicamente valido, migliorerai la crawlability, contribuirai a garantire una corretta indicizzazione e aumenterai le tue possibilità di posizionamento del tuo sito in SERP.

Come Migliorare la Crawlability e l'Indicizzazione

Invia la Sitemap a Google

L'invio del file sitemap a Google aiuta a scansionare e indicizzare le tue pagine.

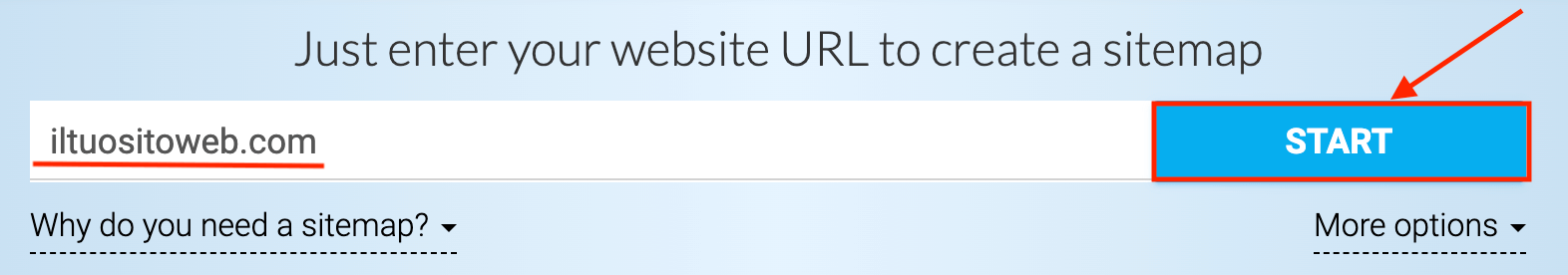

Se non hai ancora una sitemap, creane una utilizzando uno strumento di generazione di sitemap come XML Sitemaps.

Apri lo strumento, inserisci l'URL del tuo sito web e clicca su "Start".

Lo strumento genererà automaticamente una sitemap per te.

Scarica la tua sitemap e caricala nella directory principale del tuo sito.

Ad esempio, se il tuo sito è www.esempio.com, la tua sitemap dovrà trovarsi all'indirizzo www.esempio.com/sitemap.xml.

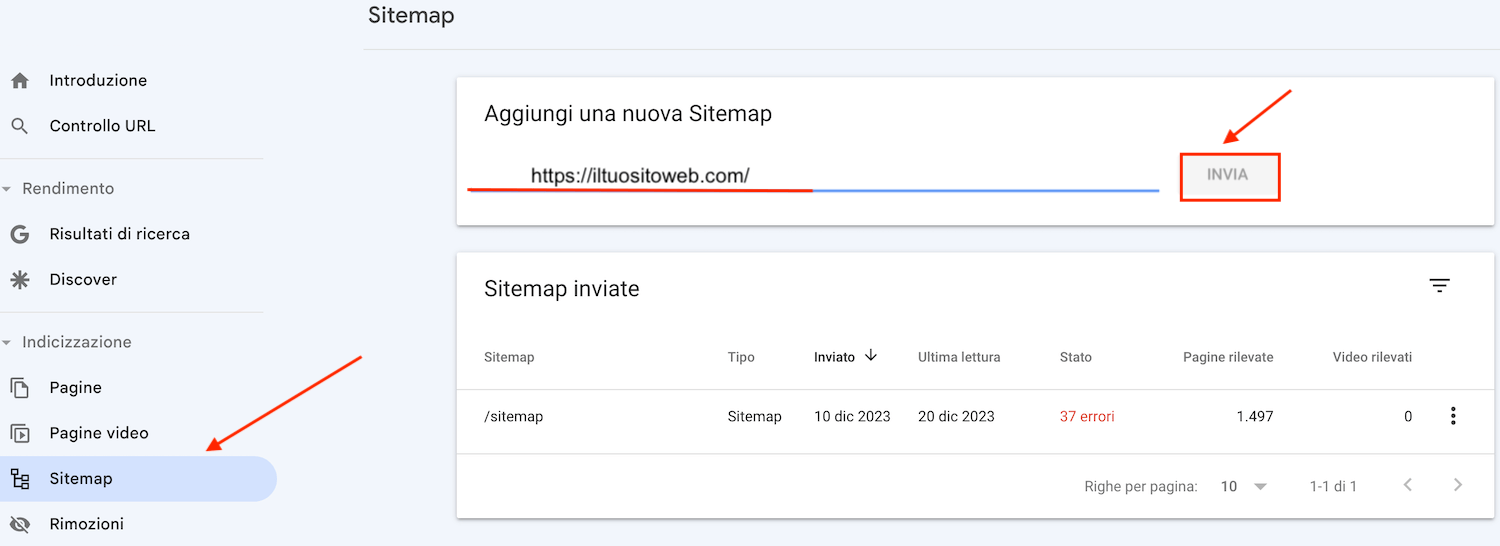

Una volta che la tua sitemap è attiva, inviala a Google tramite il tuo account Google Search Console (GSC).

Non hai ancora configurato GSC? Leggi la nostra guida su Google Search Console per iniziare.

Dopo l'attivazione, vai su "Sitemap" dalla barra laterale. Inserisci l'URL della tua sitemap e clicca su "Invia".

Questo migliora la crawlability e l'indicizzazione del tuo sito web. Se vuoi approfondire, puoi leggere la nostra guida per creare e inviare una Sitemap XML.

Rafforza i Collegamenti Interni

La crawlability e l'indicizzazione di un sito web risiedono anche nella sua struttura di link interni.

Risolvi i problemi relativi ai link interni, come ad esempio i link interrotti e le pagine orfane (cioè le pagine prive di collegamenti interni), e rafforza la tua struttura di link interni.

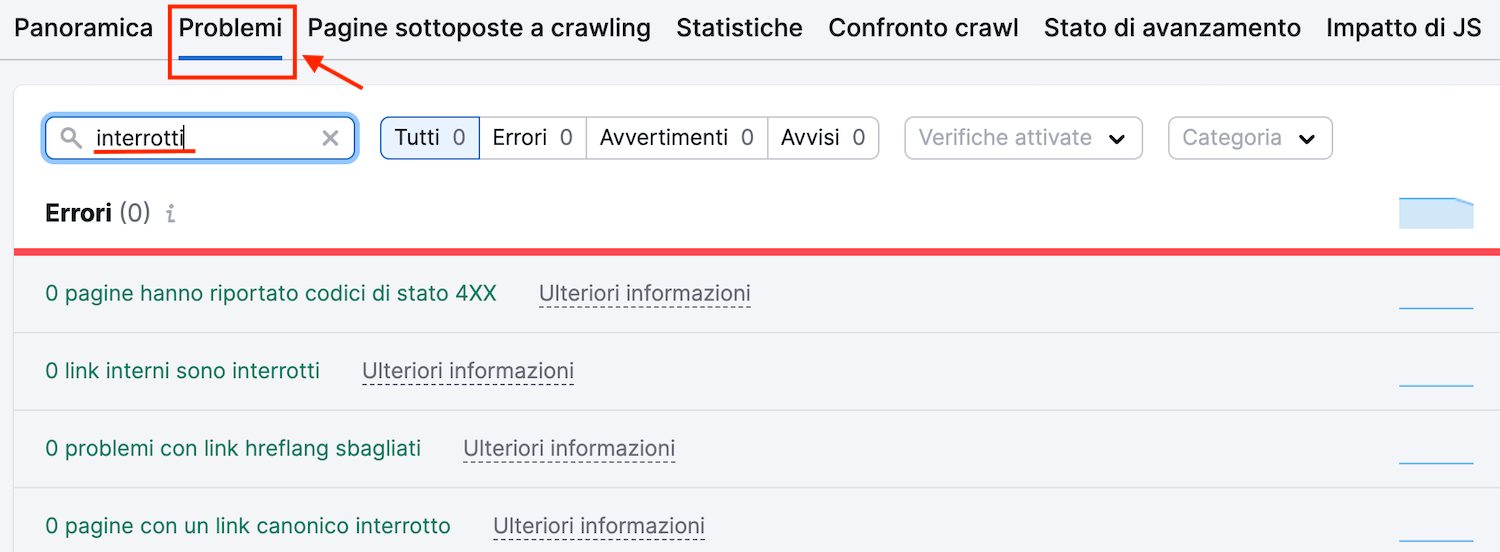

Utilizza lo strumento Site Audit di Semrush a questo scopo.

Vai alla scheda "Problemi" e cerca "interrotti". Lo strumento mostrerà tutti i link interni non funzionanti del tuo sito.

Se lo strumento rileva il problema, clicca su "XXX link interni sono interrotti" per visualizzare l'elenco dei link interni non funzionanti.

Per risolvere il problema dei link interrotti, puoi ripristinare la pagina non funzionante. Oppure implementare un redirect 301 verso una pagina alternativa e pertinente del tuo sito web.

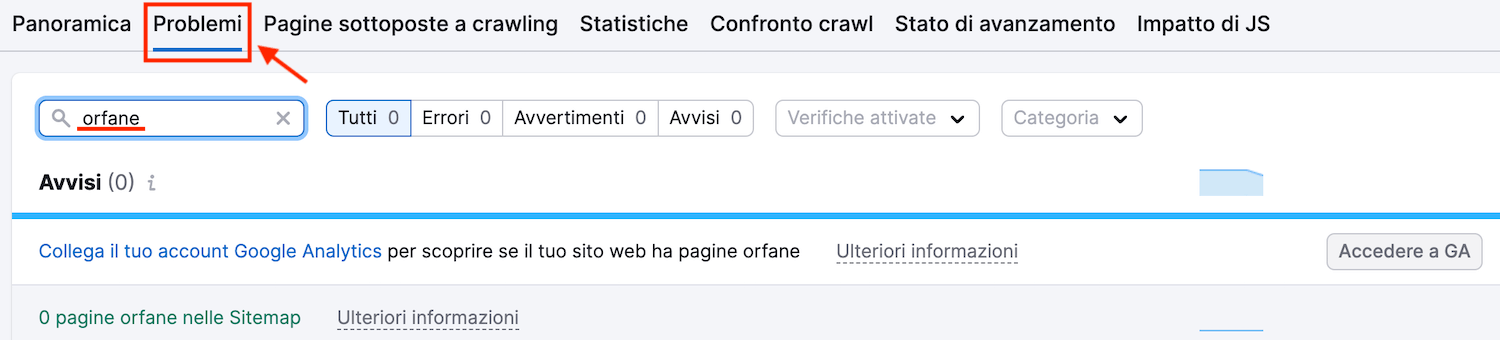

Per trovare le pagine orfane, torna alla scheda Problemi e cerca "orfane".

Lo strumento mostrerà se il tuo sito ha delle pagine orfane. Risolvi questo problema creando dei link interni che puntino a quelle pagine.

Aggiorna Regolarmente e Aggiungi Nuovi Contenuti

Aggiornare e aggiungere regolarmente nuovi contenuti è molto utile per la crawlability e l'indicizzazione del tuo sito web.

I motori di ricerca amano i contenuti freschi. Quando aggiorni e aggiungi regolarmente nuovi contenuti, segnali che il tuo sito web è attivo.

Questo può incoraggiare i bot dei motori di ricerca a scansionare il tuo sito più frequentemente, assicurandosi di catturare gli ultimi aggiornamenti.

Cerca di aggiornare il tuo sito web con nuovi contenuti a intervalli regolari, se possibile.

La pubblicazione di nuovi post sul blog o l'aggiornamento di quelli esistenti aiutano i bot dei motori di ricerca a mantenere il tuo sito attivo e i tuoi contenuti freschi nel loro indice.

Evita Contenuti Duplicati

Evitare i contenuti duplicati è essenziale per migliorare la crawlability e l'indicizzazione del tuo sito web.

I contenuti duplicati possono confondere i bot dei motori di ricerca e sprecare risorse per lo scansionamento.

Quando contenuti identici o molto simili sono presenti su più pagine del tuo sito, i motori di ricerca possono avere difficoltà a determinare quale versione scansionare e indicizzare.

Assicurati quindi che ogni pagina del tuo sito abbia un contenuto unico. Evita di copiare e incollare contenuti da altre fonti e non duplicare i tuoi contenuti su più pagine.

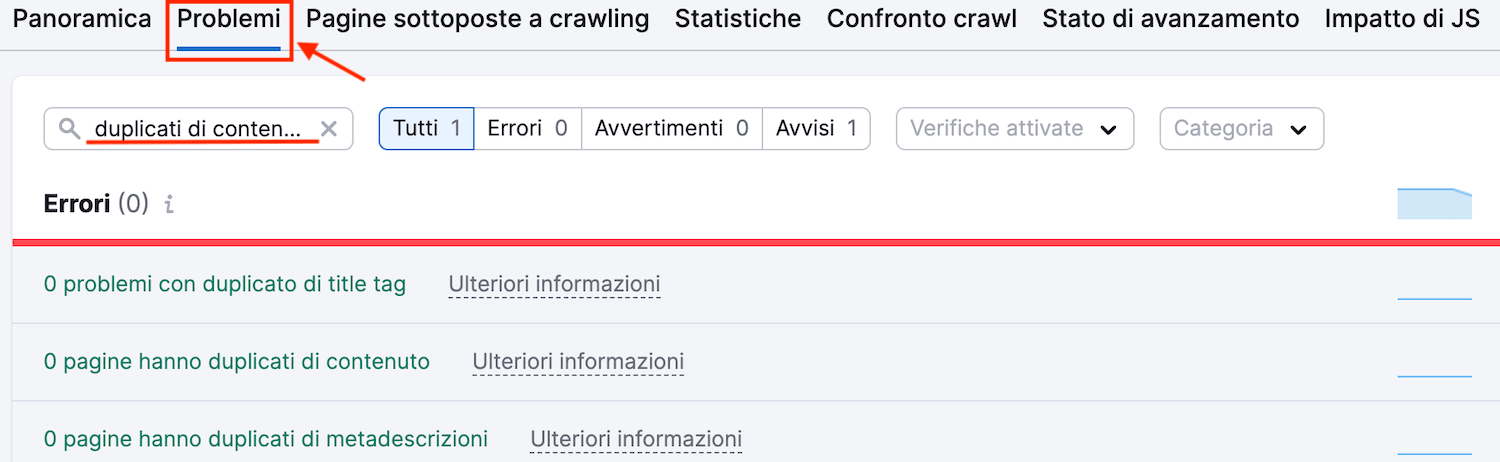

Utilizza lo strumento Site Audit di Semrush per verificare la presenza di contenuti duplicati nel tuo sito.

Nella scheda "Problemi", cerca "duplicati di contenuto".

Se trovi pagine duplicate, prendi in considerazione la possibilità di raggrupparle in un'unica pagina. E fai un redirect delle pagine duplicate verso quella unica.

Oppure puoi utilizzare i tag canonici. Il tag canonical indica la pagina preferita che i motori di ricerca devono considerare per l'indicizzazione.

Strumenti per Ottimizzare Crawlability e Indicizzazione

Log File Analyzer

Il Log File Analyzer di Semrush può mostrarti come il bot del motore di ricerca di Google (Googlebot) scansiona il tuo sito. E ti aiuta a individuare eventuali errori che potrebbe incontrare durante il processo.

Inizia caricando il file di log degli accessi del tuo sito web e attendi che lo strumento lo analizzi.

Un file di log degli accessi contiene una lista di tutte le richieste che bot e utenti hanno inviato al tuo sito. Leggi il nostro manuale su dove trovare il file di log degli accessi per iniziare.

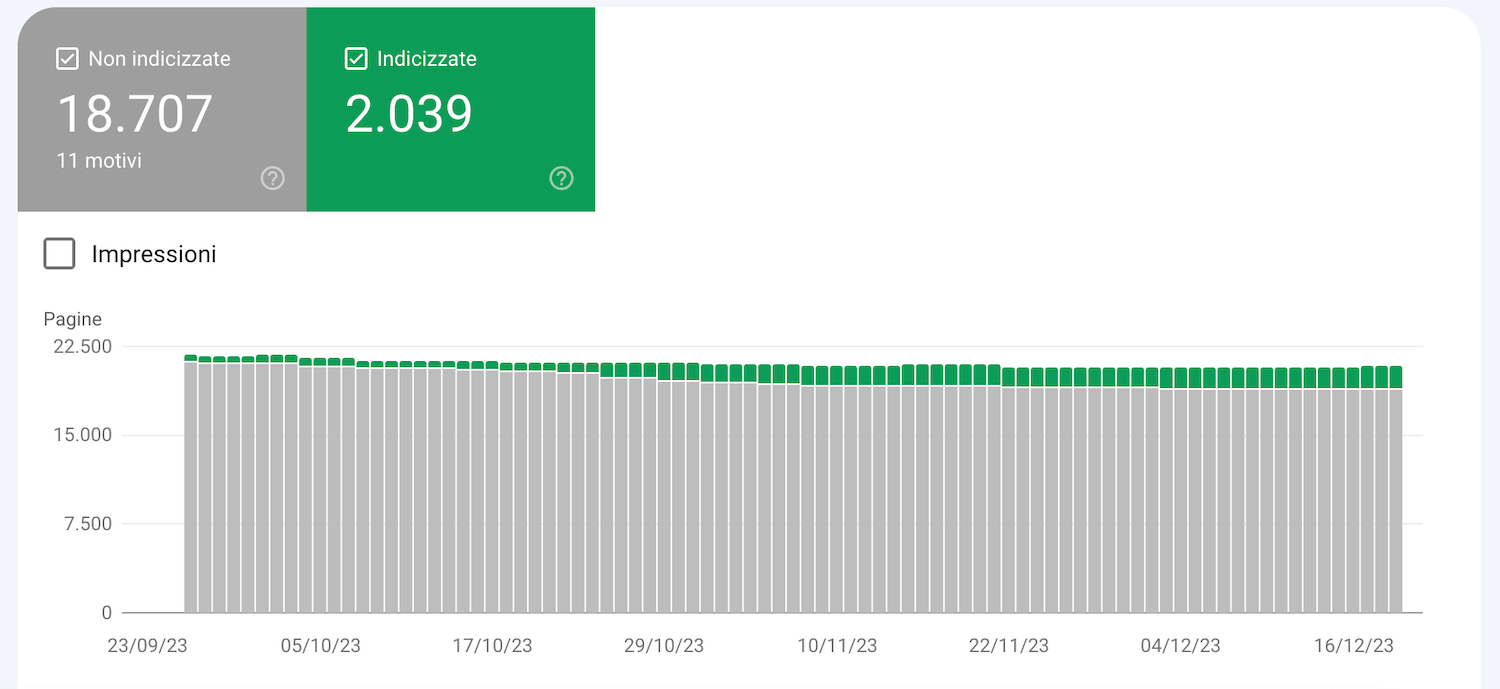

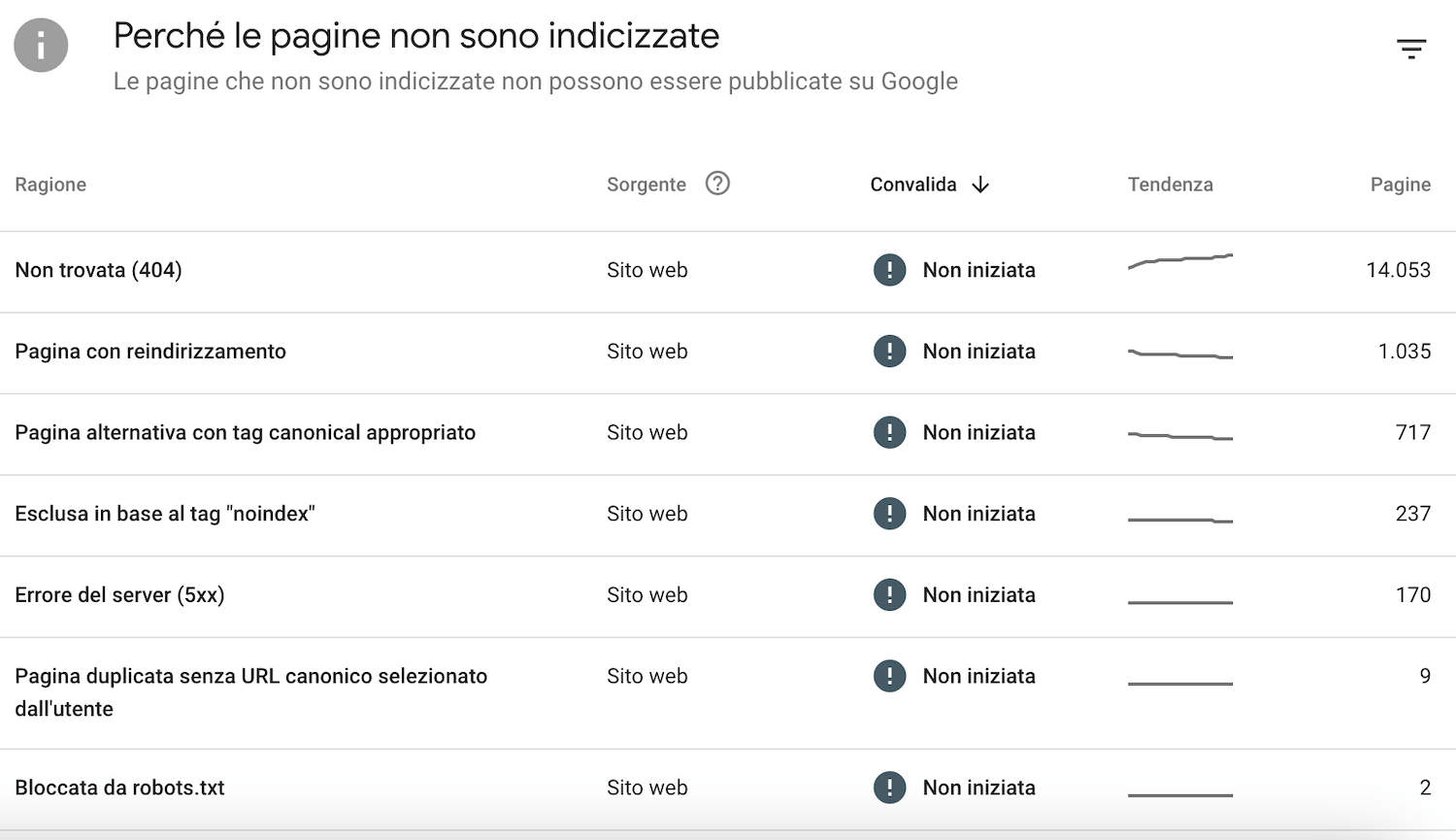

Google Search Console

Google Search Console è uno strumento gratuito di Google che ti permette di monitorare lo stato di indicizzazione del tuo sito web.

Verifica se tutte le pagine del tuo sito web sono indicizzate. E individua i motivi per cui alcune pagine non lo sono.

Site Audit

Lo strumento Site Audit è il tuo più stretto alleato quando si tratta di ottimizzare il tuo sito per la crawlability e l'indicizzazione.

Il tool riporta una serie di problemi, tra cui molti che influenzano la crawlability e l'indicizzazione di un sito web.

La Crawlability e l'Indicizzazione Sono le Tue Priorità

Il primo passo per l'ottimizzazione del tuo sito per i motori di ricerca è assicurarsi che il sito sia indicizzabile.

In caso contrario, le tue pagine non verranno visualizzate nei risultati di ricerca. E non riceverai traffico organico.

Lo strumento Site Audit e il Log File Analyzer possono aiutarti a trovare e risolvere i problemi di crawlability e indicizzazione.

Registrati gratuitamente per provarli.