Proprio come i CEO hanno i loro assistenti e Babbo Natale ha i suoi elfi, Google (insieme ad altri motori di ricerca) ha i suoi crawler per i siti web.

I crawler dei siti Web (o web crawler) potrebbero sembrare inquietanti, esseri misteriosi che circolano nel world wide web: cosa fanno esattamente?

In questa guida esamineremo cosa sono i crawler web, come li utilizzano i motori di ricerca e come possono essere utili ai proprietari di siti web.

Ti spiegheremo anche come utilizzare il nostro crawler di siti Web gratuito, lo strumento Site Audit, per scoprire cosa i crawler Web potrebbero trovare sul tuo sito e come puoi migliorare le tue prestazioni online di conseguenza.

Che cos'è un crawler Web e cosa fa?

Un web crawler è un bot di Internet, noto anche come web spider, indicizzatore automatico o web robot, che esegue la scansione sistematica del Web. Questi bot sono in un certo senso gli archivisti e i bibliotecari di Internet.

Raccolgono e scaricano informazioni e contenuti, che vengono quindi indicizzati e catalogati nelle SERP, in modo che possano essere visualizzati dagli utenti in ordine di rilevanza.

È così che un motore di ricerca come Google è in grado di rispondere rapidamente alle query di ricerca degli utenti con esattamente ciò che stanno cercando: applicando il suo algoritmo di ricerca ai dati del web crawler.

Questo significa che la crawlability, ovvero la scansionalità da parte dei bot, è un attributo chiave delle prestazioni del tuo sito web.

Come funzionano i crawler Web?

Per trovare le informazioni più affidabili e pertinenti, un bot inizierà con una certa selezione di pagine web. Cercherà (o scansionerà) questi dati, quindi seguirà i collegamenti menzionati in essi raggiungendo altre pagine, dove farà di nuovo la stessa cosa.

Alla fine, i crawler elaborano centinaia di migliaia di pagine, le cui informazioni hanno il potenziale per rispondere alla tua query di ricerca.

Il passo successivo per i motori di ricerca come Google è classificare tutte le pagine in base a fattori specifici per presentare agli utenti solo i contenuti migliori, più affidabili, più accurati e più interessanti.

I fattori che influenzano l'algoritmo e il processo di ranking di Google sono numerosi e in continua evoluzione. Alcuni sono più comunemente noti (parole chiave, posizione delle parole chiave, struttura dei link interni e link esterni, ecc.). Altri sono più complessi da individuare come, ad esempio, la qualità complessiva del sito web.

Fondamentalmente, quando parliamo di quanto sia scansionabile il tuo sito web, in realtà stiamo valutando quanto sia facile per i web bot scansionare il tuo sito per raccogliere informazioni e contenuti. Più chiare sono la struttura e la navigazione del tuo sito per la scansione, più è probabile che ti posizionerai in alto nelle SERP.

Web crawler e crawlability completano il cerchio con la SEO.

Come utilizza Semrush i web crawler

I crawler dei siti Web non sono solo uno strumento segreto dei motori di ricerca. Anche su Semrush utilizziamo i web crawler. Lo facciamo per due ragioni fondamentali:

- Per costruire e mantenere aggiornato il nostro database di backlink

- Per aiutarti ad analizzare lo stato di salute del tuo sito

Il nostro database di backlink è una parte enorme di ciò che usiamo per rafforzare i nostri strumenti. I nostri crawler cercano regolarmente sul Web nuovi backlink per consentirci di aggiornare i nostri risultati.

Grazie a questo, puoi studiare i backlink del tuo sito tramite lo strumento Backlink Audit e controllare i profili backlink dei tuoi concorrenti tramite il nostro strumento Analisi backlink.

Fondamentalmente, puoi tenere d'occhio i link che i tuoi concorrenti creano e distruggono e assicurarti che i tuoi backlink siano sani.

La seconda ragione per cui usiamo i web crawler è per il nostro strumento Site Audit. Site Audit è un potente crawler di siti Web che analizza e classifica i contenuti del tuo sito per consentirti di verificarne lo stato di salute.

Quando esegui un audit del sito tramite Semrush, lo strumento scansiona il web per evidenziare eventuali colli di bottiglia o errori, rendendo più facile fare cambiamenti e ottimizzare immediatamente il tuo sito web. È un modo semplicissimo per scansionare un sito Web.

Perché dovresti usare Site Audit di Semrush per scansionare il tuo sito

Usando lo strumento Site Audit, chiedi ai nostri crawler di accedere a un sito. I crawler restituiranno quindi un elenco di problemi, mostrando esattamente dove un determinato sito Web deve migliorare per ottenere risultati SEO più soddisfacenti.

Ci sono oltre 120 problemi che puoi controllare, tra cui:

- contenuti duplicati

- link rotti

- Implementazione HTTPS

- crawlability (sì, possiamo dirti quanto è facile per i crawler accedere al tuo sito web!)

- indexability.

L'audit richiede solo pochi minuti e lo strumento dispone di un'interfaccia utente facile da usare, quindi non devi preoccuparti di perdere ore per ottenere solo un enorme documento di dati illeggibili.

Quali sono i vantaggi per te della scansione del sito Web?

Ma perché è così importante controllare queste cose? Analizziamo i vantaggi di alcuni di questi controlli.

Crawlability

Non dovrebbe sorprendere il fatto che il controllo della scansionabilità sia il più rilevante. I nostri web crawler possono dirti esattamente quanto sia facile per i bot di Google navigare nel tuo sito e accedere alle tue informazioni.

Imparerai come ripulire la struttura del tuo sito e organizzare i tuoi contenuti, concentrandoti su sitemap, robots.txt, link interni e struttura dell'URL.

A volte alcune pagine del tuo sito non possono essere scansionate. Ci sono molte ragioni per cui questo potrebbe accadere. Una potrebbe essere una risposta lenta del server (più di 5 secondi) o un rifiuto categorico di accesso dal server. La cosa più importante è che una volta che sai di avere un problema, puoi iniziare a risolverlo.

Implementazione HTTPS

Questa è una parte molto importante dell'audit se vuoi spostare il tuo sito web da HTTP a HTTPS. Ti aiuteremo a evitare alcuni degli errori più comuni che i proprietari di siti commettono in quest'area eseguendo la scansione alla ricerca di certificati, reindirizzamenti, canonical, crittografia e altro ancora. I nostri web crawler lo renderanno il più chiaro possibile.

Link rotti

I collegamenti interrotti sono una classica causa di malcontento degli utenti. Troppi link interrotti potrebbero persino far cadere il tuo posizionamento nelle SERP perché possono portare i crawler a credere che il tuo sito web sia mal gestito o codificato.

I nostri crawler troveranno questi collegamenti interrotti e li risolveranno prima che sia troppo tardi. Le soluzioni, in sé, sono semplici: rimuovi il collegamento, lo sostituisci o contatti il proprietario del sito Web a cui ti stai collegando e gli segnali il problema.

Contenuti duplicati

I contenuti duplicati possono causare grossi problemi alla tua SEO. Nel migliore dei casi, i motori di ricerca potrebbero scegliere una delle tue pagine duplicate da classificare, spingendo fuori l'altra. Nel peggiore, i motori di ricerca potrebbero presumere che tu stia cercando di manipolare le SERP e declassare o bannare in toto il tuo sito web.

Un site audit può aiutarti a stroncare il problema sul nascere. I nostri web crawler troveranno il contenuto duplicato sul tuo sito e te lo mostreranno in una lista ordinata.

Potrai quindi utilizzare il tuo metodo preferito per risolvere il problema: informare i motori di ricerca aggiungendo un link rel=”canonical” alla pagina corretta, utilizzare un redirect 301 o modificare il contenuto sulle pagine implicate.

Puoi scoprire di più su questi problemi nella nostra guida su come risolvere i problemi di scansione.

Come impostare un crawler web usando Site Audit di Semrush

Configurare un crawler di siti Web tramite Site Audit di Semrush è così semplice che richiede solo sei passaggi.

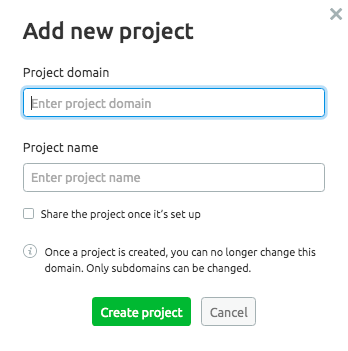

Prima di iniziare, assicurati di aver impostato il tuo progetto. Puoi farlo facilmente dalla tua dashboard. In alternativa, prendi un progetto che hai già avviato ma per il quale non hai ancora effettuato un audit del sito.

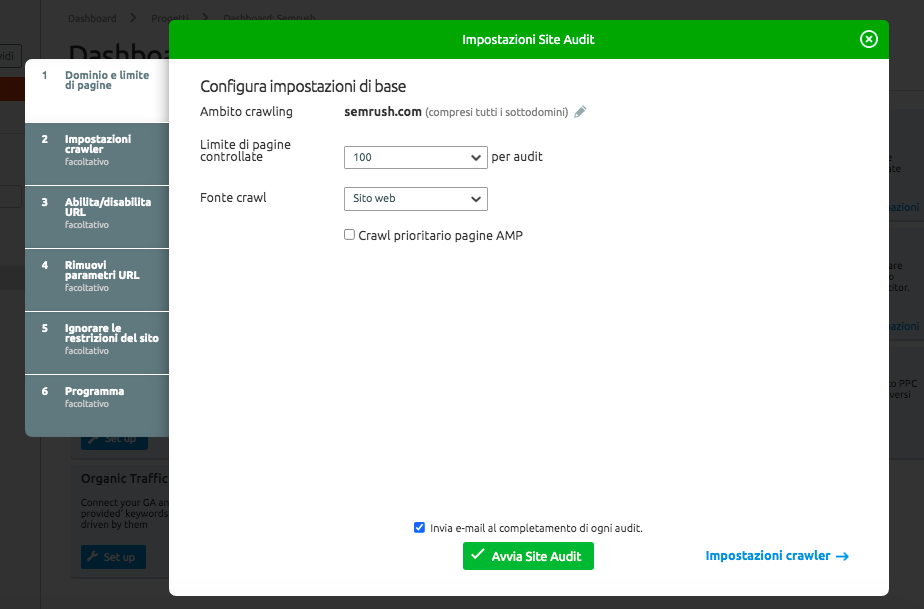

Passo 1: Impostazioni di base

Una volta stabilito il tuo progetto, è il momento del primo passaggio: configurare le impostazioni di base.

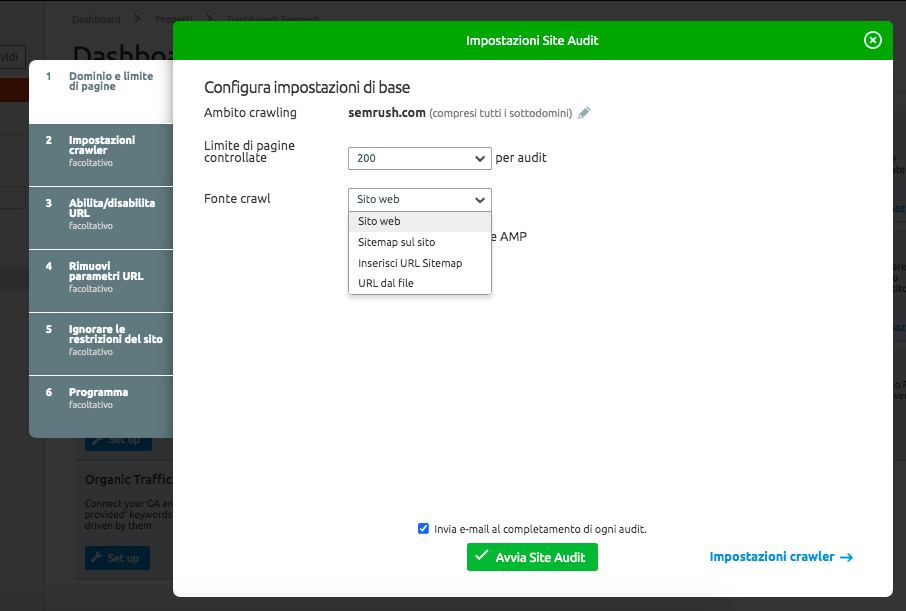

Innanzitutto, imposta l'ambito della scansione. Qualunque sia il dominio, il sottodominio o la sottocartella specifica che vuoi scansionare, puoi inserirlo qui nella sezione "Ambito crawling". Come mostrato di seguito, se inserisci un dominio, puoi anche scegliere se desideri scansionarne anche tutti i sottodomini.

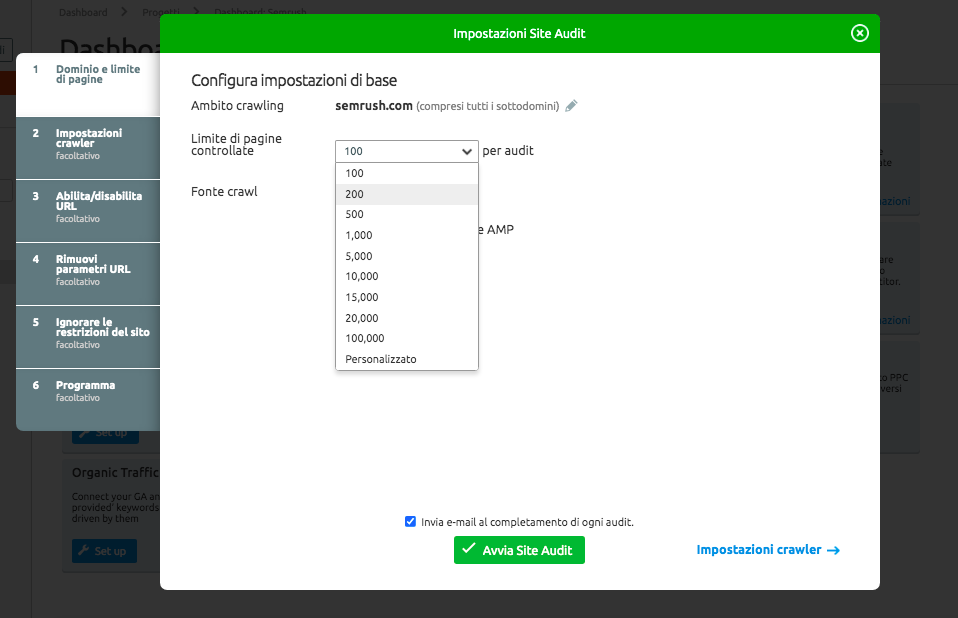

Quindi imposta il numero massimo di pagine che vuoi controllare nell'audit. Più pagine scansioni, più accurato sarà il tuo audit, ma devi anche tenere in considerazione il tuo impegno e il tuo livello di abilità. Qual è il livello della tua sottoscrizione? Con che frequenza realizzerai un nuovo audit?

A chi ha una sottoscrizione Pro consigliamo di eseguire la scansione fino a 20.000 pagine per audit. A chi ha una sottoscrizione Guru consigliamo lo stesso, 20.000 pagine per audit e per gli utenti Bussiness raccomandiamo 100.000 pagine per audit. Trova quello che fa per te.

Scegli la tua fonte di scansione. Questo è ciò che decide come il nostro bot scansionerà il tuo sito Web e troverà le pagine da controllare.

Come mostrato, ci sono quattro opzioni.

- Sito Web: con questa opzione, scansioneremo il sito come GoogleBot (tramite un algoritmo di ricerca in ampiezza), navigando tra i tuoi link (a partire dalla tua home page). È una buona scelta se sei interessato a scansionare solo le pagine più accessibili che un sito ha da offrire dalla sua home page.

- Sitemap sul sito: se scegli questa opzione, scansioneremo solo gli URL trovati nella sitemap dal file robots.txt.

- Inserisci URL sitemap: è simile alle sitemap sul sito, ma in questo caso puoi inserire l'URL della tua sitemap, rendendo il tuo controllo un po' più specifico.

- URL dal file: qui è dove puoi essere davvero specifico e concentrarti esattamente sulle pagine che vuoi controllare. Devi solo aver salvato gli URL come file .csv o .txt sul tuo computer e potrai caricarli direttamente su Semrush.

Questa opzione è ottima quando non hai bisogno di una panoramica generale. Ad esempio, quando hai apportato modifiche puntuali a pagine specifiche e vuoi solo vedere come stanno andando. Questo può farti risparmiare un po' di crawl budget e darti le informazioni che vuoi veramente vedere.

Passo 2: Impostazioni del crawler

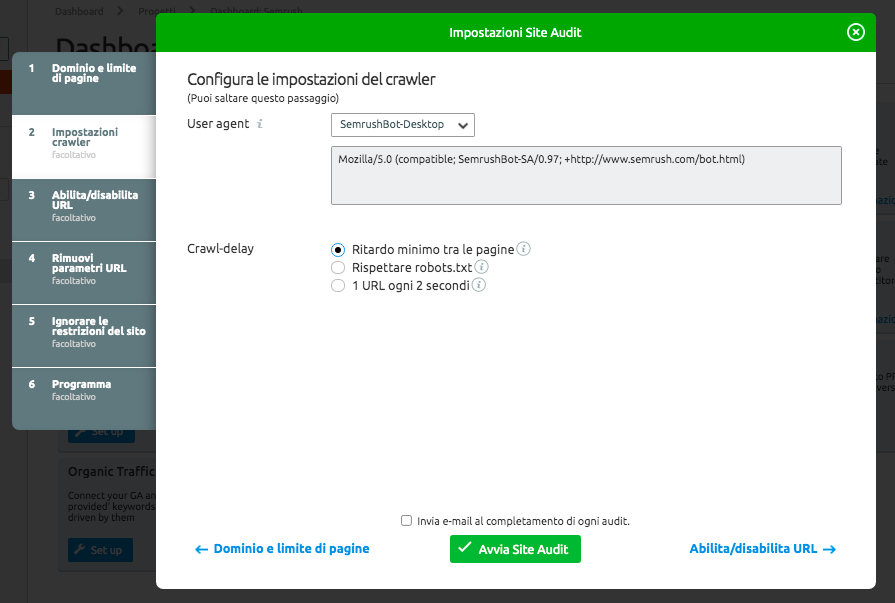

Ora devi decidere il tipo di bot che scansionerà il tuo sito. Ci sono quattro possibili combinazioni, a seconda che tu scelga la versione mobile o desktop di SemrushBot o GoogleBot.

Quindi imposta il Crawl-Delay. Decidi tra: Ritardo minimo tra le pagine, Rispettare robots.txt o 1 URL ogni 2 secondi.

- Scegli "Ritardo minimo" per consentire al bot di eseguire la scansione alla sua velocità normale. Per SemrushBot, ciò significa che lascerà circa un secondo prima di iniziare la scansione della pagina successiva.

- "Rispettare robots.txt" è l'ideale quando hai un file robots.txt sul tuo sito e di conseguenza hai bisogno di un ritardo di scansione specifico.

- Se temi che il tuo sito web venga rallentato dal nostro crawler o non disponi ancora di una direttiva di scansione, probabilmente vorrai scegliere "1 URL ogni 2 secondi". Ciò può significare che l'audit richiederà più tempo, ma non peggiorerà l'esperienza dell'utente durante l'audit.

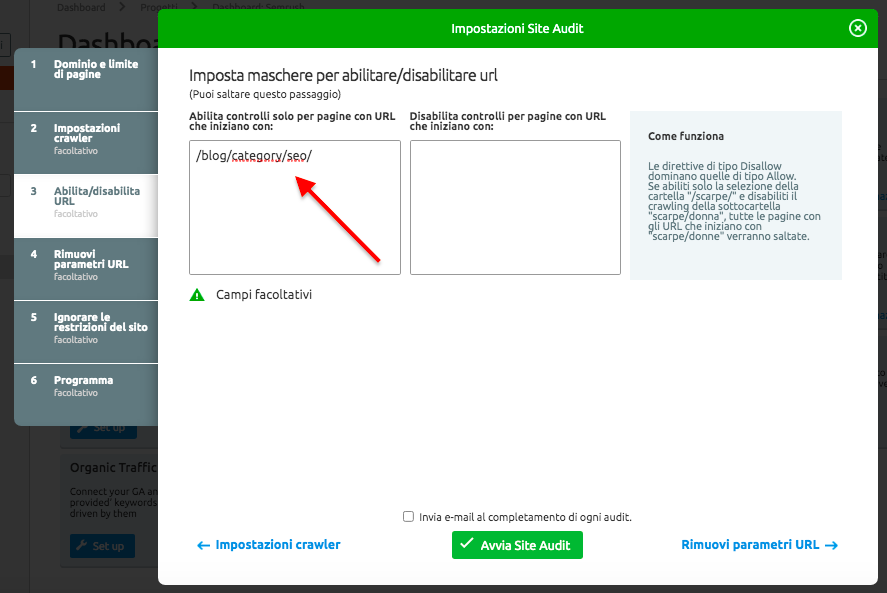

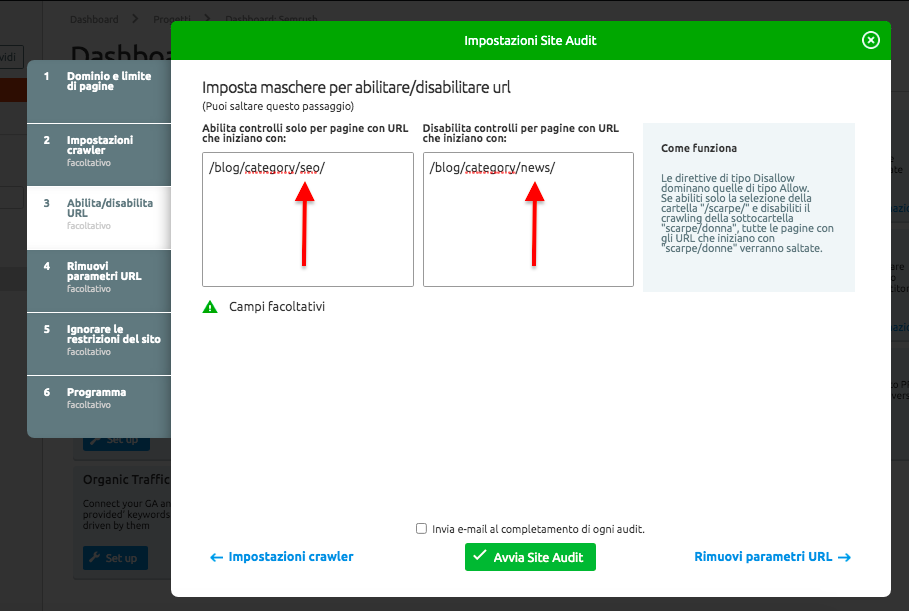

Passo 3: Abilita/disabilita URL

Qui è dove puoi davvero entrare nella personalizzazione del tuo audit, decidendo quali sottocartelle vuoi che vengano assolutamente scansionate e quali non vuoi che lo siano.

Per farlo correttamente, devi includere tutto quello che compare nell'URL dopo il TLD. Le sottocartelle che vuoi assolutamente che vengano scansionate vanno nella casella a sinistra:

E quelle che non vuoi che vengano scansionate vanno nella casella a destra:

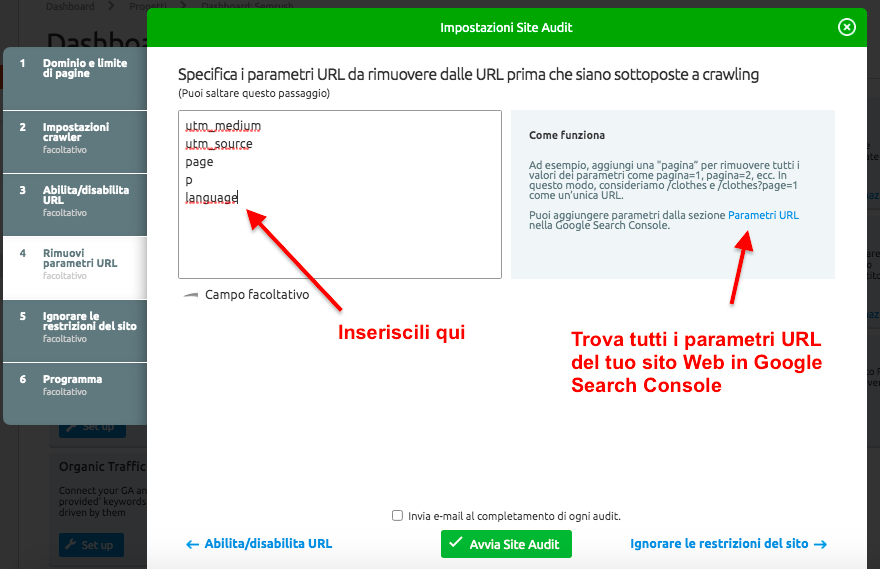

Passo 4: Rimuovi parametri URL

Questo passaggio ci aiuta ad assicurarci che il tuo crawl budget non venga sprecato scansionando due volte la stessa pagina. È sufficiente specificare i parametri URL che usi sul tuo sito per rimuoverli prima della scansione.

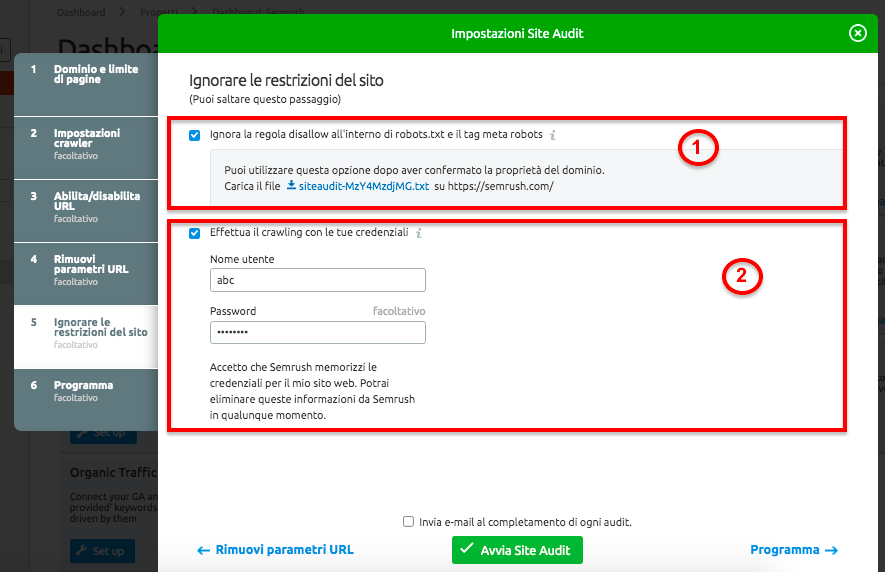

Passo 5: Ignorare le restrizioni del sito

Questo è perfetto quando hai bisogno di una piccola soluzione alternativa. Supponiamo, ad esempio, che il tuo sito Web sia ancora in pre-produzione o che sia nascosto per l'autenticazione di accesso di base. Se pensi che questo significhi che non possiamo eseguire un audit per te, ti sbagli.

Hai due scelte per aggirare questo problema e assicurarti che il tuo audit sia attivo e funzionante.

- L'opzione 1 consiste nell'ignorare il disallow nel robots.txt e tramite il meta tag robots, che comporta il caricamento del file .txt, che ti forniremo, nella cartella principale del tuo sito web.

- L'opzione 2 è eseguire la scansione con le tue credenziali. In questo caso, tutto quello che devi fare è inserire il nome utente e la password che useresti per accedere alla parte nascosta del tuo sito web. SemrushBot utilizzerà queste informazioni per eseguire l'audit.

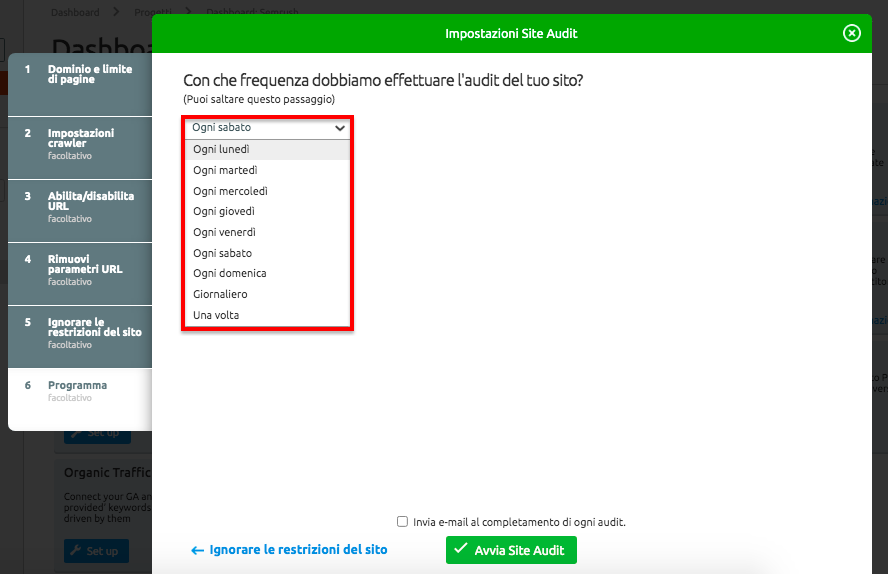

Passo 6: Programma

Il passaggio finale è dirci con quale frequenza vuoi che effettuiamo l'audit del tuo sito. Potrebbe essere ogni settimana, ogni giorno o solo una volta. Realizzare audit regolari è sicuramente consigliabile per tenere sempre sotto controllo lo stato di salute del tuo sito.

E questo è quanto! Hai imparato come eseguire la scansione di un sito con lo strumento Site Audit.

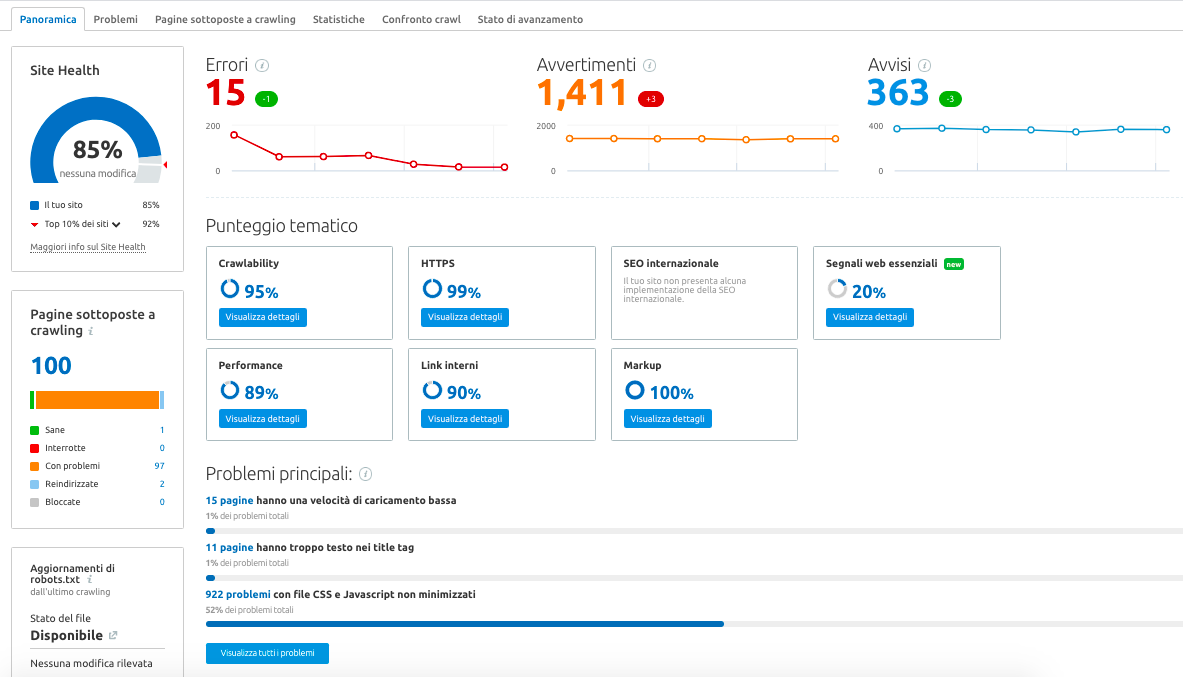

Esaminare i dati del crawler Web con Semrush

Tutti i dati sulle tue pagine web raccolti durante le scansioni vengono registrati e salvati nella sezione Site Audit del tuo progetto.

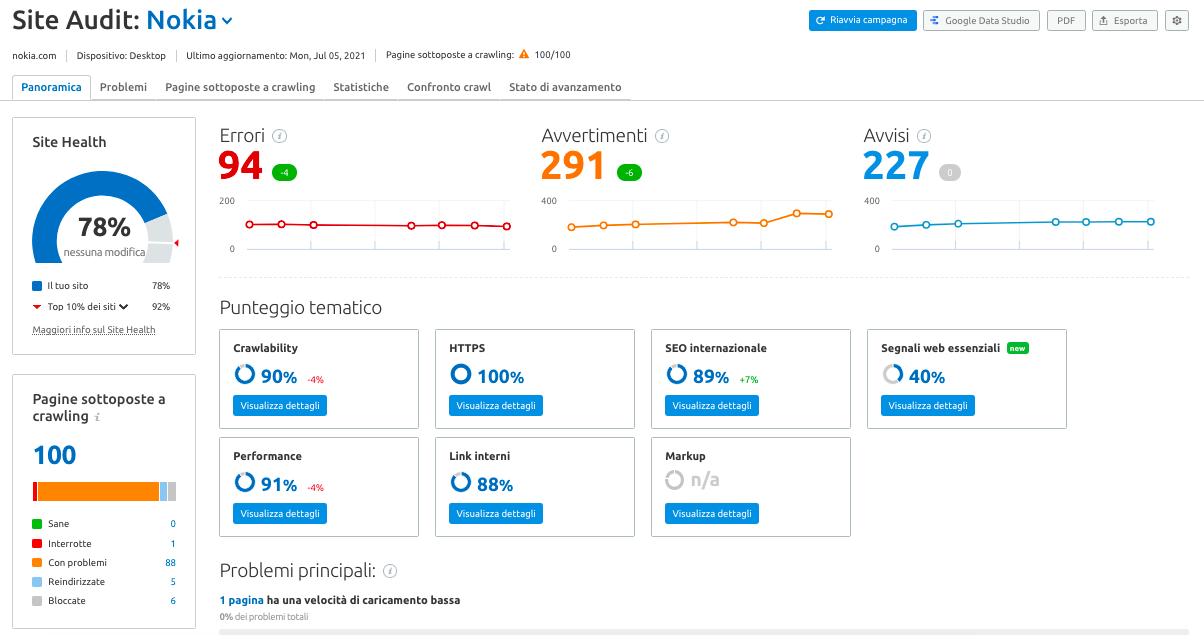

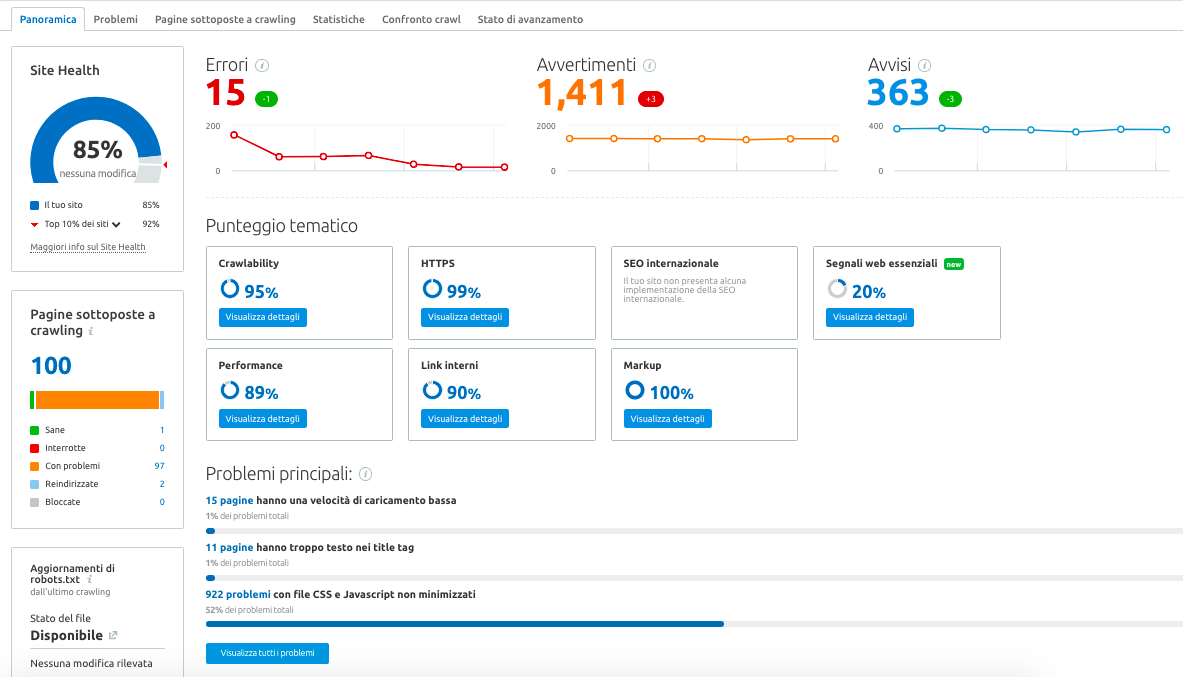

Qui puoi trovare il tuo punteggio di salute del sito:

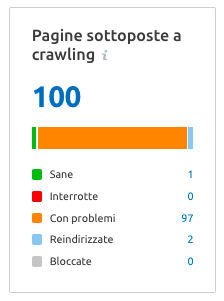

Controlla anche il numero totale di pagine sottoposte a crawling che sono "sane" "interrotte" e "con problemi". Questa visualizzazione praticamente dimezza il tempo necessario per identificare i problemi e risolverli.

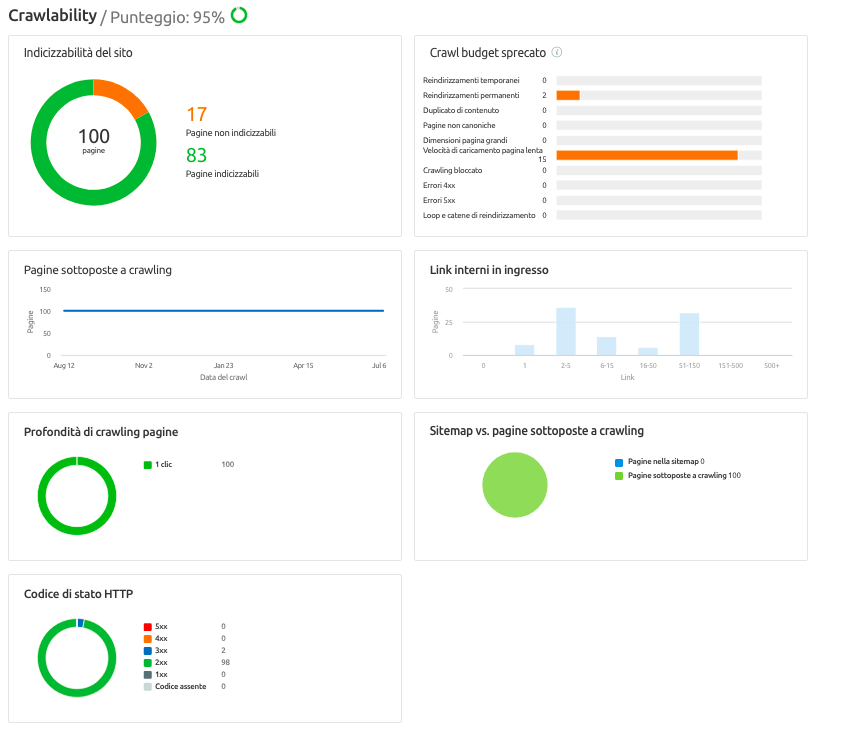

Infine, qui troverai anche la nostra valutazione di quanto sia facile scansionare le tue pagine:

Entrando nella sezione Crawlability, potrai dare un'occhiata ancora più da vicino al tuo crawl budget, alla profondità di scansione, alla sitemap rispetto alle pagine scansionate, all'indicizzabilità del sito e altro ancora.

Ora sai come impostare il web crawler dell'audit del tuo sito e dove trovare i dati che abbiamo raccolto solo per te.

Ricorda: migliorando la tua crawlability, ti assicuri che i motori di ricerca comprendano il tuo sito web e il suo contenuto. Aiutare i motori di ricerca a scansionare il tuo sito Web ti permetterà di posizionarti più in alto e scalare lentamente le SERP.