Alcuni contenuti del tuo sito non sono necessari per l'indicizzazione dei motori di ricerca. Per impedire l'indicizzazione di alcune pagine, puoi utilizzare un meta tag robots o x-robots-tag.

Tuttavia, non è raro che i meta tag robots e robots.txt vengano utilizzati in modo errato. Ciò si traduce in direttive disordinate e in conflitto che non raggiungono il risultato desiderato: impedire l'indicizzazione di una pagina.

In questa guida vogliamo aiutarti a capire come utilizzare i meta tag robots e x-robots-tag per controllare l'indicizzazione del contenuto del tuo sito web e per individuare gli errori più comunemente commessi.

Nello specifico, vedremo:

Che cos'è un Meta tag robots?

Un Meta tag robots, noto anche come robots tag, è un pezzo di codice HTML che viene inserito nella sezione <head> </head> di una pagina web e utilizzato per controllare il modo in cui i motori di ricerca scansionano e indicizzano l'URL.

Ecco come appare un meta tag robots nel codice sorgente di una pagina:

<meta name="robots" content="noindex" />Questi tag sono specifici della pagina e ti consentono di istruire i motori di ricerca su come desideri che gestiscano la pagina e se includerla o meno nell'indice.

A cosa servono i Meta tag robots?

I Meta tag robots vengono utilizzati per controllare il modo in cui Google indicizza i contenuti della tua pagina web. Questo include decisioni come:

- Se includere o meno una pagina nei risultati di ricerca

- Se seguire o meno i link su una pagina (anche se è bloccata per l'indicizzazione)

- La richiesta di non indicizzare le immagini su una pagina

- La richiesta di non mostrare i risultati memorizzati nella cache della pagina web nelle SERP

- La richiesta di non mostrare uno snippet (meta description) per la pagina nelle SERP

Per capire come utilizzare il meta tag robots, dobbiamo esaminare i diversi attributi e direttive. Condivideremo anche esempi di codice che puoi prendere e inserire nell'header della tua pagina per richiedere ai motori di ricerca di indicizzare la tua pagina in un certo modo.

Comprendere gli attributi e le direttive dei Meta tag robots

Usare i meta tag robots è abbastanza semplice, una volta capito come impostare i due attributi: name e content. Entrambi questi attributi sono obbligatori, quindi è necessario impostare un valore per ciascuno.

Diamo un'occhiata a questi attributi in modo più dettagliato.

Name

L'attributo name controlla quali crawler e bot (user-agent, denominati anche UA) devono seguire le istruzioni contenute nel meta tag robots.

Per istruire tutti i crawler a seguire le istruzioni, utilizza:

name="robots"

Nella maggior parte degli scenari, ti consigliamo di utilizzarlo come predefinito, ma puoi usare tutti i diversi meta tag robots di cui hai bisogno per specificare le istruzioni per i diversi crawler.

Quando si vuole istruire diversi crawler, si devono semplicemente utilizzare più tag:

<meta name="googlebot" content="noindex">

<meta name="googlebot-news" content="nosnippet">Esistono centinaia di user-agent diversi. I più comuni sono:

- Google: Googlebot (puoi vedere un elenco completo dei crawler di Googlequi)

- Bing: Bingbot (puoi vedere un elenco completo dei crawler di Bingqui)

- DuckDuckGo: DuckDuckBot

- Baidu: Baiduspider

- Yandex: YandexBot

Content

L'attributo content serve per fornire le istruzioni allo user-agent specificato.

È importante sapere che se non specifichi un meta tag robots su una pagina web, l'impostazione predefinita è indicizzare la pagina e seguire tutti i link (a meno che non abbiano un attributo rel ="nofollow" specificato inline).

Le diverse direttive che puoi utilizzare includono:

- index (includi la pagina nell'indice) [Nota: non è necessario includerlo se noindex non è specificato, si presume come index)

- noindex (non includere la pagina nell'indice o mostrarla nelle SERP)

- follow (segui i link nella pagina per scoprire altre pagine)

- nofollow (non seguire i link nella pagina)

- none (una scorciatoia per specificare noindex, nofollow)

- all (una scorciatoia per specificare index, follow)

- noimageindex (non indicizzare le immagini sulla pagina)

- noarchive (non mostrare una versione cache della pagina nelle SERP)

- nocache (questo è lo stesso di noarchive, ma solo per MSN)

- nositelinkssearchbox (non mostrare una casella di ricerca dei sitelink per il tuo sito nelle SERP)

- nopagereadaloud (non consentire ai servizi vocali di leggere la tua pagina ad alta voce)

- notranslate (non mostrare le traduzioni della pagina nelle SERP)

- unavailable_after (specificare un tempo dopo il quale la pagina non deve essere indicizzata)

Puoi vedere un elenco completo delle direttive supportate da Google qui e quelle supportate da Bingqui.

Esempi di codice dei Meta tag robots

Se stai cercando esempi di meta tag robots che puoi usare per controllare il modo in cui i motori di ricerca scansionano e indicizzano le tue pagine web, puoi utilizzare quanto segue, ovvero gli scenari di utilizzo più comuni:

Non indicizzare la pagina ma seguire i link ad altre pagine:

<meta name="robots" content="noindex, follow" />Non indicizzare la pagina e non seguire i link ad altre pagine:

<meta name="robots" content="none" />Indicizzare la pagina ma non seguire i link ad altre pagine:

<meta name="robots" content="nofollow" />Non mostrare una copia della cache della pagina sulle SERP:

<meta name="robots" content="noarchive" />Non indicizzare le immagini su una pagina:

<meta name="robots" content="noimageindex" /Non mostrare la pagina nelle SERP dopo una data/ora specificata:

<meta name="robots" content="unavailable_after: Friday, 01-Jan-21 12:59:59 ET" />Se necessario, puoi combinare le direttive in un unico tag, separandole con virgole.

Ad esempio, supponiamo che tu voglia che nessuno dei link in una pagina venga seguito e che tu voglia anche impedire l'indicizzazione delle immagini. Usa:

<meta name="robots" content="nofollow, noimageindex" /Usare i Meta tag robots per controllare gli snippet

Sebbene i meta tag robots siano più comunemente usati per controllare se una pagina viene indicizzata o meno e se i link su quella pagina vengono scansionati o meno dai motori di ricerca, possono anche essere usati per controllare gli snippet sulle SERP.

In merito a questa novità introdotta nel settembre 2019, Google disse che i webmaster erano in grado di utilizzare "una serie di metodi che consentono una configurazione più granulare dei contenuti mostrati per le loro pagine".

Questi si presentano sotto forma dei seguenti meta tag robot:

- nosnippet (non mostrare uno snippet/meta description per la pagina nelle SERP)

- max-snippet:[number] (specifica la lunghezza massima del testo di uno snippet in caratteri)

- max-video-preview:[number] (specifica la durata massima di un'anteprima video in secondi)

- max-image-preview:[setting] (specifica la dimensione massima dell'anteprima di un'immagine scegliendo "none", "standard" o "large")

Usa i codici seguenti per controllare la modalità di visualizzazione degli snippet della tua pagina web:

Non mostrare snippet per una pagina nelle SERP:

<meta name="robots" content="nosnippet" />Imposta la lunghezza massima del testo di uno snippet a 150 caratteri:

<meta name="robots" content="max-snippet:150" />Imposta la durata massima di un'anteprima video a 20 secondi:

<meta name="robots" content="max-video-preview:30" />Imposta la dimensione massima dell'anteprima di un'immagine su grande:

<meta name="robots" content="max-image-preview:large" />Questi codici possono anche essere combinati per un maggiore controllo sugli snippet della tua pagina. Supponiamo che tu voglia impostare la lunghezza massima del tuo snippet a 150 caratteri e consentire anteprime di immagini di grandi dimensioni. Usa:

<meta name="robots" content="max-snippet:150, max-image-preview:large" />Se hai un pubblico in Francia, devi prestare molta attenzione a questi tag poiché la legge sul copyright francese impedisce a Google di mostrare qualsiasi snippet per il tuo sito web a meno che tu non scelga di utilizzarli.

Se non desideri porre alcuna restrizione sui tuoi snippet, puoi aggiungere quanto segue in tutto il sito nell'header della tua pagina:

<meta name="robots" content="max-snippet:-1, max-image-preview:large, max-video-preview:-1" />Che cos'è un X‑Robots-Tag?

Un modo alternativo per controllare come i motori di ricerca scansionano e indicizzano le tue pagine web consiste nell'utilizzare gli x-robots-tag anziché i meta tag robots.

Mentre l'implementazione dei meta tag robots nelle pagine HTML è relativamente semplice, x-robots-tag è più complicato. Se vuoi controllare come viene gestito il contenuto non HTML, ad esempio un PDF, dovrai utilizzare un x-robots-tag.

Questa è una risposta di intestazione HTTP, piuttosto che un tag HTML, e qualsiasi direttiva che può essere usata come meta tag robots può essere usata anche come x-robots-tag.

Ecco un esempio di come appare un x-robots-tag:

x-robots-tag: noindex, nofollow

Per usare x-robots-tag devi essere in grado di accedere all'header del tuo sito web .php, .htaccess o al file di configurazione del server. Se non hai accesso a questo, dovrai utilizzare i meta tag robots per istruire i crawler.

Quando usare X-Robots-Tag?

L'utilizzo di un x-robots-tag non è così semplice come quello di meta tag robots, ma consente di indirizzare i motori di ricerca su come indicizzare e scansionare altri tipi di file.

Usa un x-robots-tag quando:

- Devi controllare il modo in cui i motori di ricerca scansionano e indicizzano tipi di file non HTML

- Devi fornire direttive a livello globale (a livello di sito) piuttosto che a livello di pagina

Come impostare Meta tag robots e X-Robots-Tag

Impostare meta tag robots è, in genere, più semplice dell'x-robots-tag, ma l'implementazione di entrambi i metodi per controllare il modo in cui i motori di ricerca scansionano e indicizzano il tuo sito può differire a seconda del tuo CMS e/o tipo di server.

Ecco come usare i meta tag robots e x-robots-tag sulle configurazioni più comuni:

- Utilizzo dei meta tag robots nel codice HTML

- Utilizzo dei meta tag robots su WordPress

- Utilizzo dei meta tag robots su Shopify

- Utilizzo di X-Robots-Tag su un server Apache

- Utilizzo di X-Robots-Tag su un server Nginx

Utilizzo dei meta tag robots nel codice HTML

Se puoi modificare il codice HTML della tua pagina, aggiungi semplicemente i meta tag robots direttamente nella sezione <head> della pagina.

Se vuoi che i motori di ricerca non indicizzino la pagina ma che i link vengano seguiti, ad esempio, utilizza:

<meta name="robots" content="noindex, follow" />Utilizzo dei meta tag robots su WordPress

Se stai usando Yoast SEO, apri la scheda "Avanzate" nel blocco sotto l'editor della pagina.

Puoi impostare la direttiva "noindex" selezionando l'opzione No nel menu a discesa della voce "Consenti ai motori di ricerca di mostrare questa pagina nei risultati di ricerca?" o impedire che i link vengano seguiti scegliendo l'opzione No alla voce "I motori di ricerca dovrebbero seguire i link in questa pagina?".

Qualsiasi altra direttiva dovrà essere implementata nel campo "Meta robots advanced".

Se stai usando RankMath, puoi selezionare le direttive robot che desideri applicare direttamente dal tag Advanced del meta box:

Utilizzo dei meta tag robots su Shopify

Se devi implementare i meta tag robots su Shopify, dovrai farlo modificando la sezione <head> del tuo file di layout theme.liquid.

Per impostare le direttive per una pagina specifica, aggiungi il codice seguente a questo file:

{% if handle contains 'page-name' %}

<meta name="robots" content="noindex, follow">

{% endif %}Questo codice istruirà i motori di ricerca a non indicizzare/nome-pagina / ma a seguire tutti i link nella pagina.

Dovrai creare voci separate per impostare le direttive su pagine diverse.

Utilizzo di X-Robots-Tag su un server Apache

Per usare x-robots-tag su un server web Apache, aggiungi quanto segue al file .htaccess o al file httpd.config del tuo sito.

<Files ~ "\.pdf$">

Header set X-Robots-Tag "noindex, follow"

</Files>L'esempio qui sopra, imposta il tipo di file .pdf e indica ai motori di ricerca di non indicizzare il file ma di seguire eventuali link su di esso.

Utilizzo di X-Robots-Tag su un server Nginx

Se stai usando un server Nginx, aggiungi quanto segue al file .conf del tuo sito:

location ~* \.pdf$ {

add_header X-Robots-Tag "noindex, follow";

}Questo applicherà un attributo noindex e farà seguire dai crawler tutti i link su un file .pdf.

Errori comuni con i Meta robots

Non è raro che vengano commessi errori quando si istruiscono i motori di ricerca su come eseguire la scansione e l'indicizzazione di una pagina Web. I seguenti sono i più comuni:

- Direttive sui meta robots su una pagina bloccata da Robots.txt

- Aggiunta di direttive sui robots al file Robots.txt

- Rimozione di pagine con una direttiva Noindex dalle Sitemap

- Blocco accidentale dei motori di ricerca nella scansione di un intero sito

Direttive sui meta robots su una pagina bloccata da Robots.txt

Se l'accesso a una pagina non è consentito nel file robots.txt, i robot dei motori di ricerca non saranno in grado di scansionare la pagina e prendere nota di eventuali direttive inserite nei meta tag robots o in un x-robots-tag.

Assicurati che tutte le pagine che istruiscono gli user-agent possano essere scansionate.

Se una pagina non è mai stata indicizzata, l'uso di disallow nel file robots.txt dovrebbe essere sufficiente per impedire che venga visualizzata nei risultati di ricerca, ma si consiglia comunque di aggiungere un meta tag robots.

Aggiunta di direttive sui robots al file Robots.txt

Sebbene non sia mai stato ufficialmente supportato da Google, era possibile aggiungere una direttiva noindex al file robots.txt del tuo sito e ottenere l'effetto desiderato.

Non è più così ed è stato confermato da Google che dal 2019 questa misura non è più efficace.

Rimozione di pagine con una direttiva Noindex dalle Sitemap

Se stai tentando di rimuovere una pagina dall'indice utilizzando un'istruzione noindex, lascia la pagina nella sitemap del tuo sito finché ciò non si è verificato.

La rimozione della pagina prima che questa sia stata deindicizzata può causare ritardi nell'operazione.

Blocco accidentale dei motori di ricerca nella scansione di un intero sito

Purtroppo, non è raro che le direttive dei robot utilizzate in un ambiente di testing vengano accidentalmente mantenute quando il sito si sposta su un server live. I risultati possono essere disastrosi.

Prima di spostare qualsiasi sito da una piattaforma di test a un ambiente live, ricontrolla che tutte le direttive sui robot in vigore siano corrette.

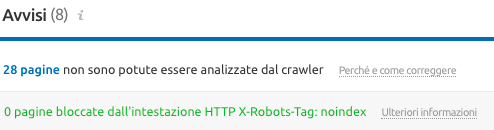

Puoi usare lo strumento Site Audit di Semrush prima di migrare a una piattaforma live per trovare le pagine che vengono bloccate con meta tag robots o un x-robots-tag.

Prendendoti del tempo per capire le diverse direttive e come usarle puoi prevenire errori SEO tecnici. Avere il controllo su come le tue pagine vengono scansionate e indicizzate può aiutare a mantenere le pagine indesiderate fuori dalle SERP, impedire ai motori di ricerca di seguire link non necessari e darti il controllo su come vengono visualizzati gli snippet del tuo sito, tra le altre cose. Inizia a configurare i meta tag robots e gli x-robots-tag per assicurarti che il tuo sito funzioni senza problemi!