Perché pagine funzionanti del mio sito web risultano rotte?

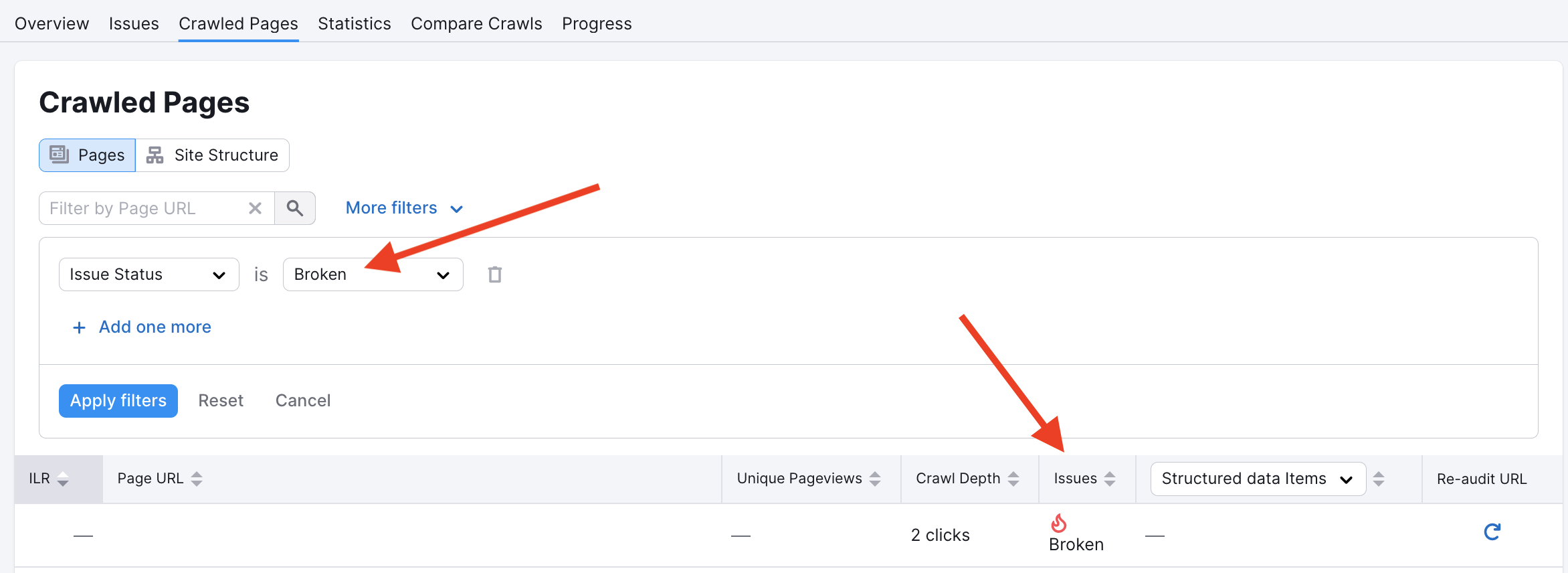

Può capitare che Site Audit mostri alcune delle tue pagine interne come rotte ma in realtà sono ancora perfettamente funzionanti. Anche se questo non accade spesso, per alcuni utenti può essere fonte di confusione.

In genere, quando ciò accade è a causa di un falso positivo. I quattro motivi più comuni per cui si verifica una lettura falso positiva sono:

- Il nostro crawler di Site Audit potrebbe essere stato bloccato per alcune pagine in robots.txt o da tag noindex

- I provider di hosting potrebbero bloccare i bot di Semrush perché ritengono che si tratti di un attacco DDoS (un numero massiccio di accessi in un breve periodo di tempo)

- Al momento della nuova scansione della campagna, non è stato possibile risolvere il dominio tramite DNS

- La cache del server del sito web contiene dati vecchi e li fornisce ai bot crawler

Se ritieni che il problema sia dovuto a un crawler, puoi scoprire come risolvere i problemi del tuo robots.txt in questo articolo.

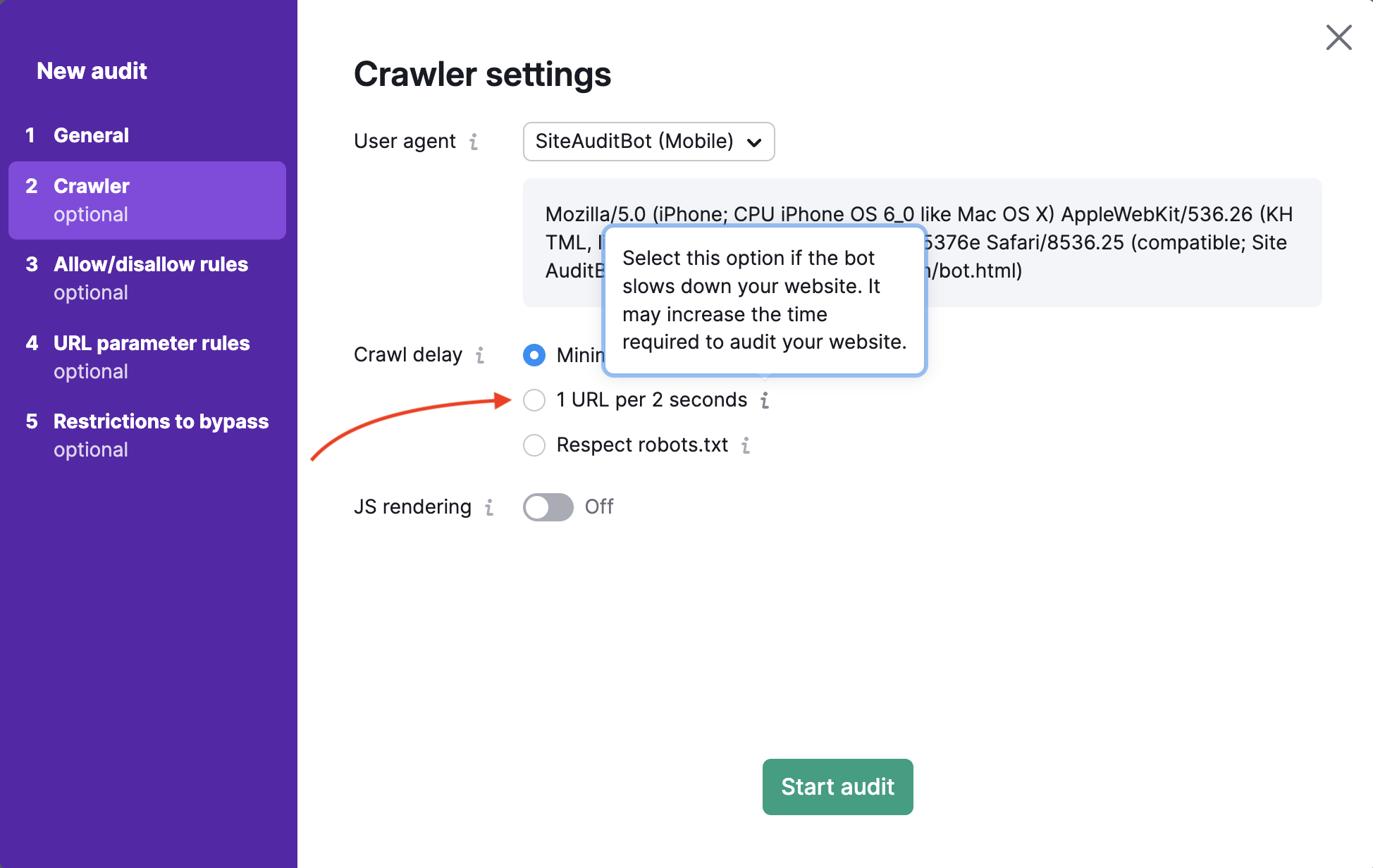

Puoi anche abbassare la velocità di scansione per evitare un numero elevato di accessi alle tue pagine contemporaneamente. Per questo motivo potresti vedere questa pagina come una pagina funzionante, il che è corretto, mentre il nostro bot non è riuscito a farlo e ha riportato il falso positivo.

Per risolvere il problema della cache del server, prova a cancellarla e a riavviare Site Audit: in questo modo otterrai risultati aggiornati che includono tutte le correzioni effettuate.