I parametri URL e il loro impatto sulla SEO

I parametri URL sono parte integrante delle strutture degli URL. Sebbene siano una risorsa inestimabile nelle mani di professionisti SEO esperti, queste query string spesso rappresentano una seria sfida per il posizionamento del tuo sito web.

In questa guida troverai i problemi SEO più comuni a cui prestare attenzione quando lavori con i parametri URL.

Cosa sono i parametri URL?

I parametri URL (noti anche come "query string" o "parametri di query URL") sono elementi inseriti negli URL per aiutarti a filtrare e organizzare i contenuti o tracciare le informazioni sul tuo sito web.

In breve, i parametri URL sono un modo per trasmettere informazioni su un clic utilizzando l'URL stesso.

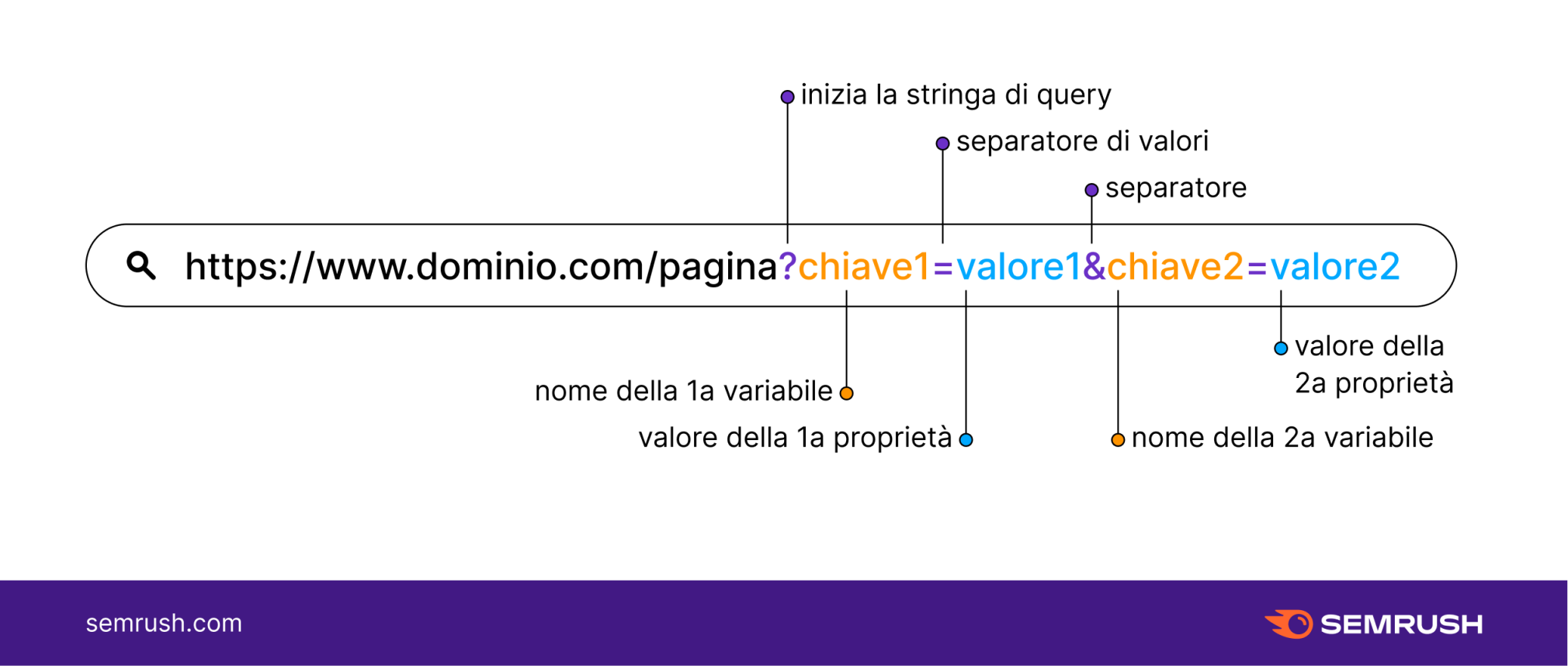

Per identificare un parametro URL, fai riferimento alla parte dell'URL che viene dopo il punto interrogativo (?). I parametri URL sono composti da una chiave e da un valore, separati dal segno di uguale (=). I parametri multipli sono separati dal simbolo della "e commerciale" (&).

Una stringa URL con parametri si presenta come segue:

Quando sono presenti più chiavi e più valori invece:

Chiave 1: nome della prima variabile

Chiave 2: nome della seconda variabile

Valore 1: valore della prima proprietà

Valore 2: valore della seconda proprietà

?: inizio della query string

= : separatore di valori

& : separatore di parametri

Come usare i parametri URL (con esempi)

I parametri URL sono comunemente utilizzati per ordinare i contenuti di una pagina, rendendo più facile per gli utenti navigare tra i prodotti di un negozio online. Queste query string permettono agli utenti di ordinare una pagina in base a filtri specifici e di visualizzare solo un determinato numero di articoli per pagina.

Le query string dei parametri di tracciamento sono altrettanto comuni. Sono spesso utilizzate dai marketer digitali per monitorare la provenienza del traffico, in modo da poter determinare se l'ultimo investimento fatto sui social, in una campagna pubblicitaria o in una newsletter ha avuto successo.

Come funzionano i parametri URL?

In base alle indicazioni di Google, esistono due tipi di parametri URL:

1. Parametri di modifica dei contenuti (attivi): parametri che modificano il contenuto visualizzato nella pagina.

Ad esempio, per inviare un utente direttamente a un prodotto specifico chiamato "xyz".

http://dominio.com?productid=xyz

2. Parametri di monitoraggio (passivi) per il tracciamento avanzato: sono parametri che trasmettono informazioni sul clic - ad esempio da quale rete proviene, da quale campagna o gruppo di annunci, ecc.

Queste informazioni saranno chiaramente registrate in un modello di tracciamento e includeranno dati preziosi per valutare i tuoi recenti investimenti di marketing.

- Ad esempio, per tracciare il traffico dalla tua newsletter:

https://www.dominio.com/?utm_source=newsletter&utm_medium=email

- O per raccogliere i dati di una campagna con URL personalizzati:

https://www.dominio.com/?utm_source=twitter&utm_medium=tweet&utm_campaign=summer-sale

Potrebbe sembrare abbastanza semplice da gestire, ma esiste un modo corretto e uno scorretto di utilizzare i parametri URL, di cui parleremo tra poco dopo aver visto alcuni esempi.

Esempi di URL di Query String

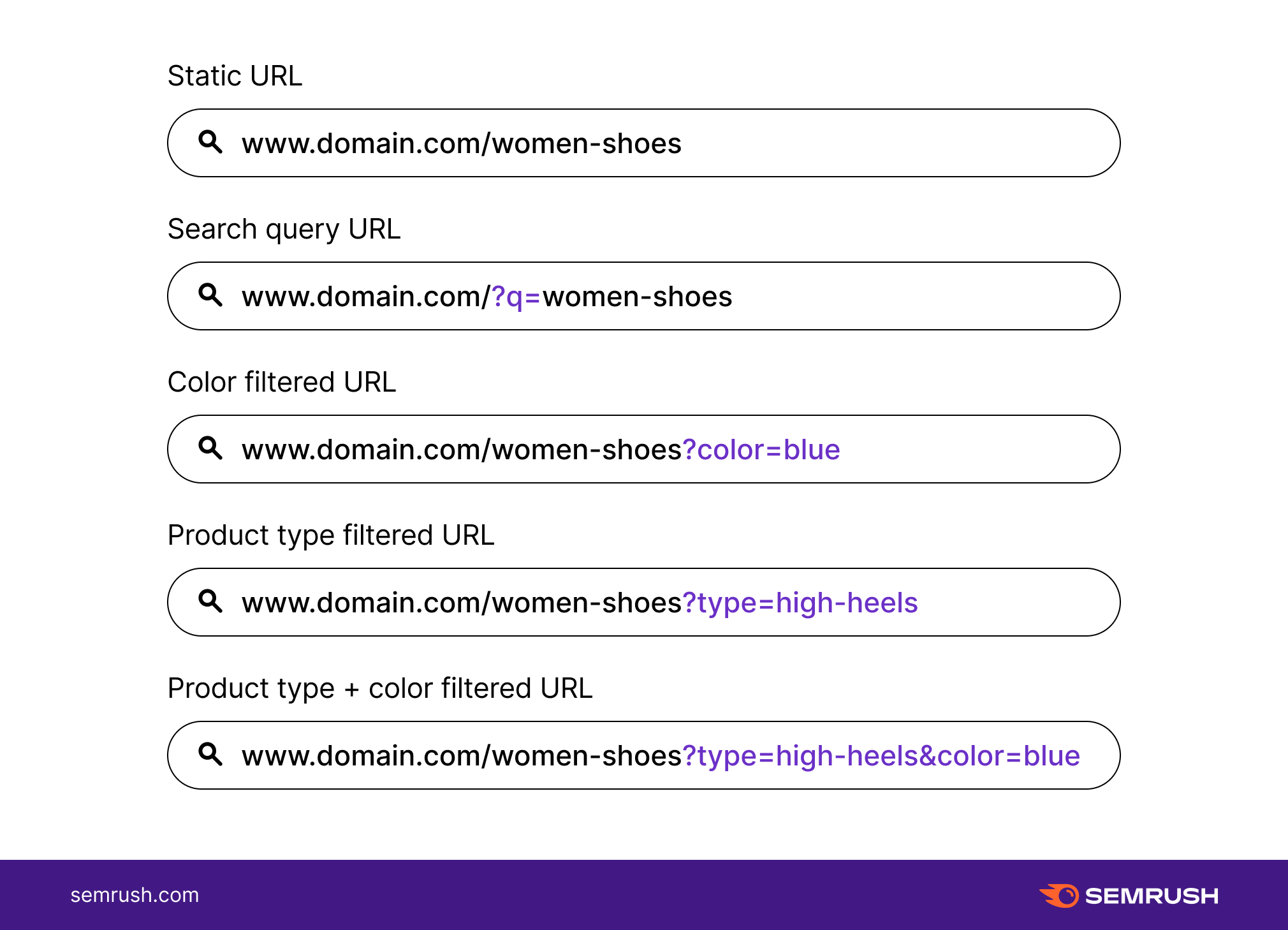

Gli usi più comuni dei parametri URL sono:

Quando i parametri URL diventano un problema SEO?

La maggior parte dei consigli SEO-friendly per la costruzione degli URL suggerisce di evitare il più possibile i parametri URL. Questo perché, per quanto utili possano essere, i parametri URL tendono a rallentare i web crawler, consumando una buona fetta di budget per il crawling.

I parametri URL passivi e mal strutturati che non modificano il contenuto della pagina (come gli ID di sessione, i codici UTM e gli ID di affiliazione) possono creare URL infiniti con contenuti non univoci.

I problemi SEO più comuni causati dai parametri URL sono:

- Contenuti duplicati: Poiché ogni URL viene trattato dai motori di ricerca come una pagina indipendente, un parametro URL potrebbe generare più versioni della stessa pagina, che potrebbero essere considerate contenuti duplicati. Questo perché una pagina riordinata in base a un parametro URL è spesso molto simile alla pagina originale, inoltre alcuni parametri potrebbero restituire lo stesso identico contenuto della pagina originale.

- Perdita di budget per il crawling: Mantenere una struttura URL semplice fa parte delle basi dell'ottimizzazione degli URL. Gli URL complessi con più parametri creano molti URL diversi che puntano a contenuti identici (o simili). Secondo gli sviluppatori di Google, i crawler potrebbero decidere di evitare di "sprecare" la larghezza di banda per indicizzare tutti i contenuti del sito web, contrassegnarli come di bassa qualità e passare al sito successivo.

- Cannibalizzazione delle parole chiave: Le versioni dell'URL originale filtrate si rivolgono allo stesso gruppo di parole chiave. Questo causa che diverse pagine competano per le stesse posizioni, portando i crawler a decidere che le pagine filtrate non aggiungono alcun valore reale per gli utenti.

- Segnali di ranking diluiti: Con più URL che puntano allo stesso contenuto, i link e le condivisioni social potrebbero puntare a qualsiasi versione parametrica della pagina. Questo può confondere ulteriormente i crawler, che non capiranno quale delle pagine concorrenti dovrebbe posizionarsi per la query di ricerca.

- Scarsa leggibilità dell'URL: Quando ottimizziamo la struttura dell'URL, vogliamo che questo sia semplice e comprensibile. Una lunga stringa di codice e numeri non è certo il massimo. Un URL parametrico è praticamente illeggibile per gli utenti. Quando viene visualizzato nelle SERP, in una newsletter o sui social media, l'URL parametrico ha un aspetto inaffidabile, rendendo meno probabile che gli utenti scelgano di cliccarvi e condividere la pagina.

Come gestire i parametri URL per una buona SEO

La maggior parte dei problemi SEO sopra citati è riconducibile a una causa principale: il crawling e l'indicizzazione di tutti gli URL parametrici. Ma fortunatamente i webmaster non sono impotenti di fronte all'infinita creazione di nuovi URL causata dai parametri.

Alla base di una buona gestione dei parametri URL c'è una corretta etichettatura.

Nota bene: i problemi SEO sorgono quando gli URL contenenti parametri mostrano contenuti duplicati e non unici, ovvero quelli generati da parametri URL passivi. Questi link - e solo questi - non dovrebbero essere indicizzati.

Controlla il tuo Crawl Budget

Il tuo crawl budget è il numero di pagine che i bot scansioneranno sul tuo sito prima di passare a quello successivo. Ogni sito web ha un crawl budget diverso e devi sempre assicurarti che il tuo non venga sprecato.

Purtroppo, avere molti URL scansionabili e di scarso valore, come gli URL parametrici creati da navigazioni a faccette, è uno spreco del crawl budget.

Mantieni coerenti i link interni

Se il tuo sito web ha molti URL basati su parametri, è importante segnalare ai crawler quale pagina non indicizzare e linkare costantemente la pagina statica non parametrica.

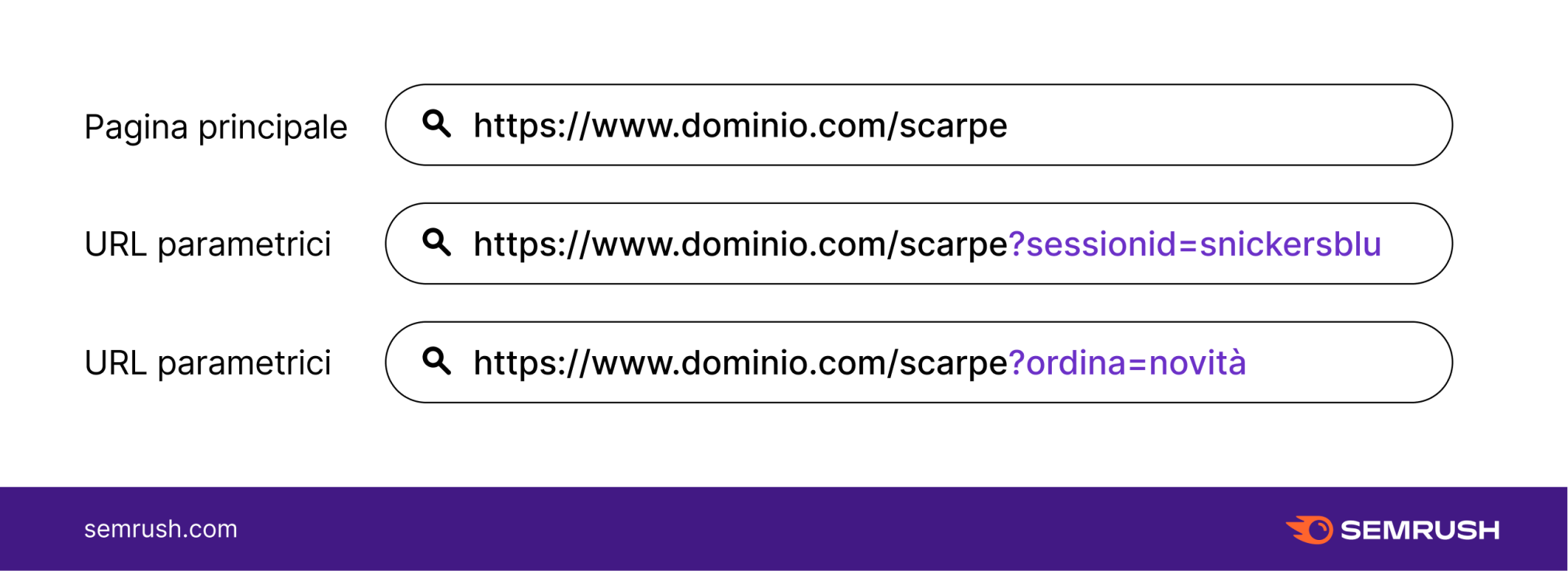

Ad esempio, ecco alcuni URL parametrici di un negozio di scarpe online:

In questo caso, fai attenzione e linka costantemente solo la pagina statica e mai le versioni con parametri. In questo modo eviterai di inviare ai motori di ricerca segnali incoerenti su quale versione della pagina indicizzare.

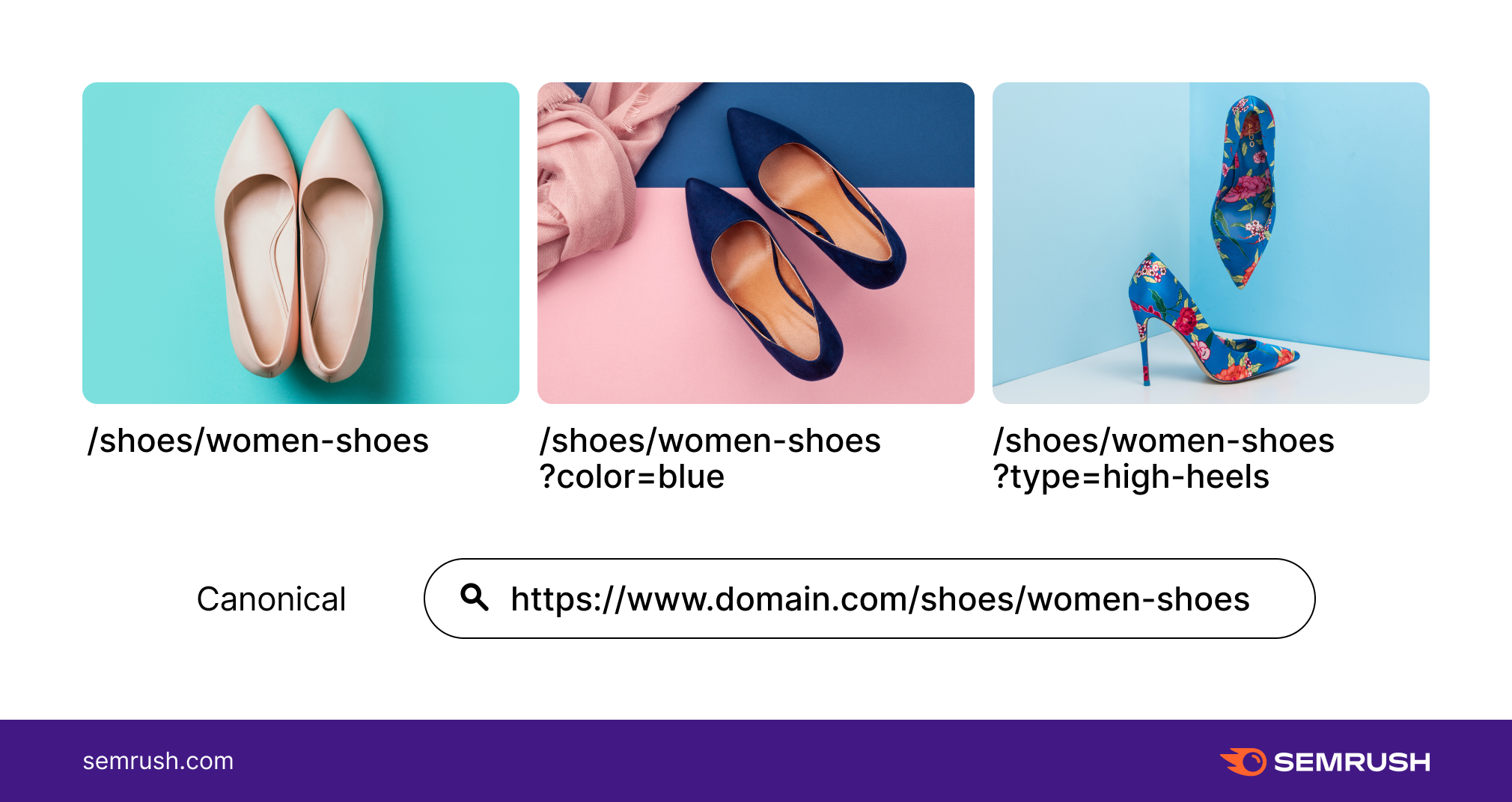

Canonicalizza una versione dell'URL

Una volta deciso quale pagina statica deve essere indicizzata, ricordati di canonicalizzarla. Imposta i tag canonical sugli URL parametrici, facendo riferimento all'URL preferito.

Se crei dei parametri per aiutare gli utenti a navigare nella pagina di destinazione del tuo negozio online di scarpe, tutte le variazioni di URL devono includere il tag canonical che identifica la pagina di destinazione principale come pagina di riferimento. Ad esempio:

- /scarpe/scarpe-donna/

- /scarpe/scarpe-donna?colore=blu

- /scarpe/scarpe-donna?tipo=tacco-alto

In questo caso, i tre URL indicati sopra sono "correlati" alla pagina di destinazione delle scarpe da donna non parametrica. In questo modo, i crawler riceveranno il segnale che solo la pagina di destinazione principale deve essere indicizzata e non gli URL parametrici.

Blocca i crawler con Disallow

I parametri URL destinati all'ordinamento e al filtraggio possono potenzialmente creare infiniti URL con contenuti non univoci. Puoi scegliere di bloccare l'accesso dei crawler a queste sezioni del tuo sito web utilizzando il tag disallow.

Bloccare i crawler, come Googlebot, dalla scansione di contenuti duplicati parametrici significa controllare ciò a cui possono accedere sul tuo sito web tramite il file robots.txt. Il file robots.txt viene controllato dai bot prima di effettuare il crawling di un sito web, quindi è un ottimo punto di partenza per l'ottimizzazione degli URL parametrici.

Il seguente file robots.txt non consente l'accesso a tutti gli URL che contengono un punto interrogativo:

Disallow:/*?tag=*

Questo tag di disconoscimento blocca tutti i parametri dell'URL dal crawling dei motori di ricerca. Prima di scegliere questa opzione, assicurati che nessun'altra parte della struttura del tuo URL utilizzi parametri, altrimenti anche questi verranno bloccati.

Potrebbe essere necessario effettuare un crawling per individuare tutti gli URL contenenti un punto interrogativo (?).

Sposta i parametri URL negli URL statici

Questo rientra nella più ampia discussione sugli URL dinamici e statici. Riscrivere le pagine dinamiche come statiche migliora la struttura degli URL del sito web.

Tuttavia, soprattutto se gli URL parametrici sono attualmente indicizzati, dovresti dedicare del tempo non solo alla riscrittura degli URL, ma anche al reindirizzamento di queste pagine verso le nuove posizioni statiche corrispondenti.

Gli sviluppatori di Google suggeriscono anche di:

- rimuovere i parametri non necessari, ma mantenere un URL di aspetto dinamico

- creare contenuti statici equivalenti ai contenuti dinamici originali

- limitare le riscritture dinamiche/statiche a quelle che consentono di rimuovere i parametri non necessari.

Usa lo strumento per i Parametri URL di Semrush

Come ormai è chiaro, la gestione dei parametri URL è un compito complesso e potresti aver bisogno di aiuto. Quando imposti un audit del sito con Semrush, puoi risparmiarti un bel mal di testa identificando per tempo tutti i parametri URL da non sottoporre a crawling.

Nella configurazione dello strumento Site Audit troverai un passaggio dedicato (Rimuovi parametri URL) dove puoi elencare i parametri URL da ignorare durante il crawling (UTM, pagina, lingua, ecc.).

Questo è utile perché, come abbiamo detto prima, non tutti gli URL contenenti parametri devono essere sottoposti a crawling e indicizzati. I parametri che modificano il contenuto di solito non causano contenuti duplicati e altri problemi SEO, quindi la loro indicizzazione aggiunge valore al tuo sito web.

Se hai già un progetto impostato su Semrush, puoi modificare le impostazioni dei parametri URL cliccando sull'icona dell'ingranaggio.

Incorpora i parametri URL alla tua strategia SEO

Gli URL parametrici rendono più facile la modifica o la tracciabilità dei contenuti, quindi vale la pena incorporarli quando è necessario. Dovrai far sapere ai web crawler quando indicizzare o meno determinati URL contenenti parametri ed evidenziare la versione della pagina di maggior valore.

Prenditi il tempo necessario per decidere quali URL parametrici non devono essere indicizzati. Con il tempo, i web crawler capiranno meglio come navigare e valutare le pagine del tuo sito.