Questo articolo è rivolto principalmente agli addetti ai lavori che dovrebbero avere una conoscenza di alto livello sul funzionamento dei motori di ricerca, quindi in questa sede approfondiremo i processi che il motore di ricerca e i crawler web utilizzano per comprendere il web.

Cominciamo con il processo di scansione.

Che cos'è la scansione dei motori di ricerca?

La scansione è il processo utilizzato dai crawler web dei motori di ricerca (bot o spider) per visitare e scaricare una pagina ed estrarne i collegamenti (link) per scoprire pagine aggiuntive.

Le pagine note al motore di ricerca vengono sottoposte a scansione periodica per determinare se sono state apportate modifiche al contenuto della pagina dall'ultima scansione.

Se un motore di ricerca rileva modifiche a una pagina dopo aver eseguito la scansione di una pagina, aggiornerà l'indice in risposta a tali modifiche rilevate.

Come funziona la scansione web?

I motori di ricerca utilizzano i propri crawler Web per scoprire e accedere alle pagine Web.

Tutti i crawler dei motori di ricerca commerciali iniziano a eseguire la scansione di un sito Web scaricando il file robots.txt, che contiene le regole su quali pagine i motori di ricerca dovrebbero o non dovrebbero eseguire la scansione sul sito Web. Il file robots.txt può contenere anche informazioni sulle sitemap; questo contiene elenchi di URL su cui il sito desidera eseguire la scansione di un crawler del motore di ricerca.

I crawler dei motori di ricerca utilizzano una serie di algoritmi e regole per determinare la frequenza con cui eseguire la scansione di una pagina e quante pagine su un sito devono essere indicizzate. Ad esempio, una pagina che cambia regolarmente può essere sottoposta a scansione più frequentemente di una che viene modificata raramente.

Per approfondire leggi il post: Che cosa sono la crawlability e l'indexability di un sito web?

Come si possono identificare i crawler dei motori di ricerca?

I bot dei motori di ricerca che eseguono la scansione di un sito Web possono essere identificati dalla stringa dell'agente utente che passano al server Web quando richiedono pagine Web.

Ecco alcuni esempi di stringhe dell'agente utente utilizzate dai motori di ricerca:

- Googlebot User Agent

- Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

- Bingbot User Agent

- Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm)

- Baidu User Agent

- Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

- Yandex User Agent

- Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

Chiunque può utilizzare lo stesso user agent di quelli utilizzati dai motori di ricerca. Tuttavia, l'indirizzo IP che ha effettuato la richiesta può anche essere utilizzato per confermare che proviene dal motore di ricerca, un processo chiamato reverse DNS lookup.

Scansione di immagini e altri file non di testo

I motori di ricerca tentano normalmente di eseguire la scansione e l'indicizzazione di tutti gli URL che incontrano.

Tuttavia, se l'URL è un tipo di file non testuale come un'immagine, un file video o audio, i motori di ricerca non saranno in genere in grado di leggere il contenuto del file diverso dal nome file e dai metadati associati.

Sebbene un motore di ricerca possa essere in grado di estrarre solo una quantità limitata di informazioni sui tipi di file non di testo, è comunque possibile indicizzarli e posizionarli nei risultati di ricerca e ricevere traffico.

Per approfondire leggi: Immagini e SEO: come ottimizzare le immagini per Google.

Scansione ed estrazione di collegamenti da pagine

I crawler scoprono nuove pagine eseguendo una nuova scansione delle pagine esistenti che già conoscono, quindi estraendo i collegamenti ad altre pagine per trovare nuovi URL. Questi nuovi URL vengono aggiunti alla coda di scansione in modo che possano essere scaricati in un secondo momento.

Attraverso questo processo di seguire i diversi link interni, i motori di ricerca sono in grado di scoprire tutte le pagine Web disponibile su Internet.

Sitemap

Un altro modo in cui i motori di ricerca possono scoprire nuove pagine è la scansione delle sitemap.

Le Sitemap contengono set di URL e possono essere create da un sito Web per fornire ai motori di ricerca un elenco di pagine da sottoporre a scansione. Questi possono aiutare i motori di ricerca a trovare contenuti nascosti in profondità di un sito Web e possono fornire ai SEO la possibilità di controllare e comprendere meglio le aree di indicizzazione e frequenza del sito.

Come ci aiuta SEMrush?

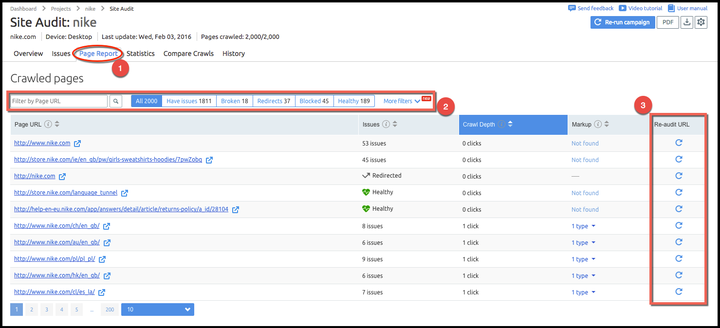

Forse non lo sai ma SEMrush dispone di una funzione molto interessante che permette agli utenti di effettuare al volo un re-crawl di una determinata pagina del loro sito web.

Grazie a questa funzionalità di SEMrush puoi effettuare in pochi istanti un re-crawl solo su una singola pagina, invece di ripetere daccapo l'analisi di Site Audit dell'intera campagna.

Basta andare in page report (fig 1), trovare con i filtri la pagina che vuoi controllare (Fig. 2) e cliccare sull'icona della freccia tonda nella nuova colonna 'Re-audit URL' (Fig. 3). Questo farà sì che venga compiuto un re-crawl sulla pagina selezionata, dandoti un aggiornamento in tempo reale del suo stato.

Per approfondire leggi la notizia completa.

Conoscevi già questa funzionalità di Site Audit?

Dimmi cosa ne pensi.