A volte mi capita di riflettere sul lavoro di un SEO.

Potenzialmente ci sono oggi tantissimi consulenti. Apparentemente sono tutti bravi. O, almeno, dicono di esserlo.

C'è tuttavia una cosa che li differenzia per livelli di seniority: gli anni di esperienza. Forse sarebbe anche giusto definire meglio l'esperienza con:

- anni di attività;

- diversità/competitività di settori in cui si è operato;

- diversità di dimensione/ampiezza di sito web;

- diversità di attività nella SEO in cui ci si è "sporcati le mani" (un conto è avere esperienza nel posizionamento di nuovi siti, un altro è avere avuto esperienza anche nel recupero da penalizzazioni/filtri o, ancora, essersi specializzati nella Local SEO).

Bene, l'esperienza è ciò che può permettere a un consulente SEO di risolvere un problema complesso in pochi minuti. Certo, non può avere la soluzione a portata di mano per tutto, ma la capacità e velocità di trovare indizi e avanzare ipotesi piuttosto plausibili, quello sì.

Ciò porta a collegarmi all'episodio che sto per raccontare e che rappresenta un interessante caso di studio per chi fa SEO.

Case study: quando la Link building non aiuta nel posizionamento organico

Durante il mio workshop "Link Building e le Digital PR", tenuto all'Smxl di Milano lo scorso novembre, mi è stato chiesto, da un partecipante, di analizzare un sito web per capire le ragioni per cui, nonostante ci fosse una campagna di Link Building in atto, un gruppo di parole chiave, nonché quelle long tail correlate, non si smuovevano da un posizionamento che potremmo definire "da limbo" e le pagine del sito erano mediamente collocate oltre la quinta pagina di risultati di ricerca di Google.

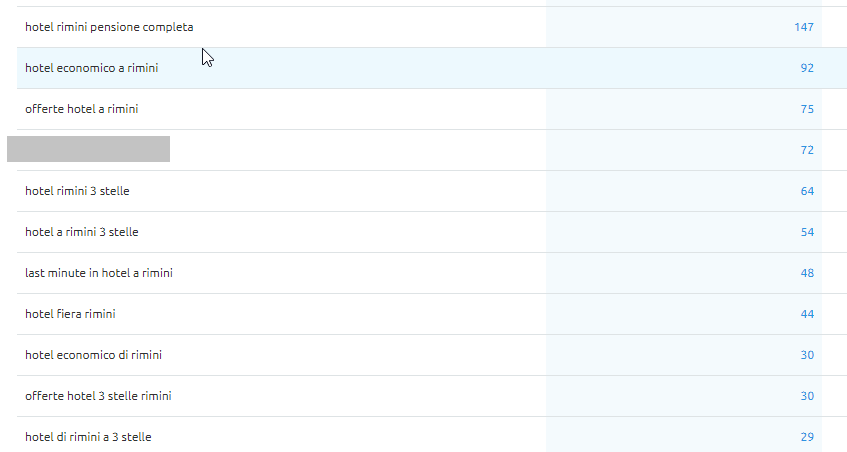

Uno degli esempi più lampanti era la parola chiave "hotel 3 stelle Rimini".

Il sito in questione riguardava, infatti, una struttura ricettiva della riviera romagnola. Apparentemente i link erano anche di buona qualità e, anche inserendoli con anchor text esatta, non venivano guadagnate nuove posizioni.

Avendo avuto esperienza in passato con filtri algoritmici temutissimi ( Panda o Penguin) ho subito pensato che potesse essere (ancora) soggetto a qualche filtro.

Il problema è che Google non è mai stato generoso di informazioni verso i webmaster e, anzi, negli ultimi anni, sembra aver meno voglia di prima di dialogare con loro. Si parla tanto di Quality Update, Bert e altri aggiornamenti algoritmici, di Mobile SEO e di come fare a posizionarsi per il Voice Search, ma si è smesso di fare informazione sulla SEO più old-school, quella che ti puniva se facevi le cose "troppo spinte" e che come mezzi di dissuasione utilizzava le azioni manuali e i filtri algoritmici.

E, in questo caso, il campanellino di allarme mi si è acceso proprio sui filtri algoritmici (l'azione manuale sarebbe stata segnalata su Google Search Console, ma in questo senso, l'anti-spam team di Google è un po' fermo da qualche annetto, almeno sulla over-optimization SEO).

Google, infatti, ha smesso di parlare di Panda e Penguin da qualche anno, ma questo non significa che hanno smesso di funzionare: sono stati probabilmente integrati nell'algoritmo principale del search engine e vengono aggiornati nelle iterazioni dei noti Quality Update. Il condizionale è d'obbligo e ciò a causa della scarsa comunicazione di Google, di cui si accennava sopra.

Per approfondire leggi il post: Come recuperare traffico organico con i Quality Update: casi di studio.

Avevo dunque un'intuizione (ovvero sito potenzialmente soggetto a filtro algoritmico) ma doveva essere verificata. Avevo 10 minuti di tempo. Il workshop era terminato e ci trovavamo nella sessione delle domande e risposte.

Come capire se un sito è soggetto a penalizzazione: l'importanza dell'analisi storica

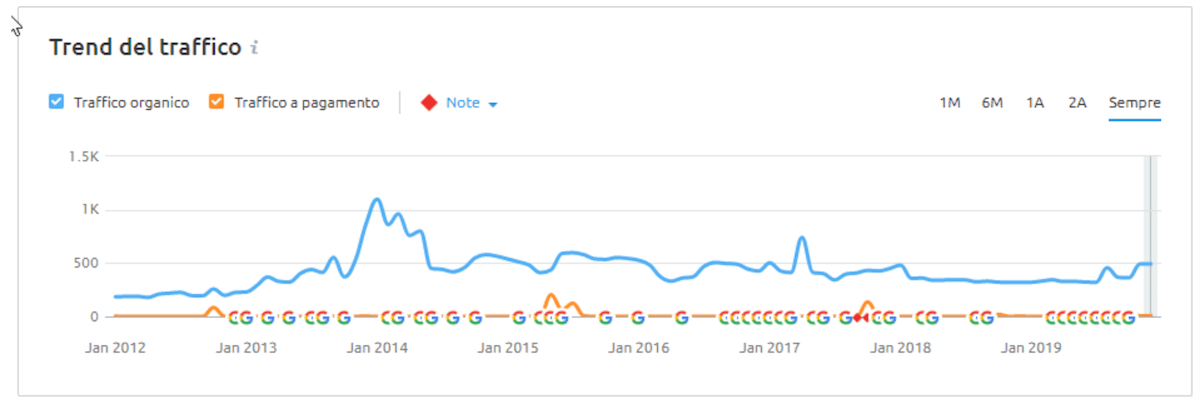

La prima cosa da fare è stata quella di analizzare il traffico organico del sito su SEMrush (in mancanza di accesso a Google Analytics, è comunque l'alternativa migliore) e mettersi alla ricerca di cali importanti di traffico organico, che è stato individuato tra Febbraio e Giugno 2014.

Ciò che spesso ci si dimentica di fare, è analizzare lo "storico del dominio". Basare la propria analisi solo sulle conoscenze più attuali su quelli che sono i fattori di ranking di Google (es. ora si parla molto di Search intent, progettazione mobile first e ottimizzazione della velocità soprattutto mobile), non permette di risolvere problemi legati a tecniche SEO che una volta erano consentite da Google e che, a un certo punto, sono state classificate come spam e diventate oggetto di filtri algoritmici che le contrastano.

Quando c'è un problema di dominio, apparentemente inspiegabile, la soluzione andrà scovata nell'analisi storica del dominio.

Come pure non bisogna dimenticare, in casi come questo, di limitarsi alla sola analisi on site o soltanto a quella off site.

Un modo per capire se Penguin o Panda avevano potuto colpire il sito in esame, era vedere i posizionamenti persi in corrispondenza della data in cui era stato annunciato l'aggiornamento.

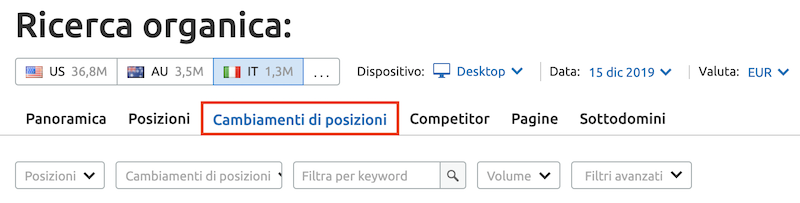

L'ottimo strumento "Cambiamenti di Posizione", presente nella sezione "Ricerca organica" di SEMrush, permette di esplorare i posizionamenti persi nel periodo di tempo nel quale si è identificato un'importante perdita di traffico organico stimato.

Nel caso del sito web in oggetto di analisi, gran parte delle "money keywords" d'interesse iniziavano a perdere posizionamenti a partire dal mese di Maggio 2014.

A questo punto mi interessava controllare tre cose:

1. la versione on site che il sito della struttura ricettiva aveva in quel periodo (maggio 2014);

2. quali aggiornamenti algoritmici fossero stati rilasciati in quel periodo;

3. il profilo link del sito.

L'analisi storica on site del sito

Per il primo punto, ci viene in aiuto Wayback Machine, dal quale, se siamo fortunati possiamo ottenere anche l'intero sito web indicizzato (utile in alcuni casi, per effettuare crawling avanzati per sistemare migrazioni effettuate in passato non correttamente).

Vedendo il sito con Wayback Machine ho notato subito una forte sovraottimizzazione on site; classica ripetizione non necessaria delle solite keywords commerciali, pagina che valorizzava la keyword in ogni campo possibile, H1 compreso.

Come se non bastasse, implementava una tecnica tanto in voga nell'era pre Panda-Penguin: la sovraottimizzazione dei footer.

Qui mi si è presentato l'aspetto bomba: il sito disponeva di una serie di pagine create ad hoc per spingere una serie di chiavi correlate a quella primaria, ma che con la struttura c'entravano poco. Faccio un esempio, la struttura era un 3 stelle di Rimini, ma non era nelle immediate vicinanze del Palacongressi e anche se lo fosse, non c'è bisogno di creare una pagina apposita da sovraottimizzare.

Queste pagine erano tutte linkate con anchor text esatto dal footer e, all'interno dei testi delle singole pagine, erano inseriti dei link interni autoreferenziali con anchor text esatto.

Il sito si vedeva chiaramente essere fatto per Google e non per gli utenti. Pagine del genere, infatti, non danno alcun valore all'utente. Se mi stai già dicendo nella homepage che è un hotel a 3 stelle, che bisogno c'è di rimarcarmelo altre volte (minimo) in altre 3 pagine diverse?

L'analisi storica dei link

Quando vedi una forte sovraottimizzazione on site c'è molto spesso da attendersi la stessa cosa anche sul fronte off site. Questo perché, in passato, queste pratiche di fare SEO andavano a braccetto.

Anche i link, dunque, soprattutto quelli storici, mostravano una sovraottimizzazione nonché uno sbilanciamento degli anchor text su parole chiave decisamente commerciali.

I link, come facile intuire, non erano neanche di buona qualità, ma provenienti da siti di comunicati stampa, directories. Inoltre erano link da template, dunque sitewide.

Il sito, dunque, lato on site aveva nel 2014 una struttura a content farm: tante pagine sovraottimizzate del tutto inutili all'utente e del tutto Panda-style. Lato off site, una sovraottimizzazione e una serie di pattern che richiamava molto il Penguin.

Cercando su uno dei tanti tool online che memorizzano gli update algoritmici ufficialmente confermati da Google nel tempo, nel mese di Maggio 2014 furono rilasciati il Payday Loan 2.0, volto a targetizzare "spammy queries" (e il travel è uno di questi) di cui non si sa molto e il Panda 4.0.

La certezza di ciò potrei averla soltanto guardando le statistiche analytics del sito.

Come risolvere il problema presentato nel caso studio

Finché il sito è soggetto ad un filtro che impedisce alle pagine di posizionarsi bene per un intero set di keywords commerciali, ogni tentativo di spingerle con link building, anche di qualità, o altro, è del tutto vano.

Finché sono ancora attive quelle tecniche SEO, costruite anni addietro nella convinzione che fossero giuste, che sono causa del filtro, il sito non potrà recuperare quelle posizioni perse.

Bisognerà dunque prima risolvere il problema all'origine.

Se il 95% del profilo link ancora attivo di un sito è composto da siti linkanti di bassa qualità, con link testuali sovraottimizzati, bisognerà rimuoverli o metterli in lista disavow Google.

Bisognerà inoltre mappare tutto il sito, controllando bene che precedenti pagine del sito non siano ancora indicizzate.

Una volta ripulito tutto, si dovrà procedere con la creazione di nuovi contenuti e la link building, se prevista, dovrà valorizzare prima di tutto il brand e, dato il filtro sulle parole commerciali, inizialmente sarà bene non linkare proprio con quelle parole.

Far uscire un sito da una sorta di "blacklist" non è affatto semplice. Il sito è incriminato e Google lo sa e si aspetta un cambio di rotta e di strategia.

E tu cosa aggiungeresti alle conclusioni di questo case study?

Attendo i tuoi commenti.