Come funzionano Panda, Penguin e gli altri algoritmi di Google più pericolosi

Quando parliamo di lotta allo spam da parte del più grande motore di ricerca al mondo, ci riferiamo a due modalità con le quali il contrasto viene eseguito:

- un intervento umano, a opera dei Search Quality Analyst interni a Google;

- un intervento di tipo ingegneristico, operato su base algoritmica in fase di attribuzione del ranking alle pagine web.

Seguendo i più importanti e storici aggiornamenti algoritmici lanciati da Google, è almeno dal 2003 che si cerca di contrastare lo spam nelle sue più sfaccettate forme. Nel 2003 la link building era ancora poco diffusa e la forma primaria di spam per favorire i posizionamenti dei siti era il keyword stuffing.

Fu a questo scopo che quell'anno venne lanciato quello che è probabilmente il primo update algoritmico antispam di Google, almeno tra quelli noti pubblicamente, chiamato "Florida".

Negli anni seguenti, di update antispam ne sono seguiti differenti e molto spesso avevano lo scopo di targetizzare nuove tecniche di spam ideate dalle prime generazioni di SEO, mentre lo spam evolveva dall'essere prettamente on-site, a diventare principalmente di tipo off-site, ovvero, sfruttando la link building aggressiva. Nei primi anni 2000 ci fu infatti un vero e proprio boom di attività e mercati di compra-vendita di links.

Uno dei più impattanti update antispam di Google che si ricordino prima del 2011, fu il Jagger, lanciato nel 2005, che creò uno scossone nelle comunità SEO e aveva l'obiettivo di targetizzare le prime forme di link building di bassa qualità e gli schemi di links.

Se vuoi approfondire i principali aggiornamenti algoritmici di Google, ti rimando all'infografica che realizzammo su Webinfermento.

Considera però che gli update algoritmici antispam noti alla comunità SEO sono soltanto una parte di quelli rilasciati ogni anno da Google. Non tutti gli update sono infatti noti e Google, si sa, non ha un canale altamente preferenziale di comunicazione con i SEO.

Ci sono tuttavia 4 update algoritmici piuttosto pericolosi e che hanno avuto impatti drastici su molti siti. Ognuno di questi update colpisce siti che generalmente fanno molto traffico grazie al posizionamento di cui godono con parole chiave di tipo monetarie, che fanno vendere il brand.

Gli update che approfondiremo sono: Panda (2011), Penguin (2012), Page Layout (2012), Payday Loan, DMCA (2012).

1. Panda Update

Noto inizialmente come Farmer Update, il Panda prende il nome da un ingegnere di Google che lo lanciò, Navneet Panda e venne lanciato per la prima volta in forma statica nel 2011 e veniva aggiornato periodicamente prima di diventare nel 2015 dinamico o everflux, ovvero integrato nell'algoritmo principale di Google.

Fu probabilmente il primo, vero, grande update antispam di Google che mandò per la prima volta in crisi la comunità SEO, benché, come per ogni nuovo filtro lanciato dal motore di ricerca, analizzando i siti colpiti, studiando e confrontando decine di altri siti, era possibile trovare alcuni pattern in comune tra i siti penalizzati e capire i reali obiettivi di targeting degli algoritmi.

Sei stato colpito da Google Panda?

Innanzitutto c'è da dire che i siti colpiti dal Panda perdono buona parte del traffico organico. Il crollo coincide con il giorno esatto della data del rilascio dell'update (solitamente annunciata dal tweet di Matt Cutts, che ora non lavora più in Google) e non è indolore. Sostanzialmente se sei colpito dal Panda te ne accorgevi e i dubbi erano pochi, perché incrociando i dati di Google Analytics con la data dell'update, potevi avere conferma.

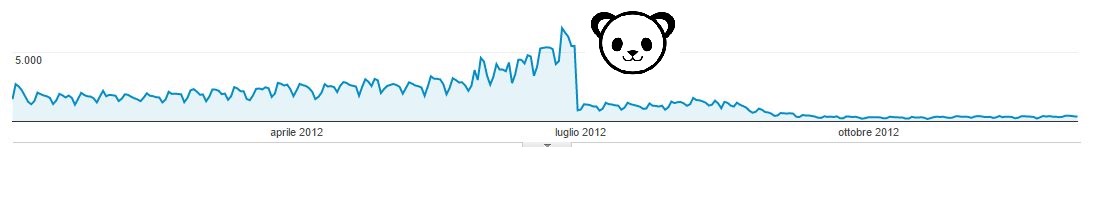

Questo è il grafico di Analytics di un sito colpito dal refresh 3.9 del Panda, del 24 Giugno 2012.

Il Panda colpisce a livello di sito e colpisce quando la quasi totalità del sito è costituita da quello che viene chiamato "thin content", letteralmente contenuti sottili, pagine web che non aggiungono nulla di nuovo e di utile all'utente rispetto a quanto già presente in decine o centinaia di altri siti e pagine web, ma che godono di ottimi posizionamenti, sviluppando alti volumi di traffico e monetizzando in vari modi, vendite, contatti e da affiliazioni.

Non per niente i primi siti a cadere sono gli aggregatori, privi di contenuti originali e che rimandano ad altri siti per leggere una notizia completa, o i siti composti da strutture a directory che non aggiungono nulla di utile all'esperienza dell'utente, che potrebbe trovare quello che sta cercando in un sito specifico, senzaallungare il suo percorso di navigazione.

Dopo vari dibattiti tra SEO e l'analisi dei siti colpiti dal Panda, posso affermare che solitamente il sito che viene colpito:

- non presenta contenuti originali;

- i contenuti sono scarni e la presenza di banner di affiliazione è eccessiva in proporzione ai contenuti (basso rapporto tra contenuti e link di affiliazione);

- link di affiliazione (tanti) senza attributo nofollow;

- sovra-ottimizzazione on page.

Sostanzialmente l'algoritmo colpisce i siti di bassa qualità, siti che non meritano di stare al top delle serp per la mancanza di qualità offerta all'utente.

Benché non siano strettamente legate ai segnali che il Panda esamina per l'applicazione del filtro ai siti, in questo post del 2011 pubblicato da Amit Singhal sul blog ufficiale per Webmaster di Google - guarda caso qualche giorno dopo il lancio del primo update - vengono dati consigli agli utenti circa la creazione di siti di qualità, con una serie di domande da tenere a mente quando si creano siti web.

Ti consiglio di salvartelo tra i preferiti per comprendere meglio il funzionamento del Panda.

2. Penguin Update

Mentre il filtro Panda fu creato per contrastare lo spam nei siti di bassa qualità, il Penguin, al contrario, aveva l'obiettivo di contrastare, principalmente quello off-site. Ricordo ancora come la comunità SEO mondiale abbia tremato nel 2012, semplicemente perché molte tecniche di link building che, fino ad allora erano le best practice del settore, cessarono di esistere.

Contrariamente a quanti molti pensano, Penguin non prende di mira soltanto le tecniche di link building di bassa qualità, ma anche la sovraottimizzazione on site ed è spesso la combinazione di questi due fattori a far scattare il filtro.

Sul Penguin è stato già scritto molto e per degli approfondimenti ti rimando agli articoli che scrissi sul mio blog, quie qui su WebHouse.

Le fonti di acquisizione di link prese di mira dall'algoritmo antispam sembrano quasi sempre essere riconducibili a:

- siti di article marketing e comunicati stampa di bassa qualità;

- siti collegati tramite network;

- directories;

- guest post di bassa qualità.

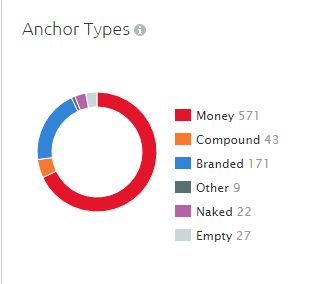

A questo si aggiunge spesso la diversità di tematica tra sito linkante e sito destinatario e l'aggressività nell'utilizzo di pochi anchor text commerciali.

Sintetizzando, se fai link building di bassa qualità (inteso come qualità bassa dei siti linkanti) e aggressiva (linkando sempre gli stessi money anchor text) e stai sviluppando molto traffico organico, allora c'è una buona probabilità che, se il filtro anti spam Penguin non ti ha ancora colpito, ti colpirà a breve.

Ecco come appare il link profile di un sito colpito dal Penguin. La gran parte dei link esterni è su testo di ancoraggio a parola chiave esatta, corrispondente a keywords che fanno monetizzare il sito.

Anche il Penguin, come il Panda, quando fu lanciato era "statico". Si applicava come filtro il giorno esatto del suo lancio. Diversamente dal Panda poi, i suoi update erano sporadici e si è dovuto attendere quasi 2 anni per l' ultimo e definitivo update (settembre 2016) che ha integrato l'algoritmo Penguin in quello principale del motore di ricerca, diventando, per così dire, real time.

3. Page Layout (Top Heavy)

Meno conosciuto dei più temibili Panda e Penguin, ritengo però che questo sia uno degli altri pericolosi algoritmi di Google che hanno avuto un impatto anche in Italia. Lanciato per la prima volta nel Gennaio del 2012 e aggiornato l'ultima volta a Febbraio 2014, colpisce i siti che non presentano contenuti visibili above-the fold e che spingono l'utente a scroll del mouse, chiusure di vari popup, prima di poter accedere al reale contenuto di interesse, comportando quindi una pessima esperienza di navigazione per l'utente.

Pur avendo qualche richiamo e similarità col Panda, sembra concentrarsi esclusivamente sull'eccesso di pubblicità all'interno di pagine web.

E i siti colpiti da questo filtro anti spam sembrano essere stati proprio i grandi siti di news. Quello che segue è la stima del traffico organico di uno dei più grandi siti di news italiani probabilmente colpito dal top heavy update di Febbraio 2014.

Come puoi vedere, nella Panoramica del dominio, SEMrush ti segnala il rilascio degli update, in modo da visualizzare immediatamente se un cambiamento di traffico è riconducibile ad un aggiornamento degli algoritmi di Google.

Non posso rivelare il nome del sito, ma posso garantire sul fatto che la sua navigazione è, ancora oggi, colma di banner di advertising.

Ad oggi non sono noti altri aggiornamenti o refresh relativamente a questo update, che non è ancora di tipo real-time come per Panda e Penguin.

4. PayDay Loan

Questo è uno degli update di cui si sa molto poco. Pare prende di mira lo spam in determinate nicchie e per determinate query ad alto volume di ricerca, come "payday loan" (da cui prende il nome), casinò, viagra, porno, ecc. e targetizza lo spam dei siti che competono per queste query.

Ora, che tipologia di spam sia preso di mira non è noto, sappiamo solo che prende di mira spam illecito, ma sembra non essere un algoritmo correlato al Panda e al Penguin.

5. DMCA

Conosciuto anche come "Pirate Update", quest'ultimo algoritmo, anch'esso lanciato nel 2012, ha l'obiettivo di colpire i siti che hanno ricevuto numerose richieste DMCA (Digital Millennium Copyright Act). Si tratta di segnalazioni che possono essere fatte a Google di rimozione contenuti che infrangono copyright. Fino al 2012 la segnalazione poteva essere effettuata manualmente tramite un apposito link e compilando un form che segnalava la pagina che infrangeva il copyright. Google esaminava le richieste e decideva quali pagine rimuovere dal proprio indice.

Con l'update algoritmico DMCA le cose sono un po' cambiate, in quanto, se un sito riceve nel tempo diverse richieste DMCA, l'azione, anziché applicarsi a livello di singola pagina, rimuovendo questa dall'indice, si applica a livello di sito, riducendo i posizionamenti del sito nelle serp.

Ad eccezion fatta per Penguin e Panda, che sono diventati "real time", ovvero integrati nell'algoritmo principale di Google, gli altri update vengono ancora aggiornati manualmente.

Google tuttavia, sta diventando sempre più restio ad informare le community di web master circa nuovi update e cambiamenti, che, a nostra insaputa, vengono comunque pubblicati.

E tu sei mai stato colpito da uno degli algoritmi anti spam di Google?

Raccontami qual è stata la ragione e come sei uscito dalla penalizzazione.