Circa un anno e mezzo fa ci siamo posti un obiettivo.

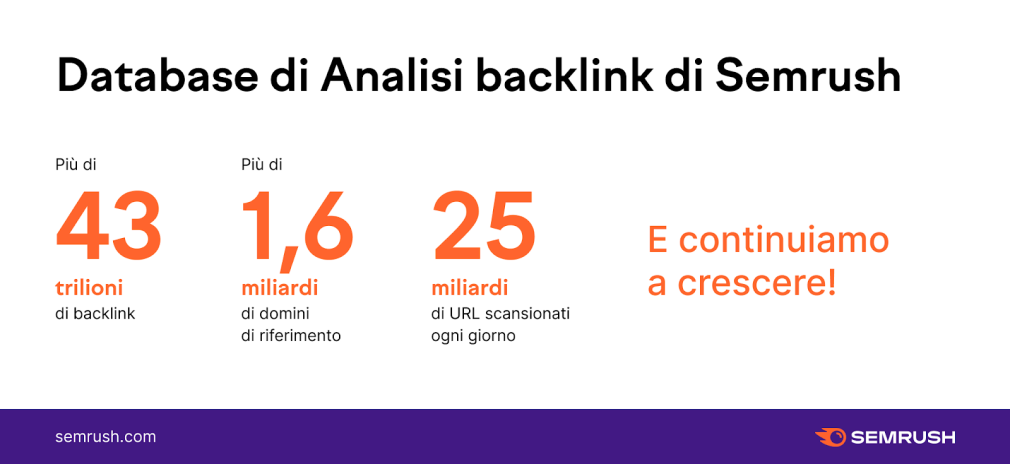

L'obiettivo era creare il più grande database di backlink, con l'aggiornamento più rapido e la più alta qualità disponibile sul mercato.

Ora che abbiamo raggiunto il nostro obiettivo, non vediamo l'ora che tu possa testare il nostro nuovo database personalmente!

Vuoi sapere esattamente come siamo riusciti a costruire un database del genere?

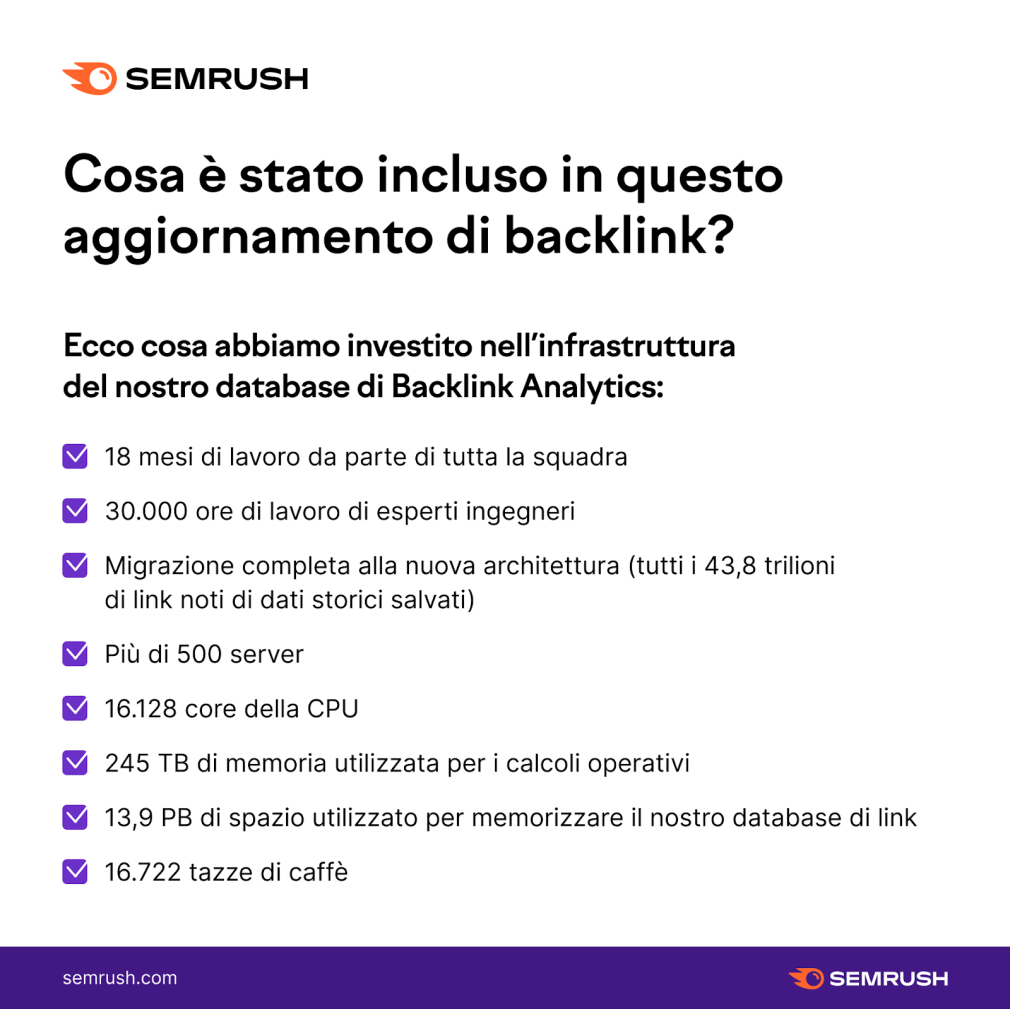

È bastata una combinazione di circa 16.722 tazze di caffè con oltre 500 server e 30.000 ore di lavoro del nostro team di ingegneri e data scientist.

Sembra semplice, vero?

Dai un'occhiata a questo post del blog per vedere quanto siamo più veloci ora.

Un database di backlink nuovo e migliorato

Per prima cosa parliamo delle novità, poi ti mostreremo come ci siamo riusciti e quali problemi abbiamo risolto.

Come funziona il database di backlink di Semrush

Prima di approfondire ciò che è stato migliorato, esaminiamo le basi del funzionamento del nostro database di backlink.

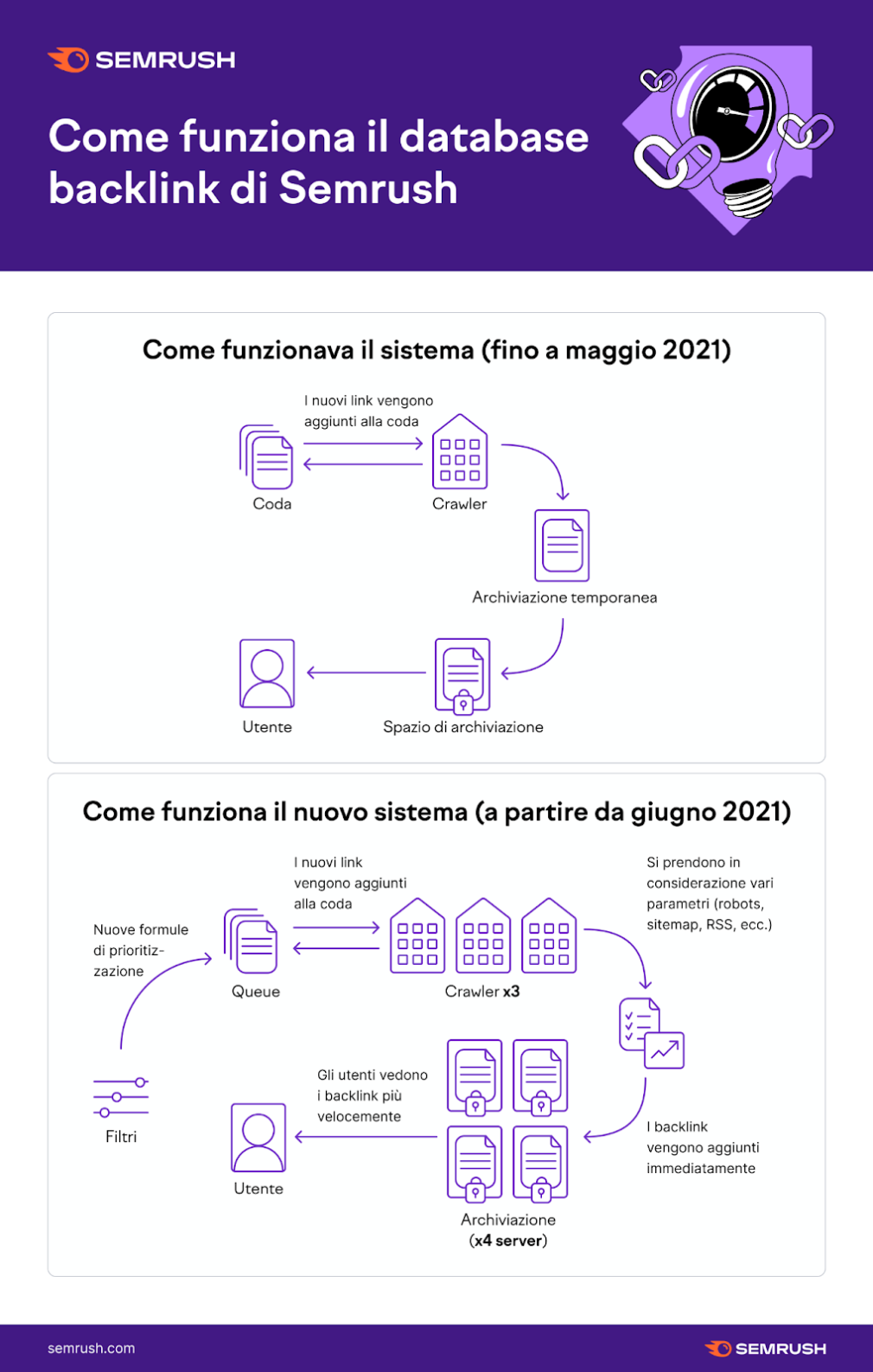

Per prima cosa, generiamo una coda di URL che decide quali pagine verranno inviate per la scansione.

Quindi, i nostri crawler esaminano queste pagine. Quando i nostri crawler identificano i collegamenti ipertestuali che puntano da queste pagine a un'altra pagina su Internet, salvano tali informazioni.

Successivamente, tutti questi dati vengono conservati in una memoria temporanea per un periodo di tempo, prima di scaricarli nella memoria pubblica che qualsiasi utente Semrush può vedere nello strumento.

Con la nostra nuova architettura, abbiamo virtualmente rimosso il passaggio di archiviazione temporanea, triplicato il numero dei crawler e inserito una serie di filtri prima della coda, quindi l'intero processo è molto più veloce ed efficiente.

Coda

In poche parole, ci sono troppe pagine da scansionare su Internet.

Alcune devono essere sottoposte a scansione con maggiore frequenza, altre non devono essere affatto scansionate. Pertanto, utilizziamo una coda che decide in quale ordine verranno inviati gli URL per la scansione.

Un problema comune in questo passaggio è la scansione di troppi URL simili e irrilevanti, che potrebbe portare le persone a vedere più spam e meno domini di riferimento unici.

Cosa abbiamo fatto?

Per ottimizzare la coda, abbiamo aggiunto filtri che danno la priorità a contenuti unici e siti Web di autorità superiore, oltre a contrastare le link farm. Di conseguenza, il sistema ora trova più contenuti unici e genera meno report con link duplicati.

Alcuni punti salienti di come funziona ora il nostro sistema:

- Per proteggere la nostra coda dalle link farm controlliamo se un numero elevato di domini proviene dallo stesso indirizzo IP. Se vediamo troppi domini dallo stesso IP, la loro priorità nella coda verrà ridotta, consentendoci di scansionare più domini da IP diversi e di non rimanere bloccati su una link farm.

- Per proteggere i siti web ed evitare di inquinare i nostri report con link simili, controlliamo se ci sono troppi URL dallo stesso dominio. Se vediamo troppi URL dello stesso dominio, questi non verranno scansionati tutti nello stesso giorno.

- Per assicurarci di scansionare nuove pagine il prima possibile, tutti gli URL che non abbiamo scansionato in precedenza avranno maggiore priorità.

- Ogni pagina ha il proprio codice hash che ci aiuta a dare la priorità alla scansione di contenuti unici.

- Teniamo conto della frequenza con cui vengono generati nuovi link nella pagina di origine.

- Teniamo conto del punteggio di autorità di una pagina web e di un dominio.

Come viene migliorata la coda

- Più di 10 diversi fattori filtrano i link non necessari.

- Più pagine uniche e di alta qualità, grazie ai nuovi algoritmi per il controllo della qualità.

Crawler

I nostri crawler seguono link interni ed esterni su Internet alla ricerca di nuove pagine con collegamenti. Pertanto, possiamo trovare una pagina solo se in essa è presente un link in entrata.

Analizzando il nostro precedente sistema, abbiamo visto un'opportunità per aumentare la capacità di scansione complessiva e trovare contenuti migliori - i contenuti che i proprietari di siti web vorrebbero che scansionassimo e indicizzassimo.

Cosa abbiamo fatto?

- Triplicato il nostro numero di crawler (da 10 a 30)

- Interrotto la scansione delle pagine con parametri URL che non influiscono sul contenuto della pagina (&sessionid, UTM, ecc.)

- Aumentato la frequenza di lettura dei file robots.txt sui siti web

Come sono migliorati i Crawler

- Più crawler (ora sono 30!)

- Dati puliti senza spazzatura o link duplicati

- Ricerca dei contenuti più rilevanti migliorata

- Velocità di scansione di 25 miliardi di pagine al giorno

Spazio di archiviazione

Lo spazio di archiviazione è dove conserviamo tutti i link che puoi vedere come utente di Semrush. Questo spazio di archiviazione ti mostra i link nello strumento e ti offre filtri che puoi applicare per trovare ciò che stai cercando.

La preoccupazione principale che avevamo con il nostro vecchio sistema di archiviazione era che poteva essere riscritto completamente solo dopo l'aggiornamento. Ciò significava che ogni 2-3 settimane veniva riscritto e il processo ricominciava da capo.

Pertanto, durante l'aggiornamento, nuovi link si accumulavano nella memoria intermedia, creando un ritardo nei dati dello strumento visibili agli utenti. Volevamo vedere se potevamo migliorare la velocità in questo passaggio.

Cosa abbiamo fatto?

Per migliorare il processo, abbiamo riscritto l'architettura da zero. Per eliminare la necessità di archiviazione temporanea, abbiamo aumentato il nostro numero di server di oltre quattro volte.

Ciò ha richiesto oltre 30.000 ore di progettazione per implementare le tecnologie più moderne. Ora, abbiamo un sistema scalabile che non raggiungerà il limite né ora né in futuro.

Come è migliorato lo spazio di archiviazione

- Più di 500 server totali

- 287 TB di memoria RAM

- 16.128 nuclei

- 30 PB di spazio di archiviazione totale

- Filtraggio e reporting velocissimi

- AGGIORNAMENTO ISTANTANEO - niente più archiviazione temporanea

Studio del database di backlink

Abbiamo condotto uno studio in due parti confrontando la velocità del nostro Analisi backlink con Moz, Ahrefs e Majestic.

Per vedere esattamente quanto è più veloce il nostro strumento rispetto agli altri strumenti SEO sul mercato, leggi questo post del blog.

Siamo così orgogliosi del nuovo database del nostro Analisi backlink che vogliamo che tutti possano sperimentare ciò che ha da offrire.

Ottieni l'accesso GRATUITO semplicemente registrandoti con un account Semrush gratuito e la sezione Analisi backlink ti sarà completamente aperta.

Provalo e facci sapere cosa ne pensi!

Benvenuto nel futuro della gestione dinamica dei backlink!