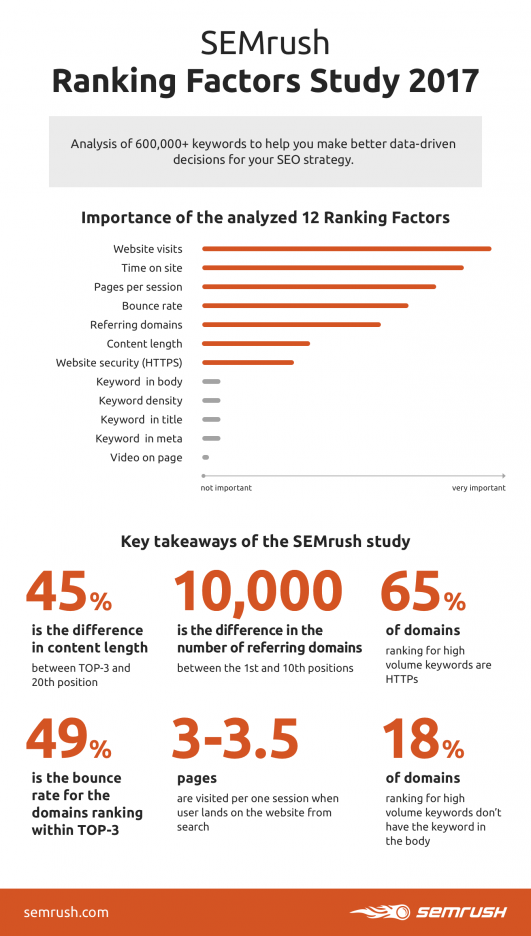

Per la seconda edizione di SEMrush Ranking Factors Study 2017 abbiamo aggiunto altri 5 fattori relativi ai backlink e cercato di capire quanto influenzino il ranking di un particolare URL rispetto al ranking dell’intero dominio. Come da tradizione, ti offriamo uun approfondimento sulla nostra metodologia di ricerca.

Quando a giugno è stata pubblicata la prima edizione dello studio, molte persone sono rimaste incredule: le visite dirette sul sito sono generalmente considerate il risultato di posizioni in SERP alte e non viceversa, eppure…

Eppure le visite sul sito sono esattamente ciò che il nostro studio ha confermato essere il più importante fattore di ranking per Google, tra tutti quelli che abbiamo analizzato, entrambe le volte.

Inoltre, la metodologia usata era unica nel campo degli studi SEO: abbiamo sostituito l'analisi di correlazione con l'algoritmo automatico Random Forest.

Poiché l’obiettivo finale del nostro studio è stato quello di aiutare i SEO a stabilire le priorità dei loro compiti ed eseguire in modo più efficace le loro attività di ottimizzazione, vorremmo rivelare i dettagli della ricerca e abbattere alcuni pregiudizi, in modo che tu possa tranquillamente fare affidamento sui nostri takeaway.

Scherzi a parte, questo post è per veri nerd, quindi ecco un breve glossario:

Albero di decisione (Decision tree) - una struttura ad albero che rappresenta un algoritmo di apprendimento automatico normalmente applicato alle attività di classificazione. Divide un set di dati campione in gruppi / sottoinsiemi omogenei, basati sugli attributi più significativi.

Apprendimento automatico supervisionato - un tipo di algoritmo di apprendimento automatico che definisce un modello per trovare relazioni, lineari o no, nel rapporto tra variabili d'ingresso (caratteristiche, A) e variabile di uscita (valore di destinazione, B): B = f (A). L'obiettivo dell’apprendimento supervisionato è quello di formare questo modello su un campione dei dati in modo che, quando vengano analizzati dati fuori campione, l'algoritmo sia in grado di predire il valore di destinazione in modo preciso, in base alle impostazioni date. Il dataset di training rappresenta l'insegnante che cura il processo di apprendimento. La formazione termina quando l'algoritmo raggiunge una qualità di esecuzione accettabile.

Caratteristiche (o variabili, o variabili di input) - sono le variabili indipendenti utilizzate nell'analisi. Per il nostro studio e per questo post, le caratteristiche sono i presunti fattori di ranking.

Classificazione binaria - un tipo di attività di classificazione che rientra nella categoria di apprendimento supervisionata. L'obiettivo di questa attività è quello di predire un valore di destinazione (= classe) per ogni dato in entrata, e per la classificazione binaria può essere solo 1 o 0.

Utilizzo dell’algoritmo Random Forest per lo studio dei Ranking Factors

L' algoritmo Random Forest è stato sviluppato da Leo Breiman e Adele Cutler a metà degli anni '90. Da allora non ha subito grandi cambiamenti, il che dimostra la sua elevata qualità e universalità: viene utilizzato per classificazioni, regressioni, clustering, selezione delle funzioni e altre attività.

Sebbene l'algoritmo Random Forest non sia ben noto al grande pubblico, lo abbiamo scelto per una serie di buone ragioni:

-

È uno degli algoritmi di apprendimento automatico più diffusi, che offre una precisione imbattibile. La sua prima e principale applicazione è classificare l'importanza delle variabili (e la sua natura è perfetta per questo compito, come scopriremo presto in questo post), quindi è sembrata una scelta ovvia.

-

L'algoritmo tratta i dati in un modo che minimizza gli errori:

-

Il metodo dei sottospazi casuali offre a ciascun "allievo" un campionario random di funzionalità, non tutte. Ciò garantisce che non sarà troppo concentrato su un set prestabilito di funzionalità e non prenderà decisioni considerando un set di dati fuori campione.

-

Il bagging o metodo di aggregazione bootstrap migliora anche la precisione. La sua caratteristica principale è analizzare non un intero dataset, ma campioni casuali di dati.

-

Dato che non abbiamo un solo albero di decisione, ma piuttosto un'intera foresta di centinaia di alberi, possiamo essere certi che ciascuna funzionalità e ogni coppia di domini saranno analizzati approssimativamente lo stesso numero di volte. Pertanto, il metodo Random Forest è stabile e funziona con errori minimi.

L’approccio Pairwise: Pre-Elaborazione dei dati di Input

Abbiamo deciso di basare il nostro studio su un insieme di 600.000 parole chiave dei database di tutto il mondo (Stati Uniti, Spagna, Francia, Italia, Germania e altri), sui dati di posizionamento dell'URL per i primi 20 risultati di ricerca e su un elenco di presunti fattori di ranking. Visto che non avremmo usato l'analisi di correlazione, abbiamo dovuto condurre una classificazione binaria prima di applicare l'algoritmo di apprendimento automatico. Questo compito è stato implementato con l'approccio Pairwise, uno dei metodi di apprendimento automatico più apprezzati per la classificazione, utilizzato, tra gli altri, da Microsoft nei suoi progetti di ricerca.

L'approccio Pairwise implica che, invece di esaminare un intero set di dati, ciascuna SERP viene studiata singolarmente: confrontiamo tutte le possibili coppie di URL (il primo risultato della pagina con il quinto, il settimo risultato con il secondo, ecc.) per ciascuna caratteristica. A ogni coppia viene assegnata una serie di valori assoluti, in cui ogni valore è un quoziente dopo la suddivisione del valore della caratteristica del primo URL per il valore della caratteristica del secondo URL. Inoltre, a ogni coppia è assegnato un valore di destinazione che indica se il primo URL è posizionato più in alto rispetto al secondo in SERP (valore di riferimento = 1) o più in basso (valore di destinazione = 0).

Risultati del procedimento:

-

Ogni coppia di URL riceve un insieme di quozienti per ogni caratteristica e un valore di destinazione 1 o 0. Questa lista di numeri verrà utilizzata come un set di dati di formazione per gli alberi decisionali.

-

Ora siamo in grado di effettuare osservazioni statistiche sul fatto che determinati valori delle funzioni e loro combinazioni tendono a determinare una posizione più elevata in SERP per un URL. Ciò ci consente di costruire un'ipotesi sull'importanza di determinate funzionalità e fare una previsione su come un certo insieme di valori delle funzioni porterà a un ranking più elevato.

Espandendo l'insieme degli alberi di decisione: Apprendimento supervisionato

Il dataset che abbiamo ricevuto dopo il passaggio appena visto è assolutamente universale e può essere utilizzato per qualsiasi algoritmo di apprendimento automatico. La nostra scelta era Random Forest, un insieme di alberi decisionali.

Prima che gli alberi possano prendere decisioni ragionevoli, devono allenarsi: questo avviene quando entra in funzione l’apprendimento automatico.

Per assicurarsi che l'allenamento avvenga correttamente e che le decisioni sul set di dati principale siano imparziali, vengono utilizzati i metodi di Bagging e di Random subspace.

Il Bagging è il processo di creazione di un set di dati di formazione mediante campionamento con sostituzione. Diciamo che abbiamo X righe di dati. Secondo i principi di Bagging, creeremo un set di dati di training per ogni albero decisionale e questo insieme avrà lo stesso numero di righe X.

Tuttavia, questi set di campioni saranno popolati in modo casuale e con sostituzione - si includono così solo circa i due terzi delle righe X originali e ci saranno duplicati di valore. Circa un terzo dei valori originali rimarrà intatto e verrà utilizzato una volta che l'apprendimento sarà finito.

Abbiamo fatto la stessa cosa per le caratteristiche usando il metodo Random subspace - gli alberi decisionali sono stati addestrati su campioni casuali di funzionalità anziché sull'intero set.

Un singolo albero non utilizza l'insieme di dati e l'intero elenco di funzionalità. Ma avere una foresta di alberi multipli ci permette di dire che molto probabilmente ogni valore e ogni funzione verranno utilizzati approssimativamente la stessa quantità di volte.

Espandendo la foresta

Ogni albero decisionale riprende la divisione del set di dati del campione di formazione in base alla variabile più importante e lo fa fino a quando ciascun sottoinsieme non è costituito da voci di dati omogenei. L'albero esegue la scansione dell'insieme di dati di formazione e sceglie la caratteristica più importante e il suo valore preciso, che diventa un tipo di punto di pivot (nodo) e divide i dati in due gruppi.

Per un gruppo la condizione scelta in precedenza è vera; per l'altro falsa (rami SI e NO). Tutti i sottogruppi finali (nodi foglia) ricevono un valore medio di destinazione in base ai valori di destinazione delle coppie di URL che sono state collocate in un determinato sottogruppo.

Poiché gli alberi utilizzano il set di dati del campione per crescere, imparano mentre crescono. Il loro apprendimento è considerato un successo e di alta qualità quando viene raggiunta una percentuale target di valori di destinazione correttamente indovinati.

Una volta che l'intero insieme di alberi è cresciuto e addestrato, inizia la magia: gli alberi sono ora autorizzati a elaborare i dati fuori campione (circa un terzo del set di dati originali). Una coppia di URL viene offerta ad un albero solo se non ha incontrato la stessa coppia durante l'allenamento. Ciò significa che una coppia di URL non viene offerta al 100% degli alberi della foresta. Quindi, si effettua la votazione: per ogni coppia di URL, un albero dà il suo verdetto, ovvero la probabilità che un URL ottenga un posizionamento più elevato nella SERP rispetto al secondo. La stessa azione viene attuata da tutti gli altri alberi che soddisfano il requisito "Non aver visto prima quella coppia di URL" e alla fine ogni coppia ottiene un insieme di valori di probabilità. Quindi viene calcolata la media per tutte le probabilità ricevute. Ora ci sono dati sufficienti per il passo successivo.

Stima dell'importanza degli attributi con Random Forest

Random Forest produce risultati estremamente credibili quando si tratta di stime di importanza. La valutazione è condotta come segue:

-

I valori degli attributi sono mixati in tutte le coppie di URL e questi set aggiornati di valori vengono offerti all'algoritmo.

-

Ogni cambiamento nella qualità o nella stabilità dell’algoritmo viene misurato (se la percentuale di valori target correttamente indovinati resta uguale o meno).

-

Quindi, sulla base dei valori ricevuti, si possono trarre delle conclusioni:

-

Se la qualità dell'algoritmo si abbassa in modo significativo, l'attributo è importante. In questo caso più è pesante il crollo della qualità, più importante è l'attributo.

-

Se la qualità dell'algoritmo rimane la stessa, l'attributo è di importanza minore.

La procedura viene ripetuta per tutti gli attributi. Come risultato, si ottiene una valutazione dei principali fattori di ranking.

Perché crediamo che l’analisi di correlazione non vada bene per gli studi sui Ranking Factors

Abbiamo abbandonato intenzionalmente la pratica generale di utilizzo dell'analisi della correlazione e abbiamo ricevuto alcuni commenti come "Correlazione non significa causalità", "Non sembrano fattori di ranking, ma più correlazioni". Crediamo che questo punto meriti un paragrafo a parte.

Innanzitutto, vorremmo sottolineare di nuovo che il dataset iniziale utilizzato per lo studio è un insieme di valori molto variabili. E ricordiamo che abbiamo esaminato non una, ma 600.000 SERP. Ogni SERP è caratterizzata dal suo valore di attributo medio e questa unicità è completamente ignorata nel processo di analisi delle correlazioni.

Detto questo, crediamo che ogni SERP debba essere trattata separatamente e rispettando le sue particolarità.

L'analisi di correlazione fornisce risultati affidabili solo quando esamina la relazione tra due variabili (ad esempio, l'impatto del numero di backlink sul posizionamento in SERP). "Questo fattore particolare influenza il posizionamento?" questa domanda può essere risolta abbastanza precisamente in quanto è coinvolta l'unica variabile impattante. Ma siamo in grado di studiare ogni fattore in modo isolato? Probabilmente no, come tutti sappiamo c'è un insieme di fattori che influenzano la posizione di un URL in SERP.

Un altro criterio di qualità per l'analisi della correlazione è la varietà dei rapporti di correlazione ricevuti. Ad esempio, se esiste una serie di rapporti di correlazione come (-1, 0,3 e 0,8), è abbastanza giusto dire che esiste un parametro più importante degli altri.

Più vicino è il valore assoluto del rapporto, o il modulo, a uno, maggiore è la correlazione. Se il modulo del rapporto è inferiore a 0,3, tale correlazione può essere ignorata - la dipendenza tra le due variabili, in questo caso, è troppo debole per trarre conclusioni affidabili.

Per tutti i fattori analizzati, il rapporto di correlazione era inferiore a 0,3, quindi abbiamo dovuto cambiare metodo.

Un altro motivo per respingere questo metodo di analisi è stato l'alta sensibilità del valore di correlazione alle anomalie e i rumori, e i dati per varie parole chiave ne suggeriscono molti. Se un dato di entrata extra viene aggiunto al set di dati, il rapporto di correlazione cambia immediatamente. Quindi questa metrica non può essere valida nel caso di variabili multiple, ad esempio in uno studio di fattori di ranking e può anche portare a deduzioni erronee.

Infine, è difficile credere che uno o due fattori con un modulo di rapporto di correlazione così vicino a 1 esistano - se questo fosse vero, chiunque potrebbe facilmente decodificare gli algoritmi di Google e saremmo tutti nella posizione 1!

Domande frequenti

Anche se abbiamo cercato di rispondere alla maggior parte delle domande sollevate con più frequenza, qui ce n’è qualcuna in più per i lettori più curiosi.

Perché non abbiamo usato le reti neurali artificiali (ANN)?

Anche se le reti neurali artificiali sono perfette per attività con un gran numero di variabili, ad esempio il riconoscimento delle immagini (dove ogni pixel è una variabile), producono risultati difficili da interpretare e non consentono di confrontare il peso di ciascun fattore. Inoltre, le ANN richiedono un insieme di dati massiccio e un gran numero di funzionalità per produrre risultati affidabili e i dati di input che abbiamo raccolto non corrispondono a questa descrizione.

A differenza di Random Forest, dove ogni albero decisionale vota in modo indipendente, e quindi è garantito un elevato livello di affidabilità, le reti neurali elaborano i dati in un unico contenitore. Niente indica che l'utilizzo di ANN per questo studio avrebbe portato a risultati più accurati.

I nostri requisiti principali per un metodo di ricerca erano la stabilità e la capacità di identificare l'importanza dei fattori. Detto questo, Random Forest è stato perfetto per il nostro compito, cosa che è dimostrata da numerosi task di ranking di natura simile, realizzati anche con l'aiuto di questo algoritmo.

Perché le visite al sito web sono il fattore di ranking più importante per Google?

Senza alcun dubbio, questo è probabilmente il punto più controverso del nostro studio. Quando abbiamo visto i risultati della nostra analisi, siamo rimasti altrettanto sorpresi. Allo stesso tempo, il nostro algoritmo è stato addestrato su una vasta gamma di dati, quindi abbiamo deciso di ricontrollare tutto due volte. Abbiamo escluso i dati di ricerca organica e quelli a pagamento, così come il traffico social e referral e tenuto conto solo del traffico diretto: i risultati sono stati quasi uguali, la distribuzione delle posizioni è rimasta invariata (i grafici a pagine 25-26 dello studio illustrano questo punto).

Per noi questa ricerca ha senso e conferma che Google assegna priorità ai domini più autorevoli, come descritto nelle sue Search Quality Evaluator Guidelines. Anche se può sembrare che l'autorità di dominio sia un concetto molto vago ed effimero, queste linee guida abbattono completamente questo mito. Nel 2015, Google introdusse questo manuale per aiutare a stimare la qualità di un sito e "riflettere quello che Google pensa che gli utenti che fanno una ricerca desiderano".

Il manuale indica E-A-T, competenza (Expertise), autorevolezza (Authoritativeness) e affidabilità (Trustworthiness), come un importante indicatore della qualità delle pagine web. Qualità e quantità dei contenuti principali, informazioni sul sito web (cioè chi è responsabile del sito) e reputazione del sito influenzano l'E-A-T di un sito web. Suggeriamo di pensare nel seguente modo: se un URL si classifica tra i primi 10, di default, vuol dire che contiene contenuti pertinenti a una query di ricerca dell’utente.

Ma per distribuire i piazzamenti tra questi dieci leader, Google inizia a contare i parametri aggiuntivi. Sappiamo tutti che c'è una squadra di Quality rater dietro le quinte, responsabile della formazione degli algoritmi di ricerca di Google e del miglioramento della pertinenza dei risultati di ricerca. Come suggerito dalle Linee guida di valutazione della qualità di Google, i rater dovrebbero dare priorità alle pagine di alta qualità e insegnare agli algoritmi a fare lo stesso.

Quindi, l'algoritmo di classificazione è addestrato per assegnare una posizione più elevata a pagine che appartengono a domini attendibili e altamente autorevoli, e riteniamo che questo possa essere il motivo dietro i dati ricevuti per il traffico diretto e la sua importanza come segnale.

Per approfondire puoi leggere il blog post Quality rater: guida agli standard di qualità di Google.

Ma non è finita qui: alla recente conferenza di SMX East, Gary Illyes di Google ha confermato che "il modo in cui le persone percepiscono il tuo sito influenzerà la tua attività". E sebbene questo, secondo Illyes, non influisca necessariamente su come Google classifica il tuo sito, sembra ancora importante investire nel guadagnare la fedeltà degli utenti: Utenti felici = Google felice.

The Google algorithm is like a human. It looks at brand sentiment and online reputation to understand your website better. @methode #SMX

— Ari Finkelstein (@arifinkels) October 26, 2017

Cosa significa? Beh, la brand awareness (stimata, tra le altre cose, in base al numero di visite dirette sul sito) influenza fortemente il ranking e merita di ricevere i tuoi sforzi al pari della SEO.

Differenze nell’impatto sui fattori di ranking tra keyword branded e non-branded

Come hai potuto notare, ogni grafico del nostro studio ha un picco notevole per la seconda posizione. Abbiamo promesso di approfondire questa deviazione e quindi abbiamo aggiunto una nuova dimensione alla ricerca. La seconda edizione riguarda l'impatto dei tre fattori più importanti (visite dirette sul sito, tempo sul sito e numero di domini di provenienza) sul ranking di un particolare URL, piuttosto che sul dominio in cui risiede.

Si suppone che i siti web in prima posizione siano i più ottimizzati, eppure abbiamo visto che ogni linea di tendenza aveva un calo nella prima posizione.

Abbiamo connesso questa deviazione con le query di ricerca di parole chiave branded. Un dominio probabilmente prenderà la prima posizione in SERP per qualsiasi query di ricerca che contiene le sue parole chiave branded. E indipendentemente da quanto sia ottimizzato un sito web, sarà comunque il primo, quindi non ha nulla a che fare con gli sforzi SEO.

Questo spiega perché i fattori di ranking influenzano una seconda posizione in SERP più della prima.

Per dimostrare questo, abbiamo deciso di esaminare i nostri dati da una nuova prospettiva: abbiamo studiato come i fattori di ranking influenzino singoli URL che appaiono in SERP. Per ciascun fattore abbiamo costruito grafici separati che mostrano la distribuzione di URL e domini nelle prime 10 posizioni in SERP (vedi pp. 34-35). Anche se lo studio include i grafici solo per i 3 fattori più influenti, la tendenza che abbiamo scoperto persiste anche per gli altri fattori.

Cosa significa questo per te che sei un marketer? Quando un dominio è classificato per una parola chiave branded, molti fattori perdono la loro influenza. Tuttavia, quando ottimizzi per keyword non-branded, tieni presente che i fattori di ranking analizzati hanno maggiore influenza sulle posizioni dell'URL singolo che sul dominio in cui risiede. Ciò significa che i ranking di una pagina particolare sono più sensibili all'ottimizzazione on-page, agli sforzi di link building e ad altre tecniche di ottimizzazione.

Conclusione: come usare lo studio sui Fattori di Ranking di SEMrush

Non c’è alcuna garanzia che se migliori le metriche del tuo sito web per uno qualsiasi dei fattori di cui sopra, le tue pagine inizieranno a posizionarsi più in alto. Abbiamo condotto uno studio molto approfondito che ci ha permesso di trarre conclusioni affidabili sull'importanza di questi 17 fattori per posizionarsi ai primi posti delle SERP di Google. Eppure, questo è solo un buon lavoro di ingegneria inversa, non un piano d'azione universale. Solo Google conosce tutti i segreti.

Tuttavia, qui c’è un flusso di lavoro che ti suggeriamo di utilizzare:

Step 1. Scopri per quali parole chiave ti sei posizionato - Fanno parte di gruppi con volume di ricerca basso, medio o alto?

Step 2. Fai con confronto con la concorrenza: dai un'occhiata più approfondita ai metodi che utilizzano i tuoi competitor e alle loro metriche per colpire i primi 10 - Hanno molti backlink? I loro domini sono protetti con HTTPS?

Step 3. Utilizzando lo studio, seleziona e inizia l'implementazione delle tecniche di ottimizzazione che offriranno i migliori risultati in base alle tue parole chiave e al livello di concorrenza sulle SERP.

Ancora una volta, ti invitiamo a dare un'occhiata più approfondita al nostro studio, riconsiderare il concetto E-A-T e preparare una buona strategia SEO basata sui fatti!

[ranking-factors]

Quali fattori vorresti che analizzassimo nella prossima edizione del nostro studio?

Faccelo sapere nei commenti!