Strategie "Tips&tricks" per migliorare il posizionamento On site

Sappiamo benissimo quanto importanti siano ancora oggi i link esterni e i contenuti di un sito, per accrescerne il suo posizionamento per le parole chiave di riferimento.

I link influiscono oggi ancora molto, ma gli aspetti on site, quelli cioè legati all'ottimizzazione tecnica della pagina web e alla valorizzazione dei contenuti, contano almeno per un buon 60% di tutta l'attività SEO che un brand dovrebbe sviluppare.

Chi si occupa di SEO sa benissimo quali sono i fattori on site che influenzano il posizionamento sui motori di ricerca, tra i quali:

- il testo che targetizza una o più parole chiave;

- la presenza della keyword nei tag e meta tag SEO, come title, heading tags di testo (H1, H2, ecc.), link interni, url, e formattazione immagini;

- il tempo di scaricamento e composizione della pagina;

- il fatto che la pagina sia accessibile ai bot e non bloccata da istruzioni noindex nel robot o negli header della stessa;

- la presenza di contenuti duplicati da altre fonti, in modo parziale o sostanziale, che potrebbero essere filtrati da Google;

- una migrazione di template o di dominio non svolta correttamente

- la presenza di malware nel sito;

- la presenza di problemi connessi all' hosting del sito;

- ecc.

Ci sono tuttavia alcune piccole strategie che possono essere seguite per migliorare (e consolidare) il proprio posizionamento sui motori di ricerca, di cui spesso non si parla o si parla poco.

Vediamone alcune.

1# Gestire le Risorse del sito non utili al ranking

Nel momento in cui un sito cresce di dimensioni, aumenta la probabilità che vengano prodotte e indicizzate pagine (url) che non apportano alcun valore all'utente e al bot.

L'utente infatti probabilmente non accederà mai da una query a quella url. D'altro canto però, la url verrà comunque indicizzata e sottoposta a scansione del bot. Quelle pagine non utili ai ranking, avranno anch'esse una porzione del crawl budget del sito, che potrebbe invece essere destinato alle risorse realmente più importanti.

Per crawl budget di un sito si intende il valore di scansione che ha un sito per il bot di un motore di ricerca, in termini di capacità di quest'ultimo, di scaricare kilobyte dal nostro web server e di scansionare file html, css, pdf, javascript, ecc.

Per migliorare il tuo posizionamento sui motori di ricerca devi tenere in considerazione che ogni sito ha un suo crawl budget che dipende dall'autorevolezza del dominio e dalla qualità dei link che costituiscono il suo link profile. Un alto crawl budget permette al sito di avere un maggiore priorità di scansione e, soprattutto, di averla a livello di profondità del sito.

Perché è importante il crawl budget per il posizionamento su Google?

Per i siti di medio-grandi dimensioni, avere un buon crawl budget sulle pagine giuste permette di avere un'alta priorità nella scansionee velocità nell'indicizzazione che, per nicchie di mercato profittevoli, può fare la differenza nel fatturato.

Come puoi immaginare, se facciamo assorbire al bot anche una serie di pagine non utili, il budget dell'intero sito andrà a ripartirsi tra tutte le centinaia o migliaia di url rilasciate dal sito.

Questo problema è molto comune nei CMS, negli eCommerce e, potremmo dire, in un po' tutti i siti medio-grandi.

I problemi più comuni che possono compromettere il posizionamento nei motori di ricerca di un sito riguardano:

- pagination;

- navigazione a faccette (faceted navigation);

- pagine archivio;

- ricerca interna;

- pagine tag.

1. Pagination e Pagine archivio.

Questo problema riguarda solitamente blog, magazine, giornali online e ecommerce. Quando il numero di pagine afferenti ad una determinata categoria o argomento sono numerose, si rende necessario suddividere le stesse in altre pagine di catalogazione. Ti capiterà di notarle quando vedi una struttura url di questo tipo: www.miosito.com/blog/page/3/.

Il verificarsi di questa situazione compromette il posizionamento perché queste pagine apportano poco valore all'utente, che potrebbe, anziché scorrersi tutte le pagine di archiviazione per trovare la notizia di interesse, trovarla direttamente da una query sul motore che lo rimanda sulla landing page specifica, o trovarla dal motore di ricerca interno allo stesso sito.

Apportano ancora meno valore al bot perché, presentando porzioni di testo riferite a pagine già indicizzate da Google, aumentano la presenza di duplicazione di testo.

Come gestire la Pagination

Google consiglia di usare i link rel="prev" e "next" per consolidare l'indicizzazione delle pagine archivio e evitare duplicazioni.

A tutti gli effetti, per il bot trovare il rel prev e next negli header della pagina serve ad identificare una sequenza di pagine che verranno trattate come un blocco unico, le cui pagine singole possono però essere indicizzate e ogni eventuale link o altro segnale acquisito da una di queste pagine verrà condiviso con tutte quelle legate dal blocco rel prev/next.

Tecnicamente, la struttura prevede l'aggiunta del link rel="prev" e link rel="next", dove rel="prev indicherà la pagina di archivio precedente e rel="next" quella successiva, come nell'esempio che segue.

<link rel='prev' href='http://www.miosito.it/blog/' />

<link rel='next' href='http://www.miosito.it/blog/page/3/' />

Tuttavia, alcuni siti possono essere progettati comprendendo anche una pagina di visualizzazione completa (degli articoli o dei prodotti), la cosiddetta pagina "Visualizza tutti".

In questo caso può essere ancor più conveniente ai fini del posizionamento sui motori di ricerca far indicizzare la pagina di visualizzazione completa degli articoli ed inserire il link rel "canonical" alle singole pagine di archiviazione che rimandano alla pagina "Visualizza tutti".

Google consiglia di adottare quest'ultima soluzione per i siti dotati anche della pagina "View all".

Personalmente però, propendo spesso per una soluzione differente. Effettivamente le pagination produrranno quasi sempre per un sito poco traffico, o alcuno, anche per via del fatto che non sono ottimizzate per una keyword specifica (spesso infatti le keywords che targetizzeranno nel title tag saranno del tipo "nome sito - pag 2", "nome sito - pag 3", ecc.).

Farle indicizzare vuol dire anche distribuirgli del pagerank e del crawl budget che, invece, potrebbero essere allocati sulle risolse realmente utili al ranking.

Preferisco quindi evitare proprio di indicizzarle.

In questo caso è possibile utilizzare un noindex negli header delle pagine superiori alla prima (per le pagination dalla seconda in avanti, se la struttura del sito ha una root con una folder "Blog" o "News") o un rel "canonical" che rimanda alla versione canonical del listato. Agendo in questo modo non vedrai compromesso il tuo posizionamento sui motori di ricerca a causa della pagination.

2. Navigazione a Faccette (faceted navigation)

La navigazione a faccetta è quella che ti permette di filtrare, all'interno di un sito, l'ordinamento con cui visualizzi determinati prodotti.

I filtri possono essere tanti a seconda della tipologia di prodotto o articolo che viene venduto. I più comuni riguardano:

- prezzo;

- valutazioni;

- peso;

- colore;

- taglia;

- ecc.

Le insidie dietro lo strumento dei filtri a faccette (cosa, a livello di usabilità, super utile) è legato al fatto che, molto spesso, il click su di un filtro da parte dell'utente - ad esempio quello del prezzo - genera una nuova pagina (o url) che viene indicizzata dai motori di ricerca.

La nuova pagina è identica a quella canonica (presentata cioè all'utente al primo accesso nella pagina di categoria), salvo per il fatto che la sintassi della url presenta al suo interno anche i parametri aggiunti dall'utente, ad esempio:

/page/2/?orderby=rating

Come potrai immaginare, non ci conviene far assorbire queste pagine al bot per i motivi ben noti (duplicazione, dispersione pagerank e crawl budget), che andranno a influire negativamente sul posizionamento del tuo sito nei motori di ricerca.

Puoi risolvere il problema in due modi: uno lo definisco a monte, ovvero in fase di progettazione del sito e l'altro a valle, ovvero come risoluzione successiva alla generazione del problema.

Partiamo dalla seconda soluzione, che non è proprio quella "ottimale" ma più un modo per "correre ai ripari" e che chi fa SEO solitamente implementa quando il sito è già stato progettato e non ha modo di intervenire - o far intervenire - sulla modifica di determinate sezioni dello stesso.

Per le url generate da faceted navigation possiamo agire in tre modi:

1. rel canonical puntante alla pagina canonica del listato;

2. blocco dei parametri da Search Console;

3. noindex negli header o direttiva "disallow" nel robots.txt (istruzioni che nasconderanno le url dalle serp, ma che non impediranno la loro deindicizzazione. Per quello bisognerà anche associare uno status code "410" alle singole url).

C'è però un problema, che potrebbe avere ripercussioni sul posizionamento nei motori di ricerca del sito: il rel canonical, comunemente più utilizzato in questi casi, è un consiglio che viene dato al bot, non un obbligo. Non è detto che segua alla lettera quanto gli diamo in pasto.

La soluzione migliore sarebbe dunque a monte, ovvero in fase di progettazione del sito, evitando la costruzione di filtri di navigazione che generano nuove urls.

È possibile farlo progettando questi menu con JSON e Jquery affinché il filtro avvenga lato client.

Quando si utilizza Json e Jquery, il filtro avviene sul dispositivo client, senza coinvolgere il web server, come rappresentato nell'immagine seguente.

La pagina viene trasferita al browser da cui l'utente ha richiesto la risorsa. Tecnicamente avviene una richiesta di Jquery per il data object Json e l'interazione avviene direttamente nel browser del client, grazie al codice trasferito durante la prima richiesta, e non nel server web, evitando quindi la creazione di nuove pagine e nuove url che i motori di ricerca potrebbero assorbire.

Alternativa, forse anche migliore, è quella di utilizzare Ajax.

3. Pagine Archivio

Sono quelle pagine che archiviano i contenuti per anno e mese.Anche queste pagine non le ritengo utili al posizionamento sui motori di ricerca. Di conseguenza preferisco non farle indicizzare.

4. Ricerca interna al sito

La ricerca interna al sito è utile agli utenti, meno ai bot. Ogni volta che un utente effettua una ricerca sul sito la url restituita porterà con sé il parametro con la chiave di ricerca digitata dall'utente, producendo una pagina con contenuti parzialmente duplicati e che potrebbe essere indicizzata da Google (soprattutto se dovesse ricevere backlinks).

Anche in questo caso, è opportuno inserire un noindex negli header delle pagine di ricerca.

5. Pagine Tag

Con i tag, soprattutto per blog e giornali online, le scuole di pensiero sono differenti. Averne (e tanti) e farli indicizzare non danneggia il sito, ma diluisce crawl budget e PageRank.

Io preferisco ragionare in ottica di obiettivo. Per quale motivo stiamo utilizzando i tag? Li apponiamo in modo del tutto casuale? Abbiamo possibilità di intercettare traffico organico con le pagine tag?

Se la risposta a quest'ultima domanda è positiva, allora può convenire farli indicizzare.

Pensa a quegli ecommerce o giornali online che, oltre ad avere una buona strutturazione tematica di categorie e sotto-categorie, taggano anche gli articoli con i nomi dei brand. L'associazione tra keyword + nome brand potrebbe intercettare nuove potenziali query degli utenti e portare nuovo traffico al sito.

2# Creare Hub Page da spingere con i link interni per evitare Keyword Cannibalization

Si creano situazioni di keyword cannibalization quando più pagine dello stesso sito arrivano a competere per la stessa parola chiave.

Questa situazione può diventare piuttosto frequente soprattutto per quei siti che pubblicano molti contenuti settimanalmente, su nicchie specifiche e che, alla fine, rischiano di targetizzare - seppur involontariamente - le medesime keyowords.

Se abbiamo una pagina ben posizionata per una query di ricerca e vogliamo fare in modo di non farle competizione e rischiare di superarla con una nuova pagina che targetizza la stessa keyword, dobbiamo fare in modo di linkare dalla nuova pagina a quella vecchia, già ben posizionata, utilizzando come anchor text proprio la parola chiave di interesse.

Ti garantisco che è una strategia che funziona per migliorare il posizionamento sui motori di ricerca, seppur per ovvie ragioni di freschezza del contenuto ( Freshness Update, l'algoritmo di Google introdotto nel 2011), col passare del tempo Google tenderà a dare maggior rilevanza a notizie e contenuti più recenti.

Le Hub Pages

Altra ottima strategia on site ai fini del posizionamento è quella di costruirsi delle pagine hub che trattano specifiche chiavi di ricerca, solitamente quegli argomenti di cui si è soliti pubblicare contenuti in modo più frequente e che possono risultare molto utili per i grandi giornali e magazine online.

Le hub page possono essere pagine di categoria, di sotto-categoria o tag che possono essere spinte grazie ai link interni

I link interni non proverranno soltanto da tutti gli articoli che tratteranno quell'argomento, ma anche da altre sezioni del sito (se ci sono) dalle quali è possibile linkare la hub page.

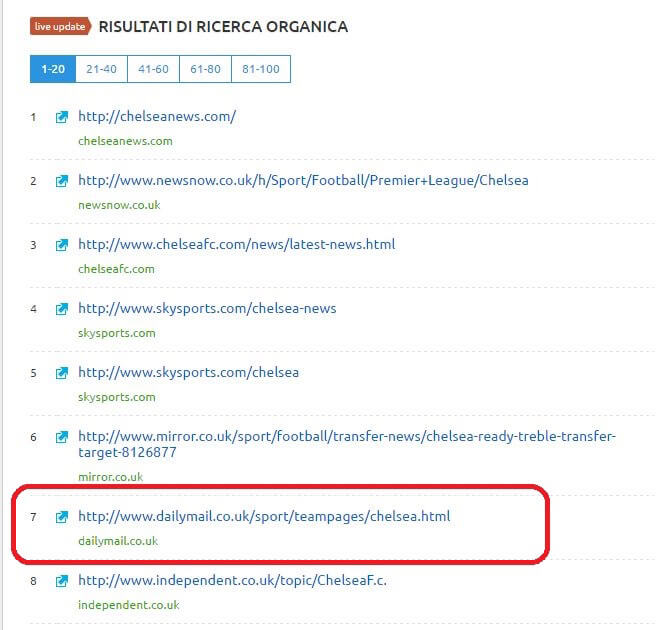

L'esempio che riporto è quello del Mail Online

che rimanda alla Team Page del Chelsea.

Hub page di questo tipo vengono spinte sì dai link interni con anchor text esatta (cosa del tutto lecita finché i link sono interni) ma, soprattutto, hanno maggiori possibilità di posizionarsi grazie alla grossa mole di contenuti prodotti rilevanti per quella chiave.

Infatti, giusto per verificare la presenza del Mail Online su Google Uk per la chiave "Chelsea News"...

3# Tag Title e URL corti, keyword rich e contenuti long form

Una cosa che ho potuto notare più volte è che le url hanno ancora il loro gran bel peso nel posizionamento sui motori di ricerca. Meno del title tag, che probabilmente è il più importante fattore on site, ma ad ogni modo bisognerebbe sempre valorizzarle.

Mi piace utilizzare, soprattutto per blog e siti di news, title tag e url con poche keywords e per targetizzare la chiave primaria, quella cioè composta solitamente da due parole e che ha un volume di traffico maggiore nonché una competitività più alta.

Nel testo invece cerco di sviluppare le chiavi correlate a quella primaria, le cosiddette long tail, ottimizzandone i contenuti e usando anche tag d'intestazione H2 per valorizzarle.

Una cosa è però certa: i contenuti densi fanno la differenza. Non tanto perché avere più testo permette di migliorare il ranking per una parola chiave (il keyword stuffing ha smesso di funzionare molto tempo fa), quanto per il fatto che più testo permetterà di intercettare più combinazioni possibili di keyword long tail che nel suo complesso aumenterà il traffico organico complessivo alla pagina.

Anche gli eCommerce dovrebbero arricchire le schede dei propri prodotti, cosa che spesso non viene implementata e le schede prodotto si ritrovano ad essere identiche a quelle di tanti altri fornitori.

Differenziare le schede prodotto è vitale oggi per gli eCommerce che puntano a un buon posizionamento sui motori di ricerca; crearle ricche di testo può diventare cruciale.

La quantità di testo nelle schede prodotto può essere gestita sviluppando un dropwdown menu con toggle button in jquery che permettono all'utente di espandere le varie sezioni soltanto se vuole approfondire determinate informazioni, ma per il bot sarà testo puro di cui cibarsi.

4# Migliorare il posizionamento aggiornando pagine già pubblicate con contenuti "freschi"

Un'ottima strategia per migliorare i rankings dei siti editoriali è quella di analizzarsi le pagine meno ottimizzate e che possono essere aggiornate con notizie fresche, novità, ecc. e modificarle.

Possiamo migliorare i post vecchi aggiungendo sia nuovi paragrafi, sia ottimizzarne elementi SEO in precedenza non curati, come title tag e url, questo soprattutto per articoli scritti molti anni prima da chi non si curava della SEO on site.

Ricorda però di mappare tutte le pagine che modificherai e di implementare poi tutti i corretti Redirect 301.

5# Banner e link di affiliazione: quale la giusta strada?

Noto che spesso su questo argomento c'è molta confusione. C'è una netta differenza dal voler monetizzare dalle affiliazioni predisponendo 3 unità pubblicitarie per pagina e avendone invece fino a 10. Soprattutto se il contenuto, realmente utile all'utente (il testo, per capirci) è scarno. Un numero elevato di annunci rischia infatti di compromettere l'esperienza utente e di non giustificare quel posizionamento nelle serp di quella pagina.

Ricorda infatti che dati di engagement come tasso di click sul risultato in serp, tempo sulla pagina e tasso di abbandono sono fattori (in)diretti di ranking per Google ed esiste anche un algoritmo anti-spam, il Page Layout Update, conosciuto anche come "Top Heavy" che arriva a filtrare i siti che presentano troppi annunci ads al top della pagina e che arrivano a distrarre l'utente.

Inoltre tutti i link a banner di affiliazione devono avere il rel nofollow, come da linee guida di Google.

6# A parità di Trust e altri fattori On site, la velocità di pubblicazione premia

L'ultimo punto di questa analisi è quanto spesso diamo per scontato o ci dimentichiamo.

Google premia molto l'anzianità della pagina e quindi, spesso, una pagina che tratta una notizia (indipendentemente da Google News) pubblicata dal primo sito, a cui seguiranno tante altre pagine pubblicate da altri siti che trattano la stessa notizia, avrà maggiori probabilità di mantenere nel tempo il posizionamento acquisito sui motori di ricerca.

Questo, come detto, a parità di trust e ottimizzazione degli altri fattori on site.

Ciò si riflette nel ragionamento che spesso spinge gli eCommerce di grandi dimensioni con feed di prodotti distribuiti da fornitori a lavorare non tanto sull'ottimizzazione on site, quanto sul miglioramento della velocità di assorbimento delle pagine, in quanto quelle che verranno prima assorbite dal bot avranno, nel 90% dei casi, vinto nella gara al fatturato.

Cosa ne pensi di questi tip&tricks per migliorare on site il posizionamento di un sito sui motori di ricerca?

Se hai altri suggerimenti, condividili nei commenti.