Non è un segreto che la maggior parte di chi si occupa di SEO è focalizzato esclusivamente su Google, dato che il traffico organico fornito da questo motore di ricerca è nettamente superiore a quello dei concorrenti.

Se il sito non compare in alcuna SERP (Search Engine Results Page), evidentemente il traffico organico sarà pari a zero, nonostante il sito sia perfettamente visibile e funzionante.

Cosa è e come funziona l’indicizzazione?

Per evitare fraintendimenti, chiariamo il significato di indicizzazione: il termine indice dei motori di ricerca equivale ad un database di informazioni su Internet.

I motori di ricerca sono dotati di appositi software o crawlers che si occupano di trovare siti web e relativi links interni, scansionandoli e organizzandoli in un database. Grazie a questa raccolta di dati relativi a miliardi di pagine, Google è in grado di presentare risultati alle queries degli utenti, ma solo ed esclusivamente riferendosi alla propria raccolta.

Proprio per questo motivo dobbiamo renderci conto che una ricerca sui motori di ricerca non sarà mai relativa a tutti i siti web esistenti, ma solo a quelli che risultano già scansionati e indicizzati nel database dei motori di ricerca.

Come si richiede l’indicizzazione di un nuovo sito?

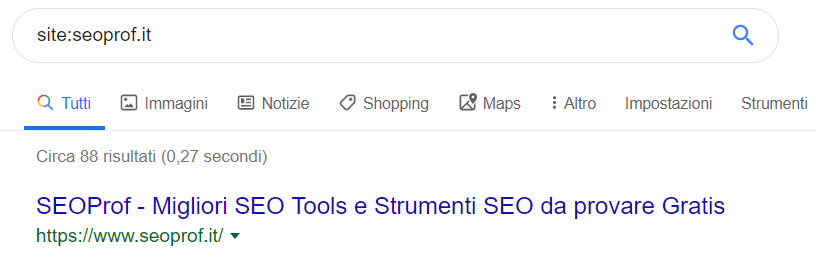

Per verificare se il sito risulta già presente nel database di Google, basta usare l’operatore site: seguito dal nome del dominio.

Bisogna considerare che molti webmaster non si pongono il problema perché scoprono di avere il proprio sito già presente nell’indice di Google senza aver compiuto alcuna specifica azione.

Infatti le strade per ottenere che il proprio sito sia indicizzato sono essenzialmente due.

Il primo metodo consiste nell’inviare una specifica richiesta nell’account Google Search Console e generalmente verrà completata nel giro di poche ore.

Un altro modo per ottenere lo stesso risultato è semplicemente quello di attendere che i motori di ricerca trovino naturalmente il sito e lo indicizzino in totale autonomia. Soprattutto per un nuovo sito che risulta essere ancora sconosciuto, questa fase potrebbe richiedere diverso tempo, anche se esistono degli accorgimenti, che vedremo tra poco, per renderlo più visibile.

Indicizzazione di un sito: gli errori più frequenti

Le cause più comuni che non consentono ad un sito di comparire nei risultati di ricerca sono legate ad una errata gestione dei robots.

Innanzitutto, verifica che il file robots.txt presente nella root del sito non contenga direttive che ne impediscano la scansione. Ad esempio, usando le seguenti istruzioni, si informeranno tutti i crawler (Googlebot, Bingbot, DuckDuckBot, Baiduspider, YandexBot ecc…) di non scansionare alcuna pagina del sito.

User-agent: *

Disallow: /Sostanzialmente, in questo caso il sito non sarà visibile nei motori di ricerca e la soluzione consiste nel rimuovere il forward slash in modo da lasciare libero accesso ai crawler.

Capita anche che per errore sia presente nell’head di tutte le pagine (o solo di alcune) la seguente istruzione:

<meta name="robots" content=" noindex, nofollow ">Un risultato sostanzialmente identico si raggiunge anche con l’inserimento di codice PHP nell’header della pagina tramite:

header("X-Robots-Tag: noindex, nofollow", true);In entrambi i casi si sta dicendo ai motori di ricerca di non scansionare la pagina corrente e di non seguire nemmeno i links interni. A meno che sia un sito da tenere privato, la soluzione è di rimuovere tutte queste istruzioni per lasciare libero accesso ai bot.

Indicizzazione dei contenuti interni

Se è ormai chiaro il motivo per cui è essenziale avere un sito indicizzato, potrebbero essere meno evidenti le ragioni di applicare il medesimo concetto anche a singoli articoli interni.

Sostanzialmente ci si potrebbe chiedere: se il mio sito è già nell’indice di Google, perché dovrei creare una sitemap o fare in modo di inviare immediatamente i nuovi contenuti appena pubblicati?

Le ragioni per forzare questo processo nel minor tempo possibile sono davvero molteplici e vorrei analizzare di seguito le più importanti.

Il crawler è sicuramente efficiente nel suo lavoro, ma è sempre bene aiutarlo, perché potrebbe saltare e non vedere determinati articoli interni, soprattutto in siti con un complesso internal linking. In questi casi, tutti gli sforzi di content marketing per realizzare contenuti utili sarebbero vani, dato che senza una corretta indicizzazione, queste pagine non saranno visibili nelle SERP e non procureranno traffico organico al sito web.

In secondo luogo, se un competitor o semplicemente un malintenzionato attivasse un sistema di monitoraggio sul tuo sito per sapere quando sono pubblicati nuovi contenuti, potrebbe copiarli e pubblicarli nel proprio blog, prima ancora che vengano indicizzati da Google.

In questo caso, il motore di ricerca, in buona fede, potrebbe credere che l’autore originario sia il malintenzionato e che il tuo sito abbia spudoratamente copiato il suo lavoro, comportando problemi di contenuti duplicati e probabilmente persino delle penalizzazioni più o meno evidenti.

Un’altra ragione per preferire una rapida indicizzazione è il mantenimento di una cadenza temporale di pubblicazione per dimostrare serietà e professionalità nel lavoro. Ad esempio, pubblicare un articolo settimanale per diversi anni è molto più apprezzabile rispetto all’inserimento di 10 nuove pagine contemporaneamente ogni 2 mesi.

Come agevolare l’indicizzazione di una pagina su Google

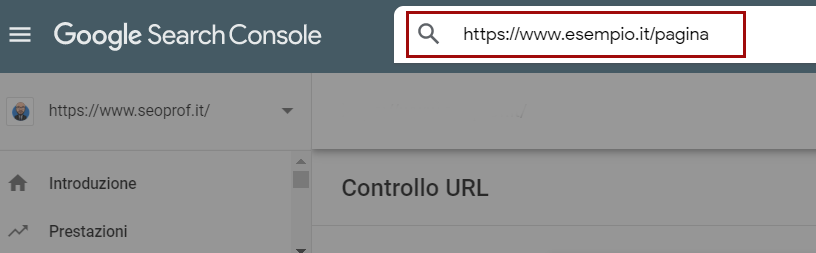

Dal lato pratico, il modo più efficace, rapido e consigliato per indicizzare un singolo nuovo contenuto è l’utilizzo dell’apposita sezione nella Search Console, dato che generalmente il risultato comparirà nella SERP in pochi minuti.

Basta inserire l’URL della pagina e Google si occuperà di visionarla e inserirla nell’indice appena possibile.

Quando invece si ha a che fare con decine o centinaia di contenuti bisogna seguire un approccio più naturale, dato che il lavoro manuale sarebbe troppo dispendioso.

Partiamo dal presupposto che un sito autorevole, aggiornato frequentemente, con dominio anziano e uno storico alle spalle è tendenzialmente ben voluto da Google. Questo significa che verrà analizzato più frequentemente per trovare nuovi contenuti o modifiche a quelli già pubblicati in passato.

Per raggiungere questo obiettivo, possiamo seguire alcuni accorgimenti pratici.

Crea i profili sui social networks

Oltre che per rafforzare il proprio brand (corporate o personal), avere una presenza sui social networks come Twitter, Facebook, Pinterest e LinkedIn è un importante fattore di credibilità.

Pubblicando post relativi ai nuovi articoli del sito, si aumenteranno le probabilità di ottenere backlinks e di essere notati da Googlebot per un’indicizzazione più rapida.

Nonostante la maggior parte di questi backlinks sia di tipo nofollow sono comunque importanti per agevolare l’indicizzazione ed eventualmente procurare un minimo di traffico social.

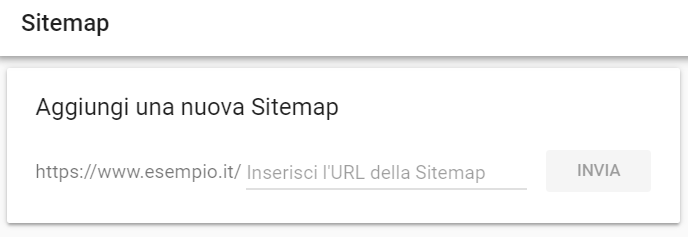

Crea e invia una sitemap

Il file sitemap.xml contiene una lista di URL del sito ed è un valido alleato del crawler di Google per riuscire a scansionare correttamente tutte le sezioni del sito, soprattutto quando si tratta di un e-commerce con migliaia e migliaia di pagine interne.

Per essere utilizzata, non basta avere il file aggiornato costantemente nel sito, ma bisogna anche specificare il percorso esatto nell’apposita sezione all’interno della Search Console.

Link building

Un sito che ottiene backlinks da altri portali autorevoli sicuramente gode di maggiore trust per i motori di ricerca e ogni nuovo contenuto sarà trattato con favore, con una scansione più frequente per trovarne di nuovi.

Fare link building esclusivamente di tipo whitehat, magari con una outreach personale, è sempre un buon metodo per acquisire link juice di rilievo e dare una spinta decisa al proprio posizionamento, giocando secondo le regole e le linee guida di Google.

Internal linking

Soprattutto per i siti particolarmente grandi, avere una struttura di links interni ben organizzata è davvero essenziale, altrimenti la navigazione del bot potrebbe interrompersi in zone cieche del sito, perdendosi alcuni contenuti che sono in realtà molto importanti.

Già in fase di pianificazione andrebbe valutata la corretta architettura dell’intero portale, valutando le aree dedicate ai links e soprattutto quando e come devono essere inseriti per consentire l’accesso dei vari crawler. A livello pratico, tendenzialmente si cerca di avere una struttura del sito dove ogni singola pagina è raggiungibile con al massimo 3 clicks dalla homepage.

Monitora errori di crawl

Nella Search Console esiste un’apposita sezione che riporta eventuali errori riscontrati nel sito durante il passaggio di Googlebot, che sebbene non sia un fattore SEO diretto, gioca comunque un ruolo importante in una visione ad ampio raggio.

In presenza di HTTP status codes 404 o 503 è bene intervenire immediatamente perché il crawler potrebbe non raggiungere pagine importanti o semplicemente sprecare tempo e risorse su zone malfunzionanti del sito, a discapito di quelle davvero utili.

In questi casi, si può valutare sia un potenziamento del server che una correzione di eventuali links rotti.

Per concludere, esistono varie pratiche per agevolare il passaggio di Googlebot sul nostro sito e facilitare l’indicizzazione in modo che i nostri nuovi contenuti siano sempre visibili nel minor tempo possibile nelle SERP, con i notevoli vantaggi esposti nell’articolo.

E tu come ti comporti se una nuova pagina del tuo sito non viene indicizzata dai motori di ricerca?

Raccontamelo nei commenti.