Cos'è il Crawl Budget?

Il crawl budget è la quantità di tempo e risorse che i bot dei motori di ricerca destinano al crawling del tuo sito web e all'indicizzazione delle sue pagine.

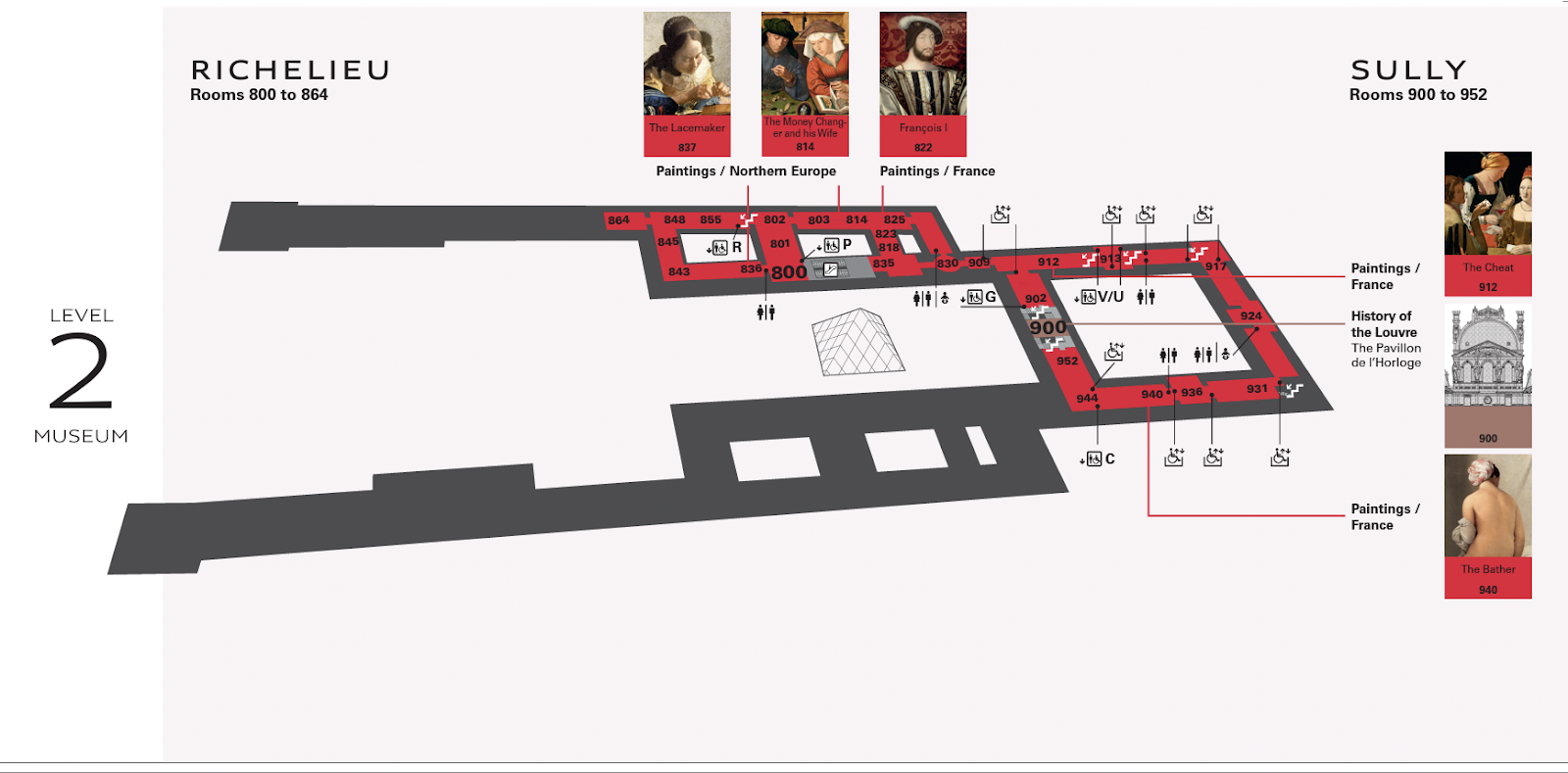

Pensate a questo: visitate il Louvre, che ha centinaia di mostre distribuite su diversi piani.

Senza una mappa, potresti perdere l'arte che vuoi vedere.

Per realizzare la mappa che hai tra le mani, qualcuno avrebbe dovuto attraversare ogni stanza, segnando quali dipinti vi erano elencati.

In questa metafora, il cartografo del Louvre è come un Googlebot che striscia un sito web.

Un team di cartografi che gira costantemente per il Louvre rallenterebbe l'esperienza degli spettatori.

In modo simile al modo in cui i bot che strisciano costantemente il tuo sito web lo rallentano.

Quindi i cartografi hanno bisogno di un tempo prestabilito per aggiornare la mappa, proprio come il Googlebot ha bisogno di sapere ogni quanto tempo deve effettuare il crawling del tuo sito web.

I budget dei crawl influiscono sulla SEO?

Il crawl budget non è un fattore di ranking per la SEO tecnica.

Ma se Googlebot incontra errori di crawl che gli impediscono di leggere e indicizzare i tuoi contenuti, le possibilità che le tue pagine compaiano nelle pagine dei risultati dei motori di ricerca(SERP) sono scarse.

Non vuoi nemmeno che i bot di Google striscino il tuo sito in continuazione.

Il superamento del budget assegnato per il crawling di un sito web può causare rallentamenti o errori nel sistema.

Questo può far sì che le pagine vengano indicizzate in ritardo o non vengano indicizzate affatto, con conseguente abbassamento delle classifiche di ricerca.

Google utilizza centinaia di segnali per decidere dove posizionare la tua pagina. Il crawling determina se la tua pagina viene visualizzata, non dove, e non ha nulla a che fare con la qualità dei contenuti.

Come fa Google a determinare il Crawl Budget?

Ogni sito web ha un budget di crawl unico, controllato da due elementi principali: la domanda di crawl e il limite di crawl.

È importante capire come funzionano e cosa succede dietro le quinte.

Domanda di strisciamento

La richiesta di crawl si riferisce al desiderio di Google di effettuare il crawling del tuo sito web.

Due fattori incidono su questa domanda: la popolarità e la staticità.

Popolarità

Google dà la priorità alle pagine con più backlink o a quelle che attirano un traffico maggiore. Quindi, se le persone visitano il tuo sito web o lo linkano, l'algoritmo di Google riceve segnali che indicano che il tuo sito web merita crawling più frequenti.

In particolare, i backlink aiutano Google a capire quali sono le pagine che meritano di essere crawlate. Se Google si accorge che le persone parlano del tuo sito web, vuole effettuare un crawling più approfondito per capire di cosa si tratta.

Il numero di backlink da solo non conta: i backlink devono essere rilevanti e provenire da fonti autorevoli.

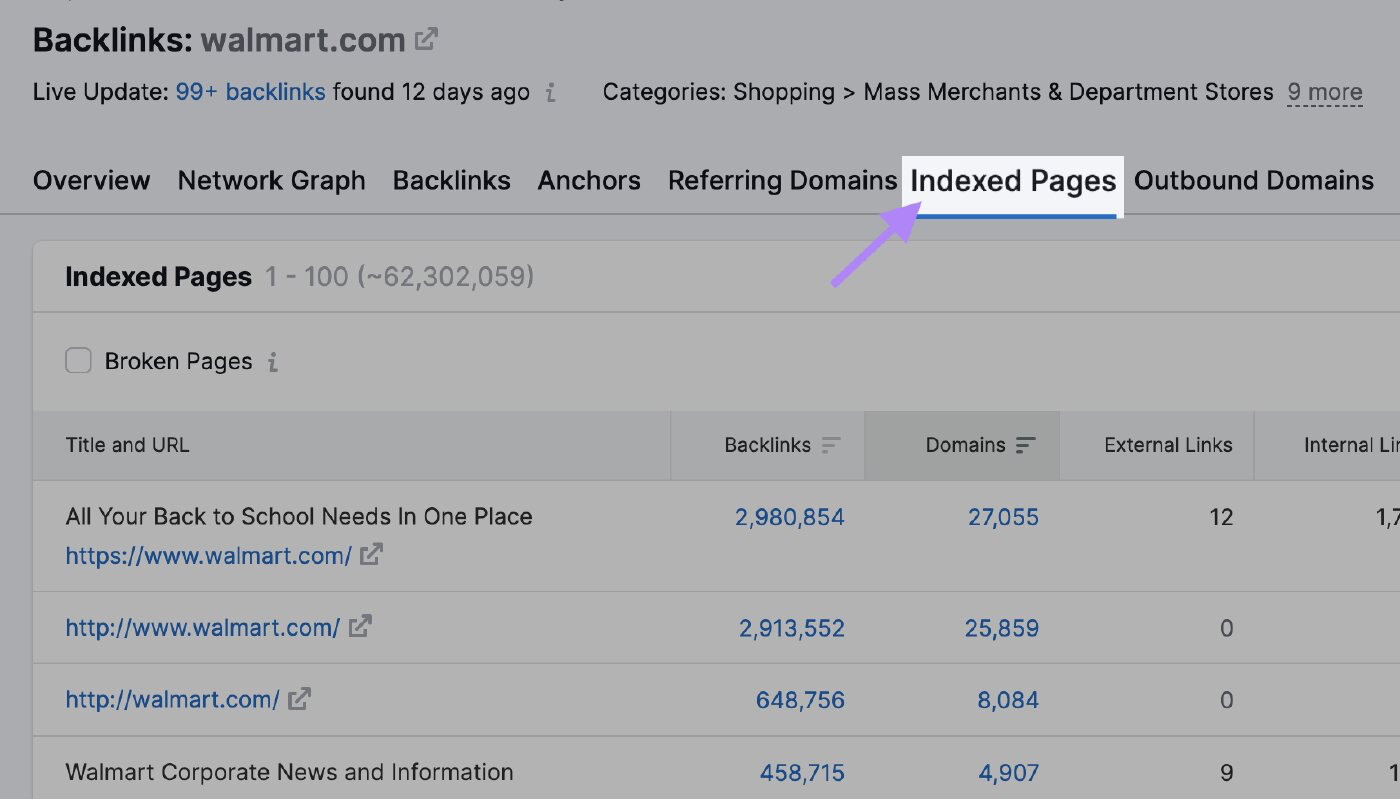

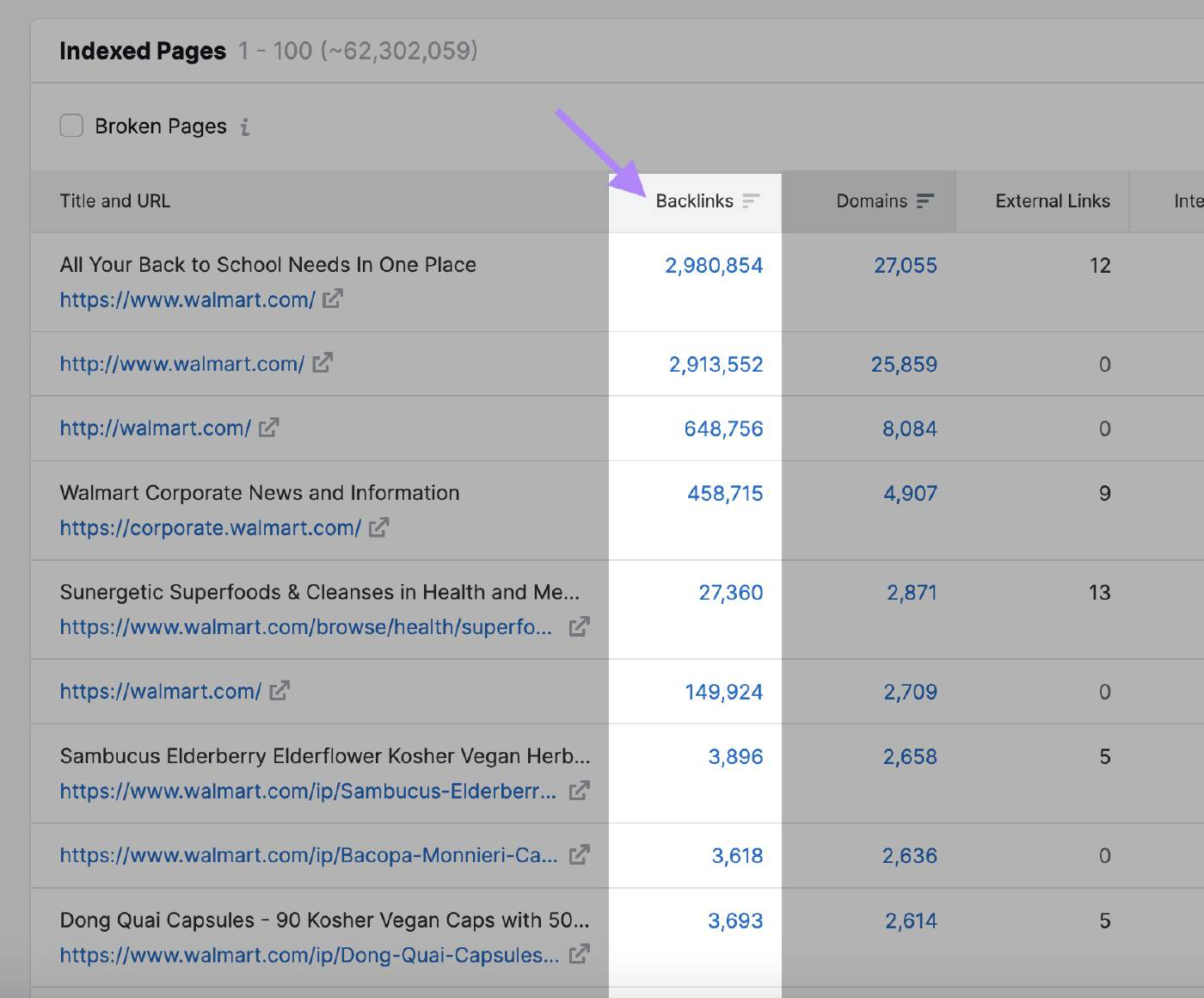

Puoi utilizzare lo strumento Backlink Analytics di Semrush per vedere quali sono le pagine che attirano più backlink e che possono attirare l'attenzione di Google. Inserisci il dominio e clicca sulla scheda "Pagine indicizzate".

Qui puoi vedere le pagine con il maggior numero di backlink:

Staticità

Googlebot non effettuerà il crawling di una pagina che non è stata aggiornata da tempo.

Google non ha rivelato la frequenza con cui il motore di ricerca effettuerà una nuova scansione del sito web. Tuttavia, se l'algoritmo nota un aggiornamento generale del sito, i bot aumentano temporaneamente il crawl budget.

Ad esempio, Googlebot effettua una scansione frequente dei siti web di notizie perché pubblicano nuovi contenuti più volte al giorno.

In questo caso, il sito web ha un'elevata richiesta di crawling.

Paragonalo a un sito web sulla storia di opere d'arte famose che non viene aggiornato con la stessa frequenza.

Altre azioni che possono segnalare a Google la presenza di modifiche da effettuare sono:

- Cambio del nome di dominio: Quando cambi il nome di dominio del tuo sito web, l'algoritmo di Google deve aggiornare il suo indice per riflettere il nuovo URL. Eseguirà il crawling del sito web per capire il cambiamento e passerà i segnali di ranking al nuovo dominio.

- Modifica della struttura dell'URL: Se modifichi la struttura degli URL del tuo sito web cambiando la gerarchia delle directory o rimuovendo o aggiungendo sottodomini, i bot di Google devono eseguire nuovamente il recrawling delle pagine per indicizzare correttamente i nuovi URL.

- Aggiornamenti dei contenuti: Aggiornamenti significativi dei contenuti del tuo sito web, come la riscrittura di gran parte delle pagine, l'aggiunta di nuove pagine o la rimozione di contenuti obsoleti, possono attirare l'attenzione dell'algoritmo e indurlo a effettuare un recrawling del tuo sito web.

- Invio della sitemap XML: Aggiornare la tua sitemap XML e ripresentarla a Google Search Console può informare Google che ci sono delle modifiche da scansionare. Questo è particolarmente utile quando vuoi assicurarti che Google indicizzi tempestivamente le pagine nuove o aggiornate.

Limite della velocità di strisciamento

Il limite della velocità di crawl determina la velocità con cui il bot può accedere e scaricare le pagine web dal tuo sito per preparare i contenuti da inserire nei risultati di ricerca.

Questo è il modo in cui Google si assicura che il suo crawl non sovraccarichi i tuoi server.

Il limite di crawl impedisce al bot di intasare il tuo sito web con troppe richieste, il che può causare problemi di prestazioni.

Se il tuo sito risponde rapidamente, Google ottiene il via libera per aumentare il limite e può quindi utilizzare più risorse per effettuare il crawling.

Allo stesso modo, se Google riscontra errori del server o il tuo sito rallenta, il limite si abbasserà e Googlebot effettuerà meno crawling del sito.

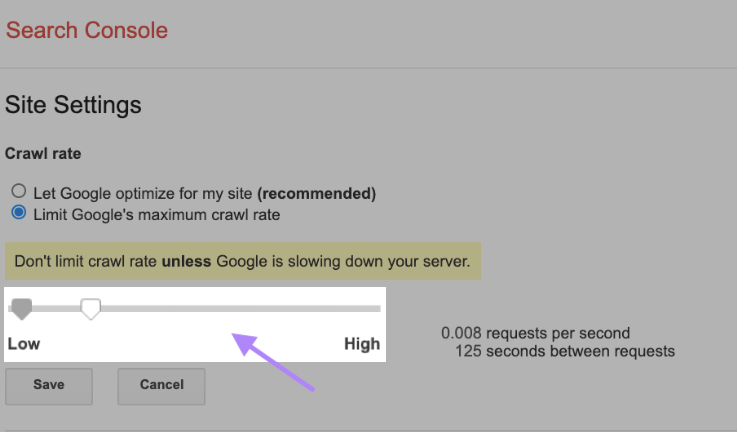

Puoi anche modificare il limite di crawl manualmente, anche se è importante farlo con cautela. Google suggerisce di non limitare la velocità di crawl a meno che il tuo server non stia rallentando.

Per modificare il tasso di crawl, vai in Impostazioni del sito su Search Console e regola la barra. L'applicazione dell'adeguamento richiede in genere fino a due giorni.

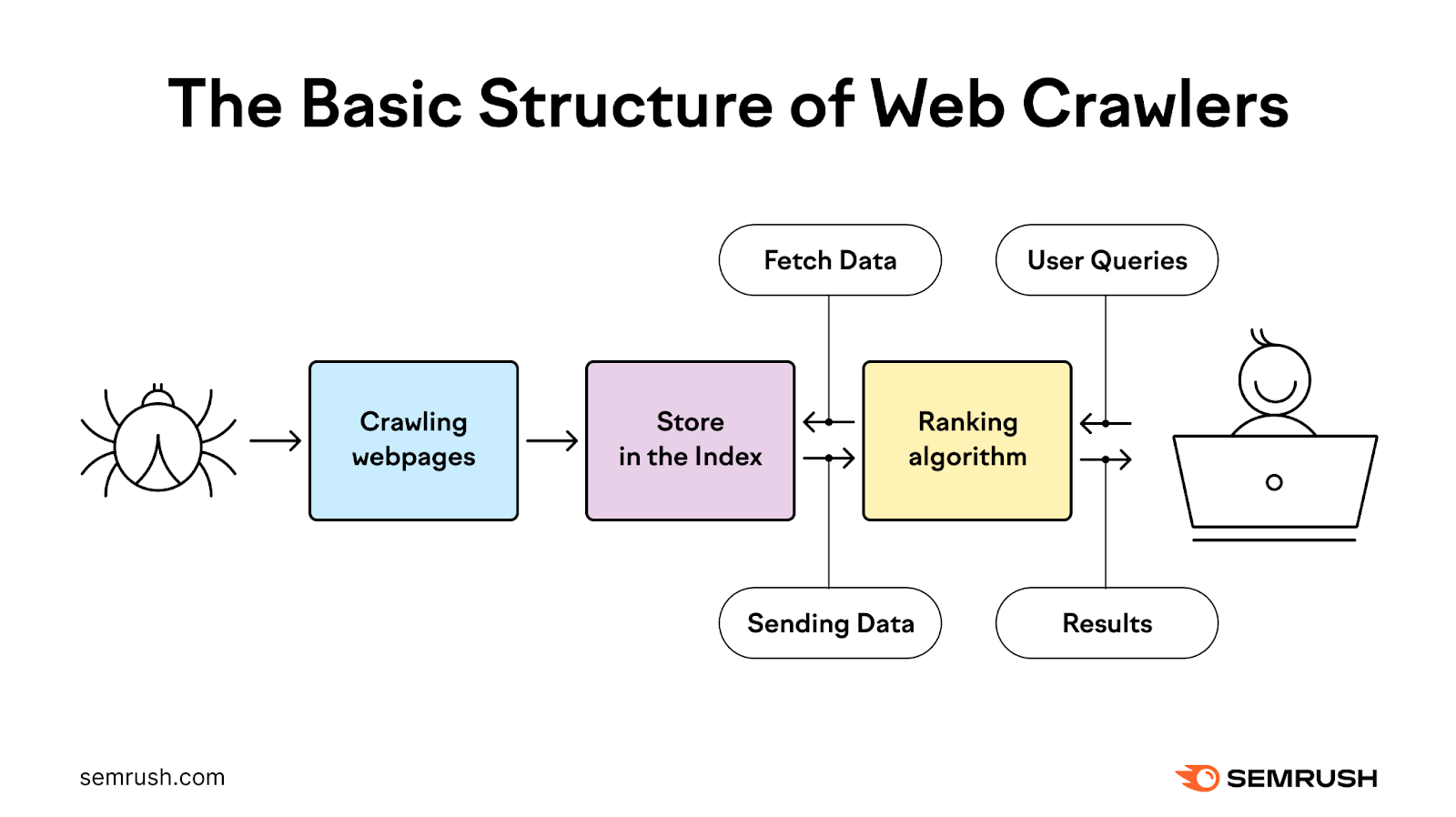

Come funziona il processo di crawling?

Il processo di crawling utilizza i bot per scoprire, strisciare, analizzare e indicizzare le pagine web per fornire agli utenti i risultati di ricerca più pertinenti e di qualità.

Inizia con un elenco di indirizzi web ricavati da crawl precedenti e da sitemap XML fornite dai proprietari dei siti. Poi Google utilizza dei web crawler per visitare questi indirizzi, leggere le informazioni e seguire i link presenti in queste pagine.

I crawler rivisitano le pagine che Google ha già inserito nell'elenco per verificare se sono cambiate e per scansionare le nuove pagine.

Durante questo processo, il bot stabilisce la priorità di quando e cosa effettuare il crawling in base alla richiesta di crawling, assicurandosi che il sito web sia in grado di gestire le richieste del server.

Quindi elabora e trasmette a Google le pagine che ha scansionato con successo per indicizzarle nei risultati di ricerca.

Nella maggior parte dei casi, Google effettua il crawling dei siti web più piccoli in modo efficiente.

Quando si tratta di siti web di grandi dimensioni con milioni di URL, Google deve stabilire le priorità su quando e cosa effettuare il crawling e quante risorse dedicare.

Come controllare l'attività di Crawl

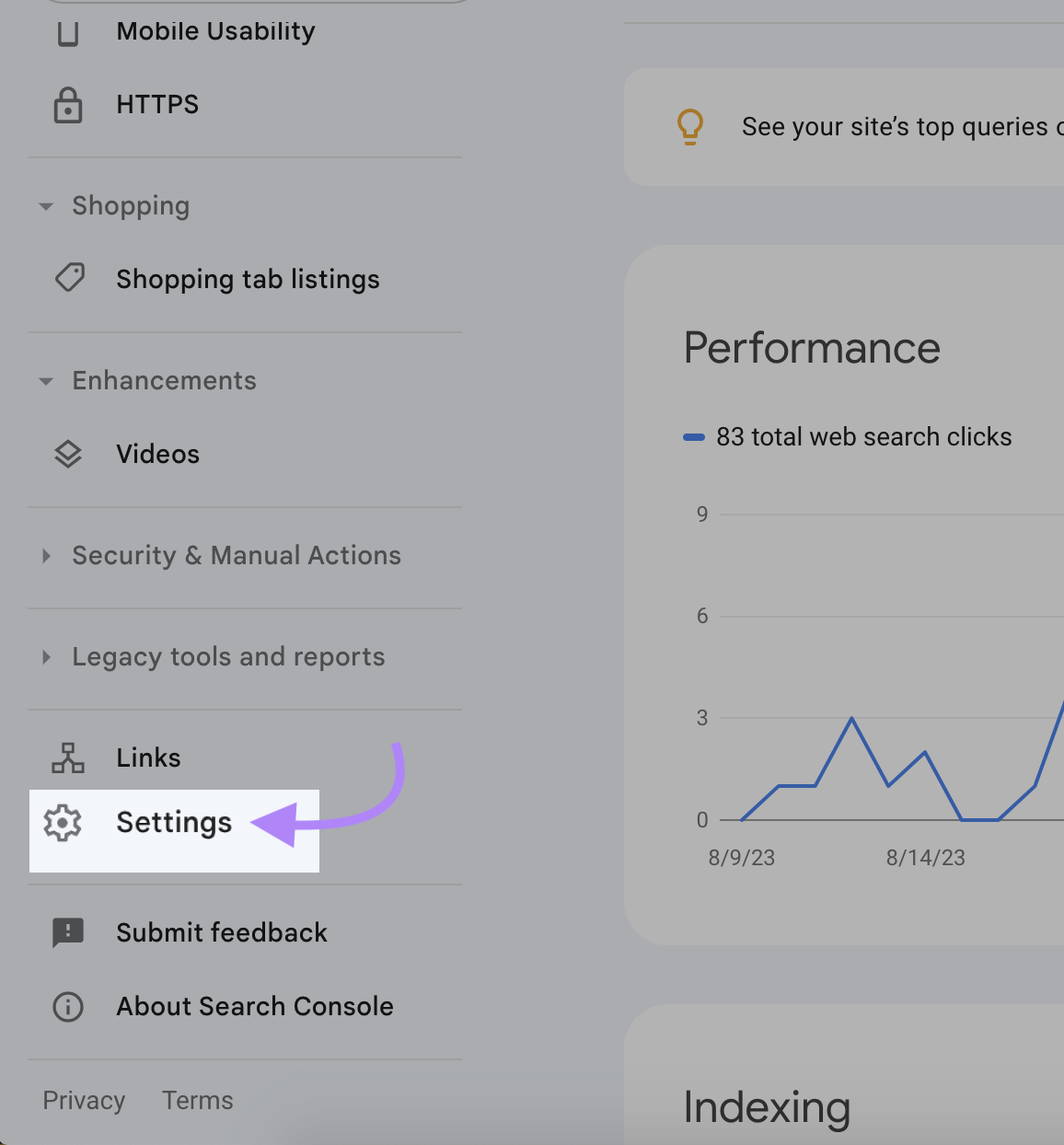

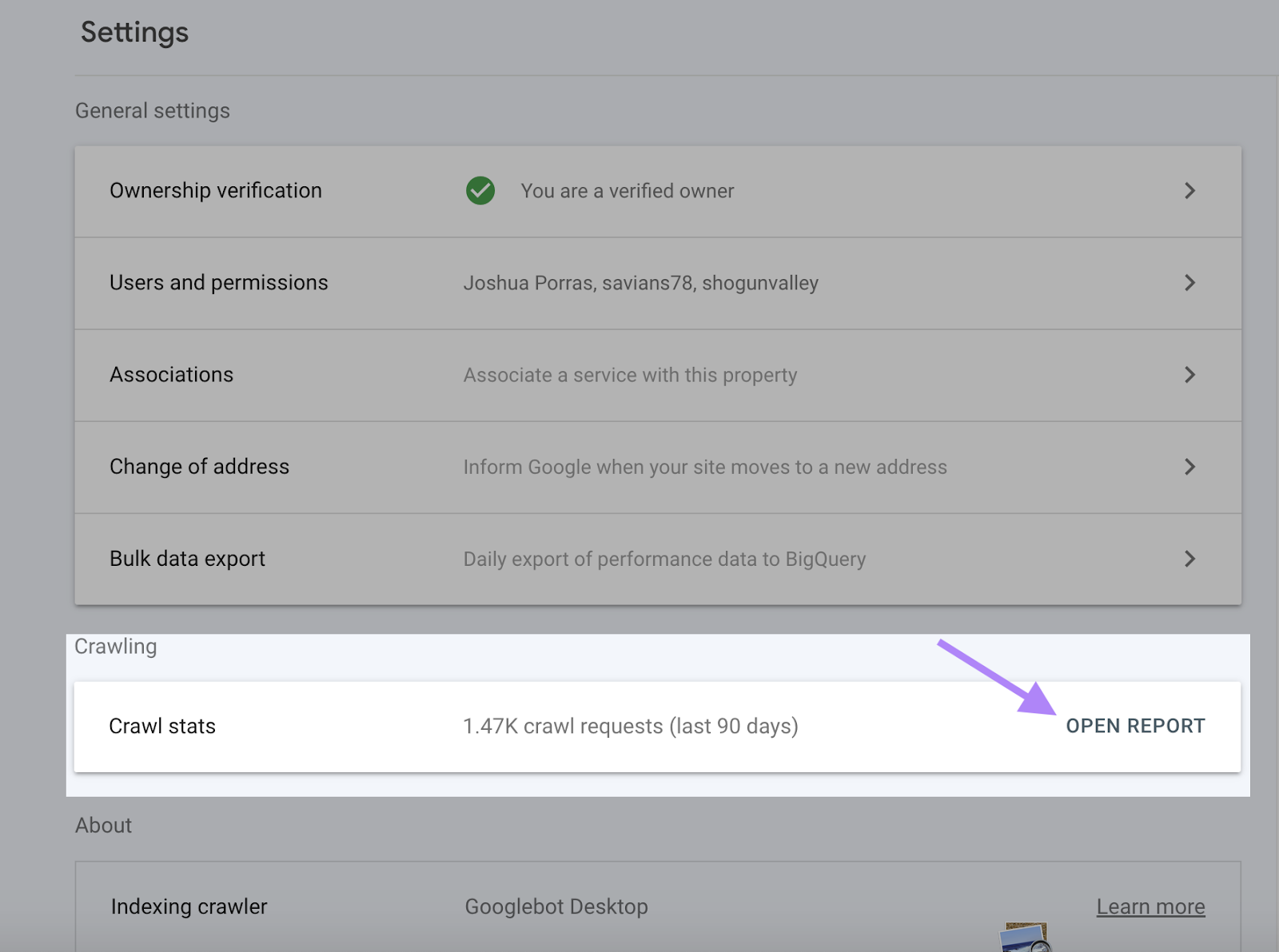

Google Search Console fornisce informazioni complete sull'attività di crawl, compresi gli errori di crawl e il tasso di crawl, nel rapporto Crawl Stats.

Il rapporto Crawl Stats ti aiuta a verificare se Google può accedere ai tuoi contenuti e indicizzarli. Può anche identificare e risolvere eventuali problemi prima che la visibilità del tuo sito web diminuisca.

Per accedere al rapporto Crawl Stats, accedi a Search Console e clicca su "Impostazioni".

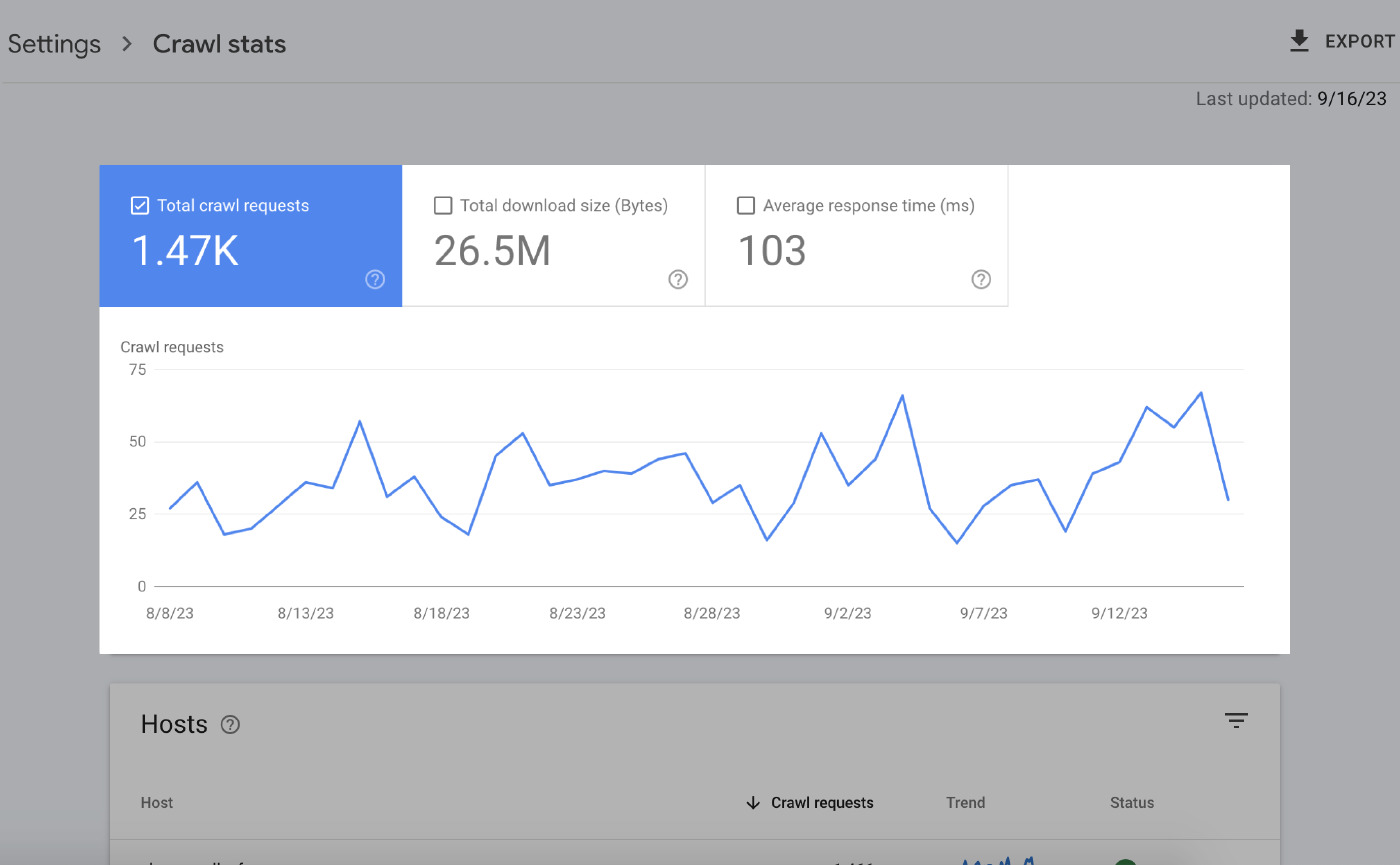

La pagina di riepilogo ti fornisce molte informazioni. Gli elementi principali sono:

Grafici over time

I grafici over-time evidenziano i dati di crawl degli ultimi 90 giorni.

Ecco cosa significa tutto questo:

- Totale richieste di crawl: Il numero di richieste di crawl effettuate da Google negli ultimi 90 giorni.

- Dimensione totale del download: La quantità totale di dati che i crawler di Google hanno scaricato accedendo al tuo sito web in un periodo specifico.

- Tempo medio di risposta: Il tempo necessario al server del tuo sito web per rispondere a una richiesta del browser di un utente.

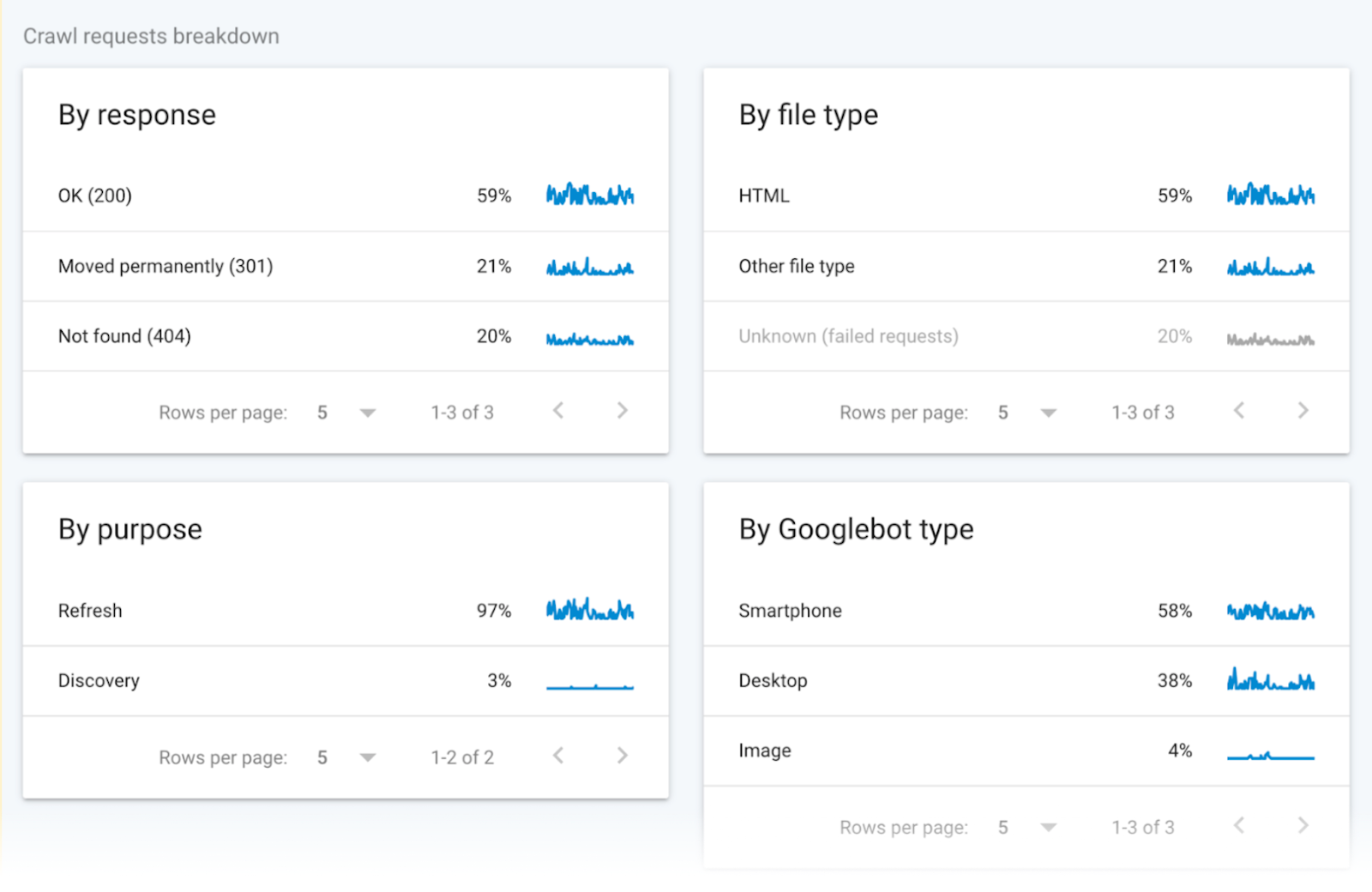

Dati Crawl raggruppati

I dati di crawl raggruppati forniscono informazioni sulle richieste di crawl.

I dati dividono queste richieste in base al tipo di file URL, alla risposta, al tipo di Googlebot e allo scopo della richiesta (scoperta di una nuova pagina o aggiornamento di una pagina esistente).

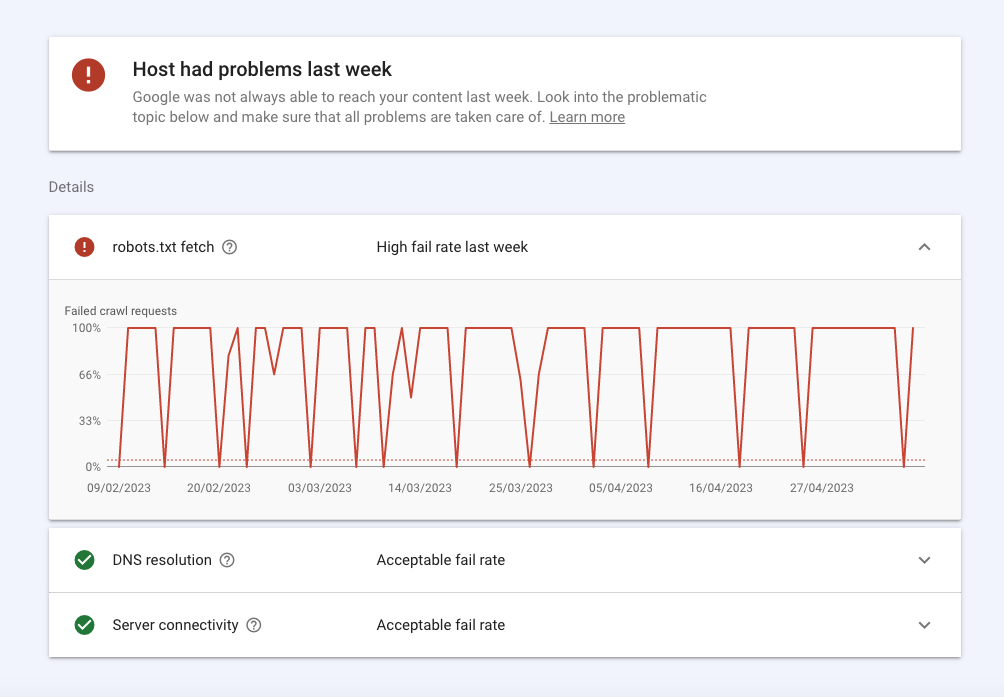

Stato dell'host

Lo stato dell'host mostra la disponibilità generale del tuo sito e se Google può accedervi senza problemi.

Ecco una panoramica:

- Gli errori nella sezione robots.txt significano che Google non ha potuto effettuare il crawling del tuo sito per qualsiasi motivo tecnico. Robots.txt fetch indica la percentuale di insuccesso che i bot hanno riscontrato quando hanno effettuato il crawling del tuo file robots.txt. Anche se il tuo sito non ha bisogno di un file robots.txt, deve restituire la risposta 200 o 404 quando viene richiesta. Se Googlebot ha un problema di connessione, come ad esempio uno stato HTTP 503, interromperà il crawling del tuo sito.

- La risoluzione DNS ti dice quando il server DNS non ha riconosciuto il tuo hostname o non ha risposto durante il crawling. Se riscontri un problema, contatta il tuo registrar per verificare che il tuo sito sia impostato correttamente e che il tuo server abbia una connessione internet attiva.

- La connettività del server ti dice quando il tuo server non ha risposto o non ha fornito una risposta completa. Se riscontri dei picchi o dei problemi di connettività costanti, potresti dover parlare con il tuo provider per aumentare la capacità o risolvere i problemi di disponibilità.

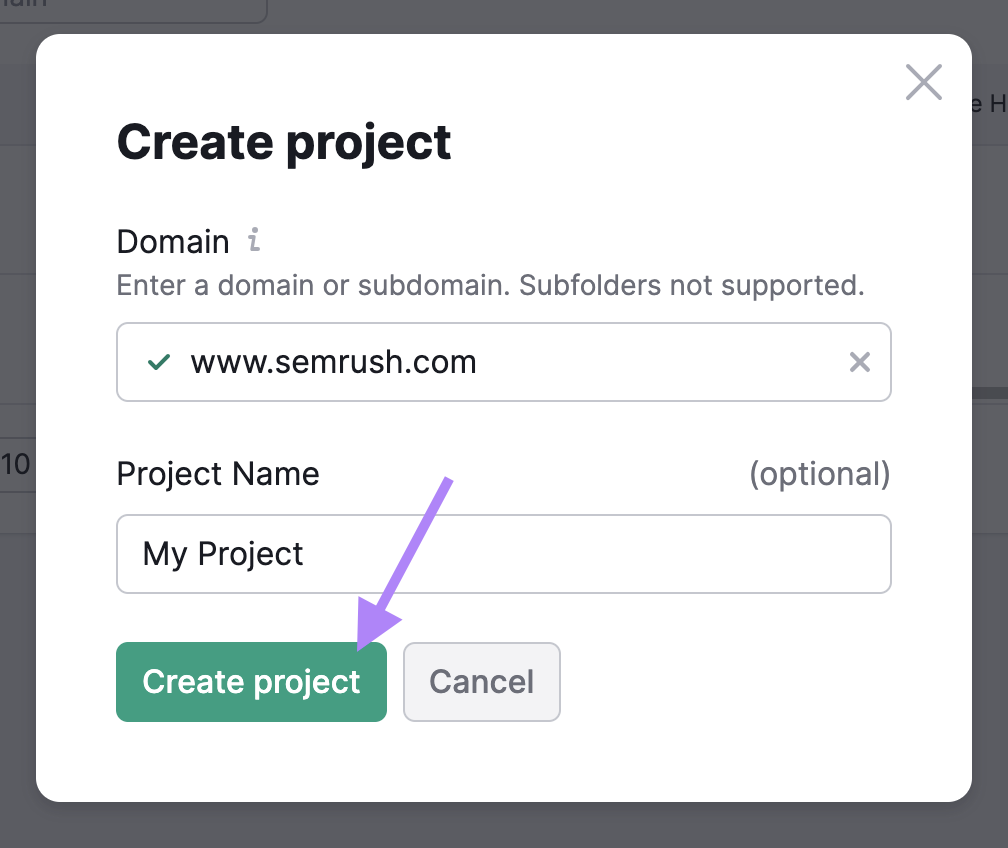

Come verificare la crawlabilità del tuo sito web con Site Audit

Utilizza lo strumento Site Audit per far sì che SemrushBots effettui il crawling del tuo sito web e ne verifichi lo stato di salute.

Lo strumento segnala oltre 140 problemi, tra cui contenuti duplicati e link non funzionanti, che puoi identificare e risolvere.

Ecco cosa devi fare:

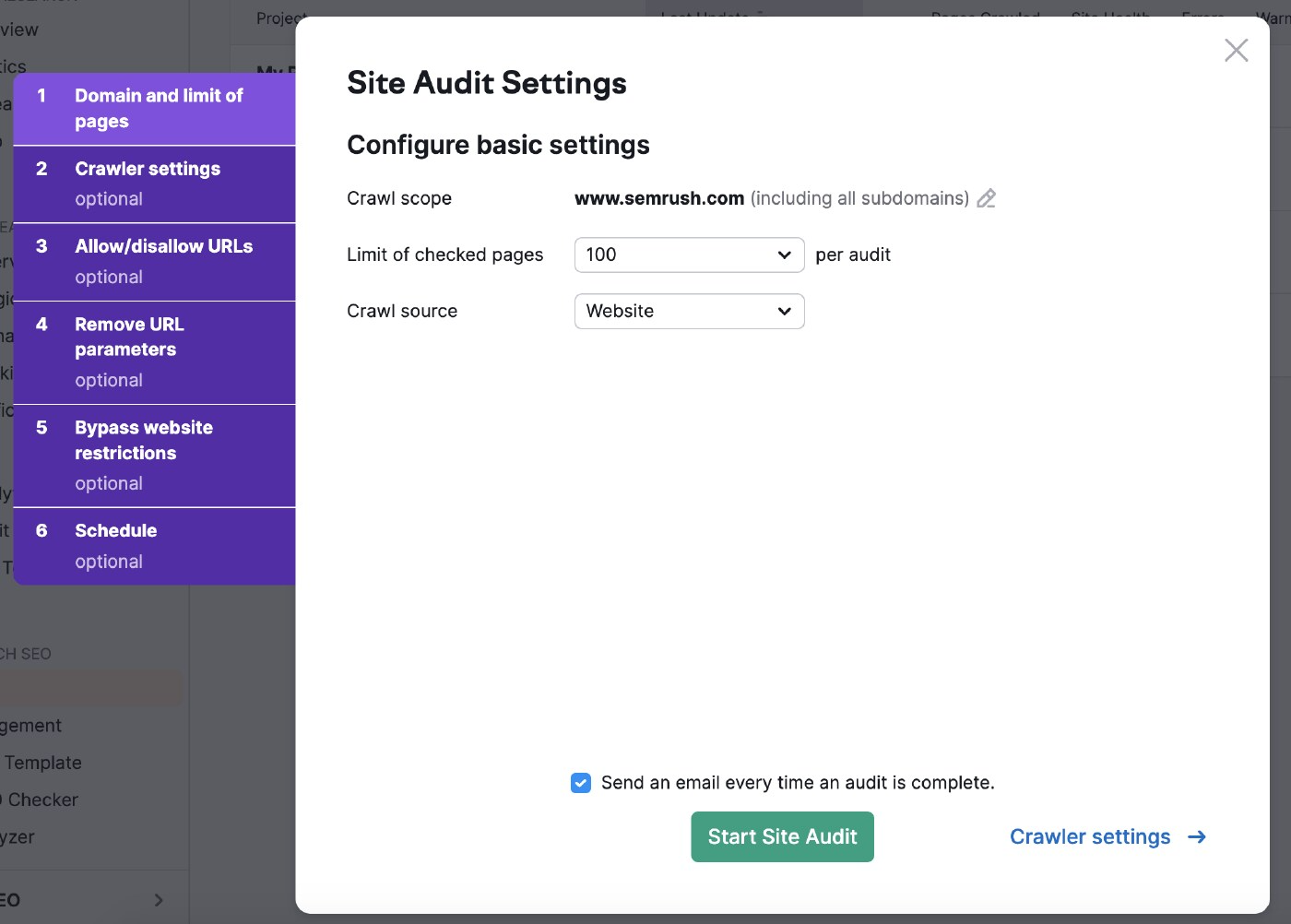

Finalizzare le impostazioni di base

Vai allo strumento Site Audit e crea un nuovo progetto se si tratta del tuo primo audit.

Quindi seleziona le impostazioni di verifica del sito.

La portata del crawl ti permette di restringere la ricerca.

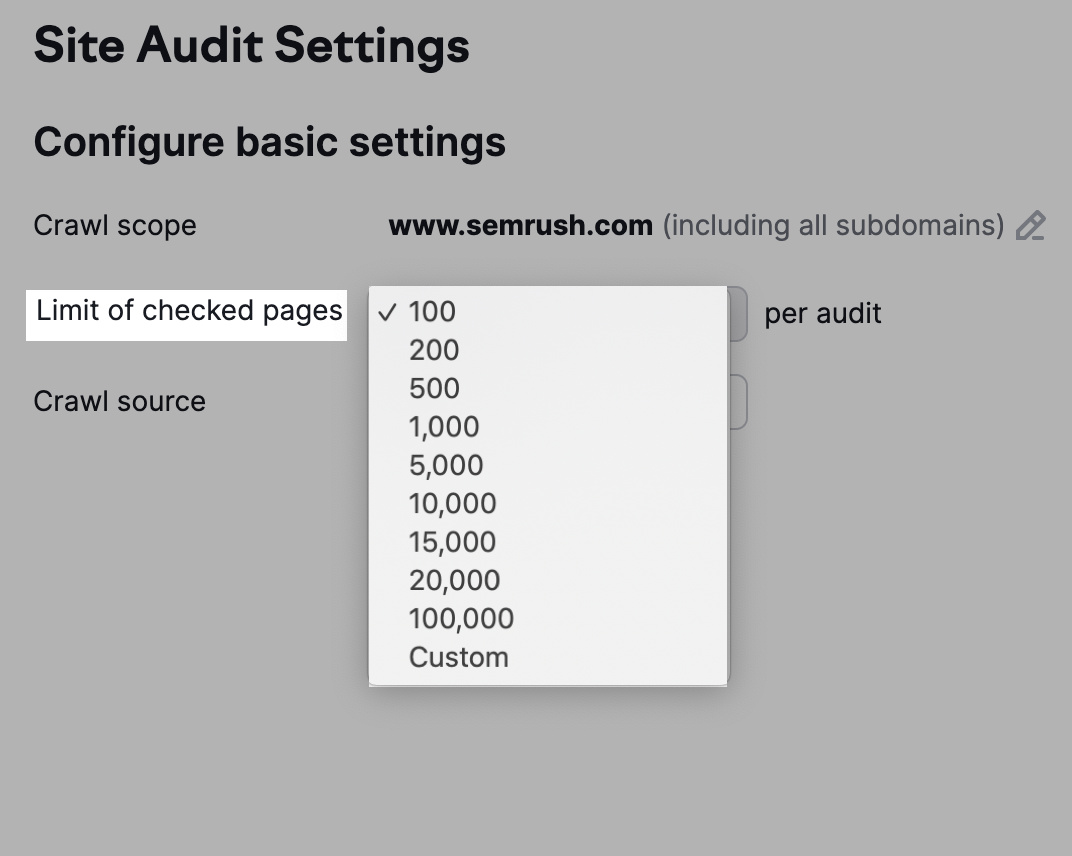

Puoi anche regolare il numero di URL da controllare per ogni audit in base al tuo livello di abbonamento e alla frequenza con cui ispezionerai il sito web.

Più pagine vengono crawlate, maggiore sarà la visibilità che otterrai.

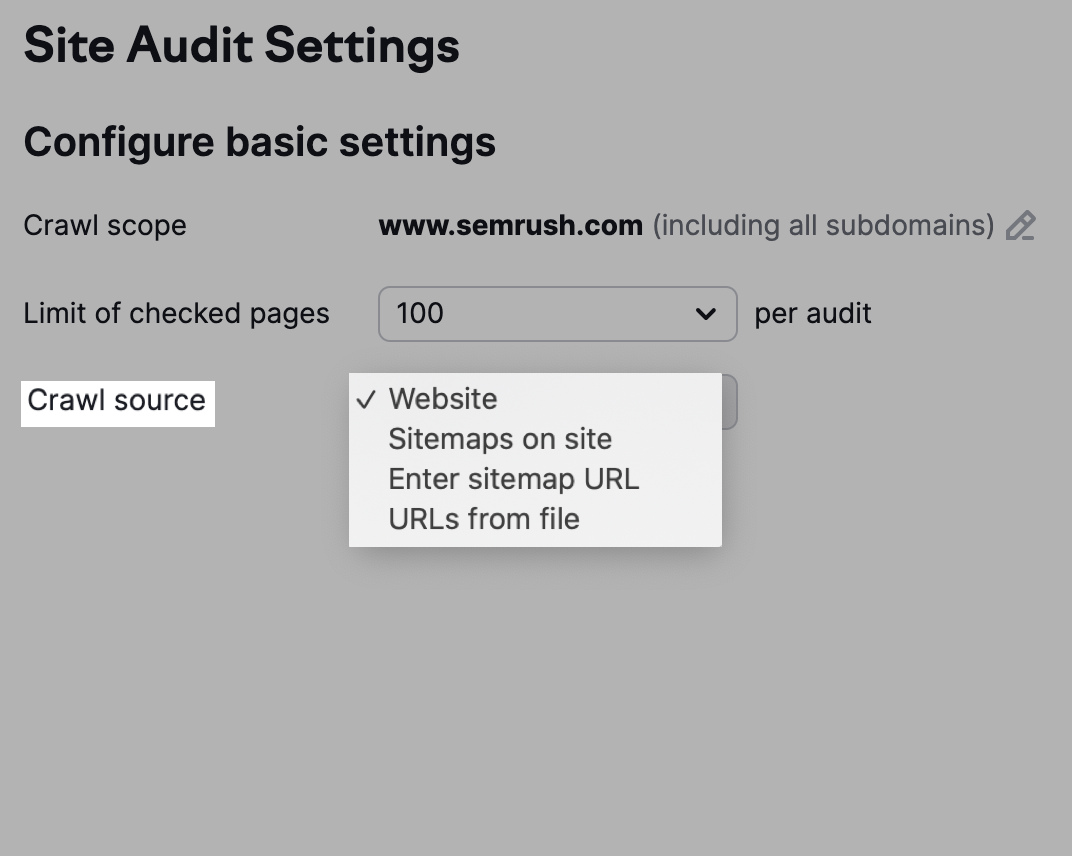

Hai anche la possibilità di scegliere la fonte di crawl.

Nota che l'opzione "Sito web" farà in modo che i bot effettuino il crawling del tuo sito come fa Google, mentre un crawl che utilizza "Sitemaps on site" utilizza gli URL nella sitemap del file robots.txt.

In alternativa, fai clic su "URL da file" per selezionare le pagine che desideri che i bot effettuino il crawling.

Regola le impostazioni di Crawler

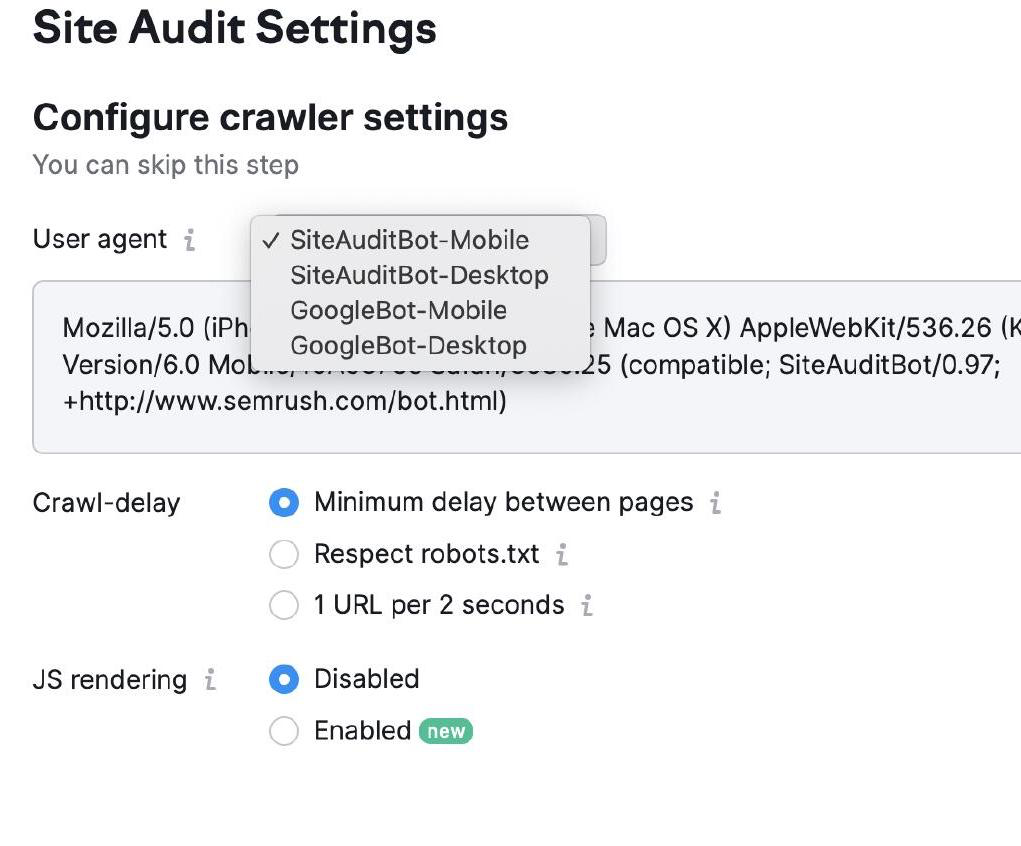

Le impostazioni del crawler ti permettono di scegliere il tipo di bot che effettua il crawling del tuo sito web.

Puoi scegliere tra Googlebot e SemrushBot e tra le versioni mobile e desktop.

Poi seleziona le impostazioni del ritardo di strisciamento. I bot effettuano il crawling a una velocità normale con "ritardo minimo" e danno priorità all'esperienza dell'utente nelle impostazioni "1 URL ogni 2 secondi".

Infine, seleziona "Rispetta robots.txt" se disponi del file in questione e hai bisogno di un ritardo specifico per il crawling.

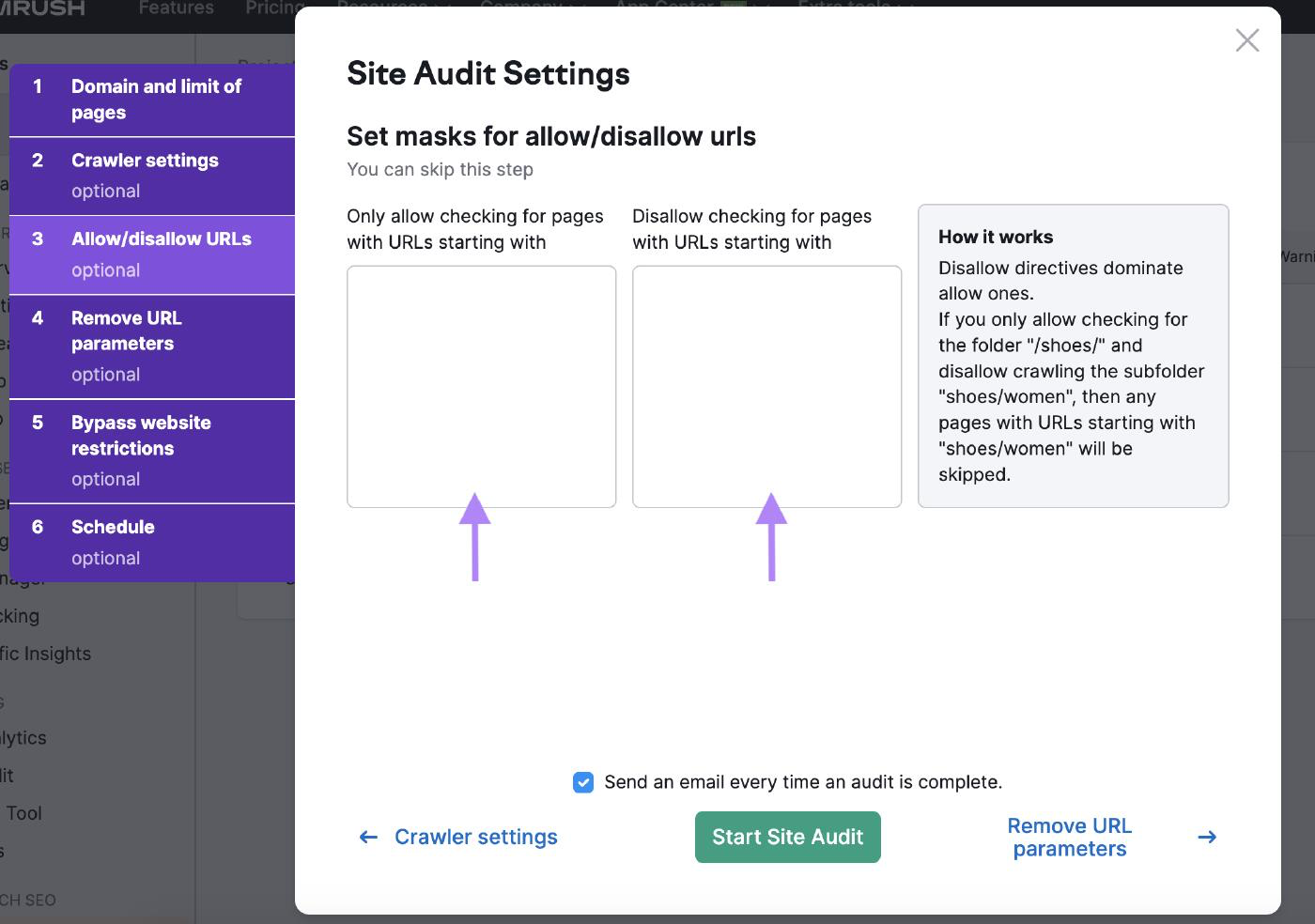

Consenti/rifiuta gli URL

Personalizza l'audit del tuo sito con le impostazioni degli URL consentiti/rifiutati inserendo gli URL nelle caselle corrispondenti.

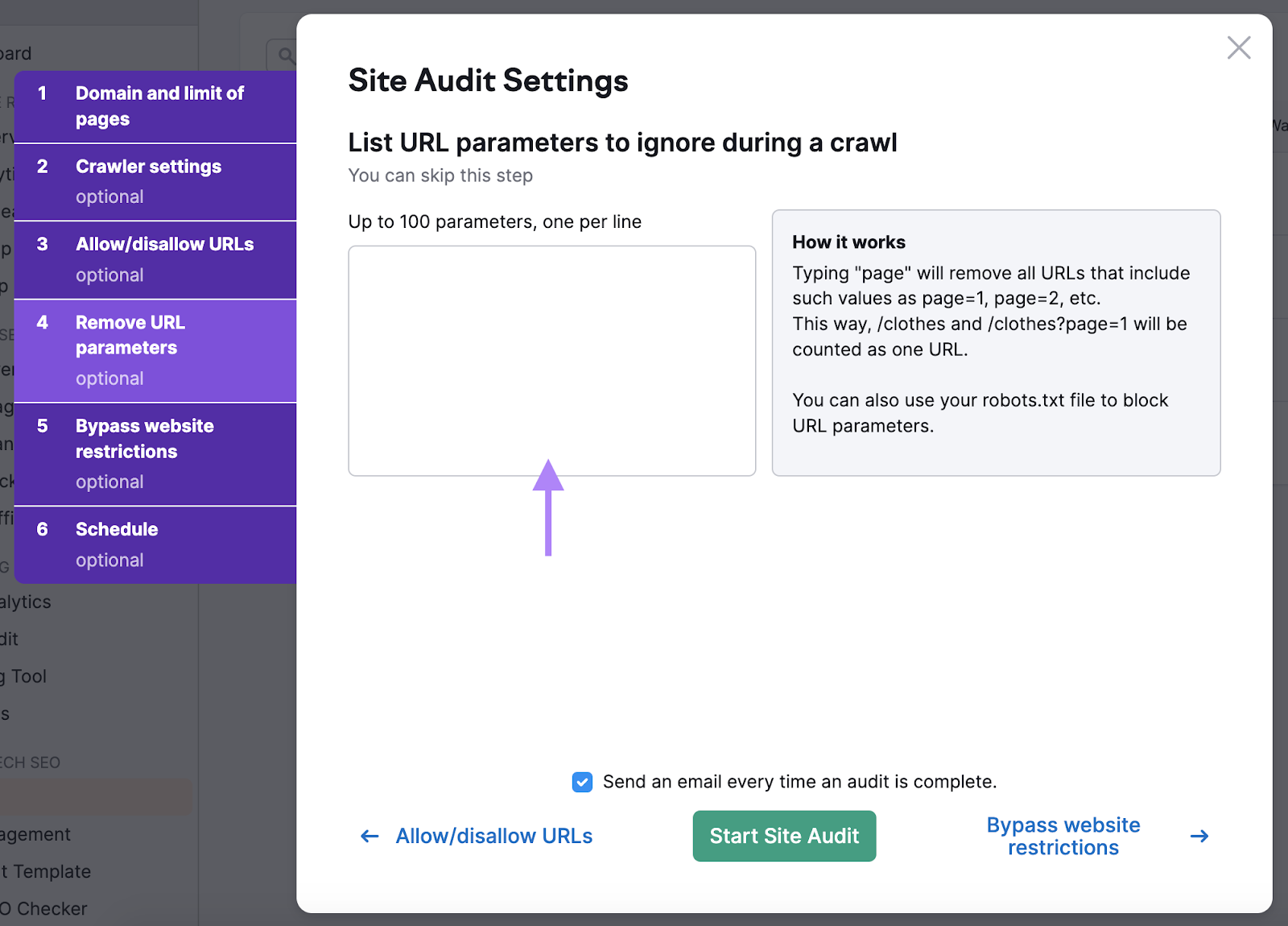

Rimuovi i parametri dell'URL

Rimozione di parametri URL assicura che i bot non sprechino il budget per il crawling effettuando due volte il crawling della stessa pagina.

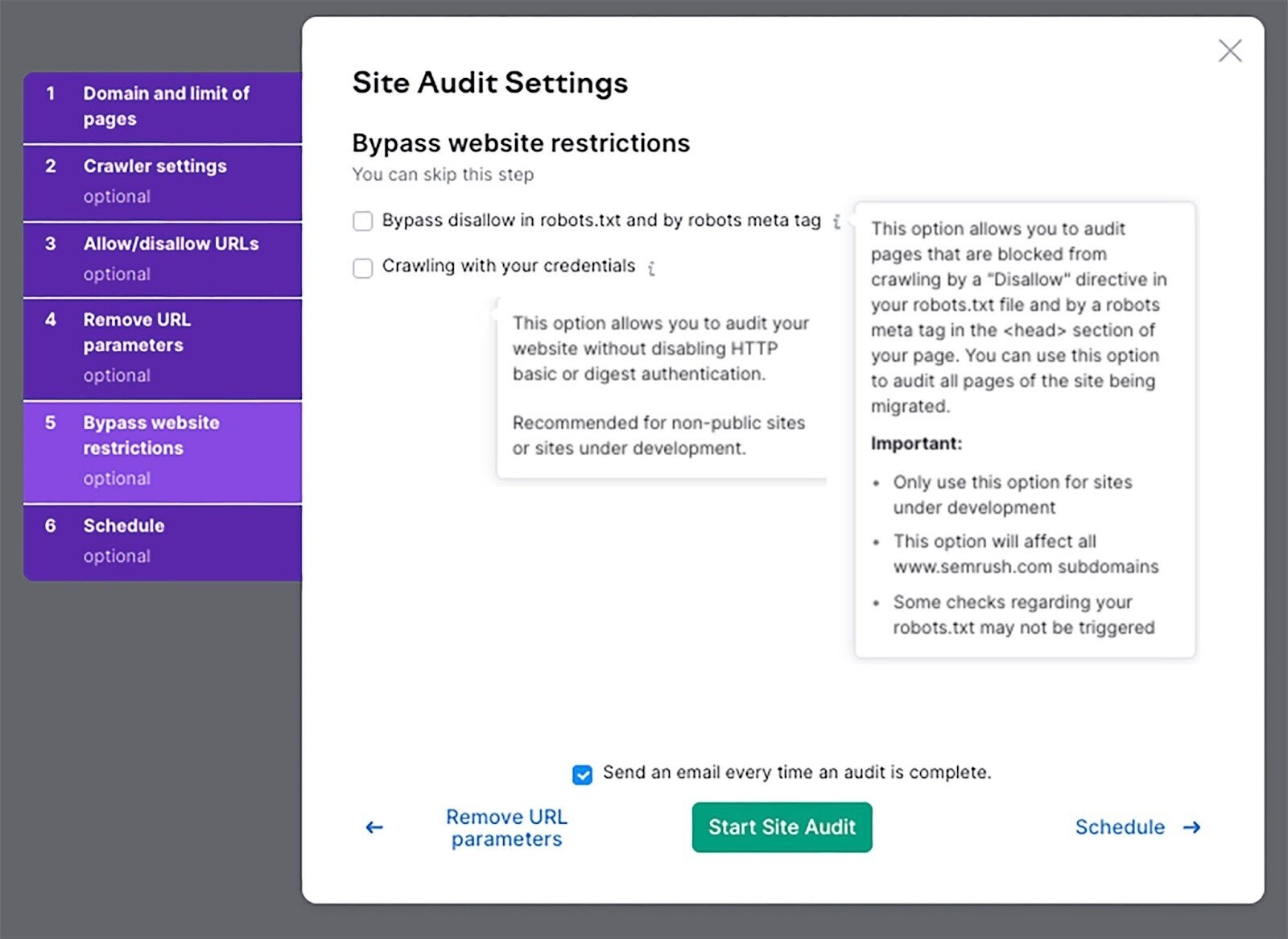

Bypassare le restrizioni del sito web

Se il tuo sito web è ancora in fase di sviluppo, usa questa impostazione per eseguire una verifica.

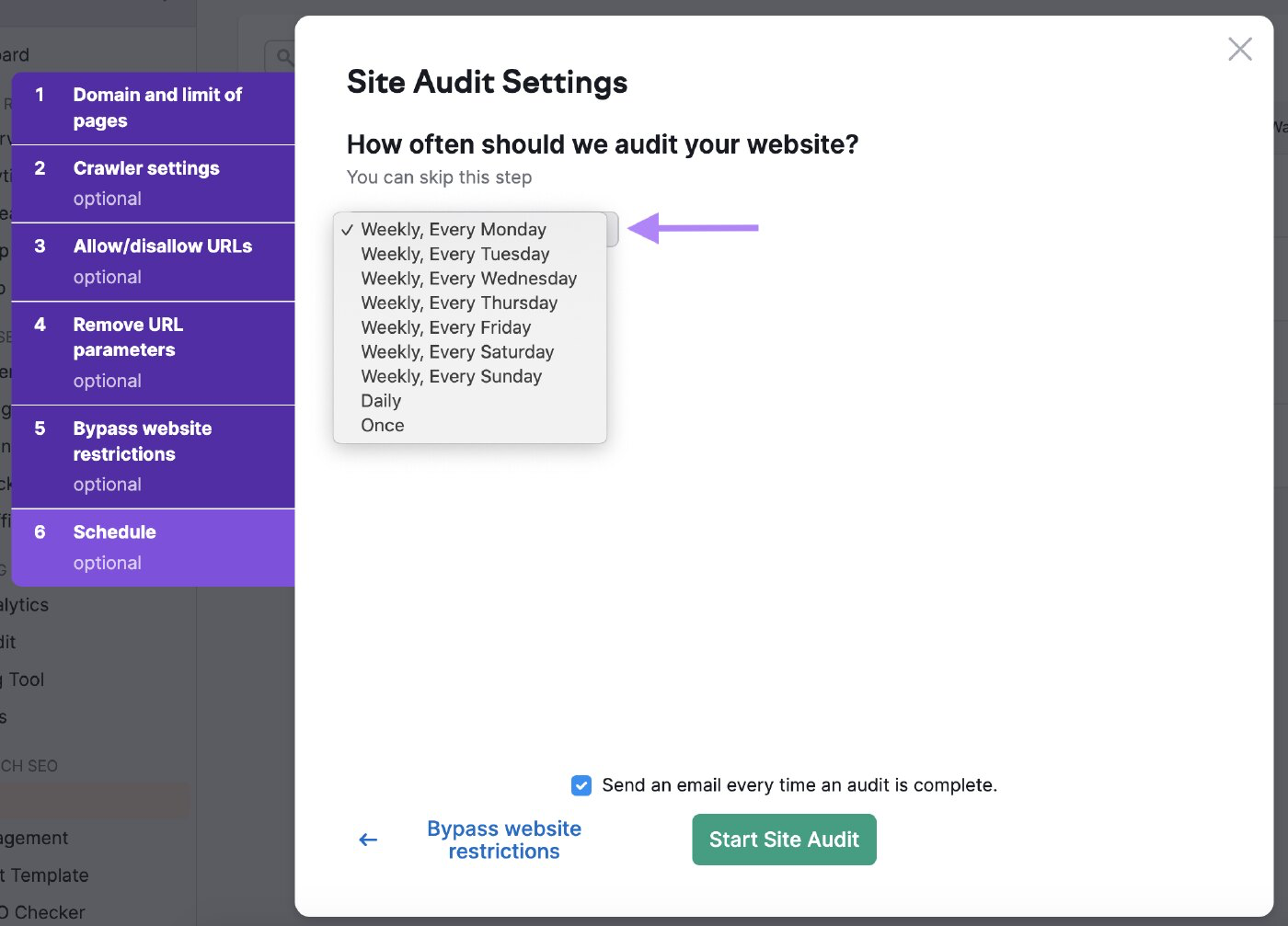

Pianifica i tuoi audit

Puoi programmare la frequenza con cui vuoi che il bot controlli il tuo sito web.

Programmalo frequentemente per assicurarti che lo strumento controlli regolarmente lo stato di salute del tuo sito web.

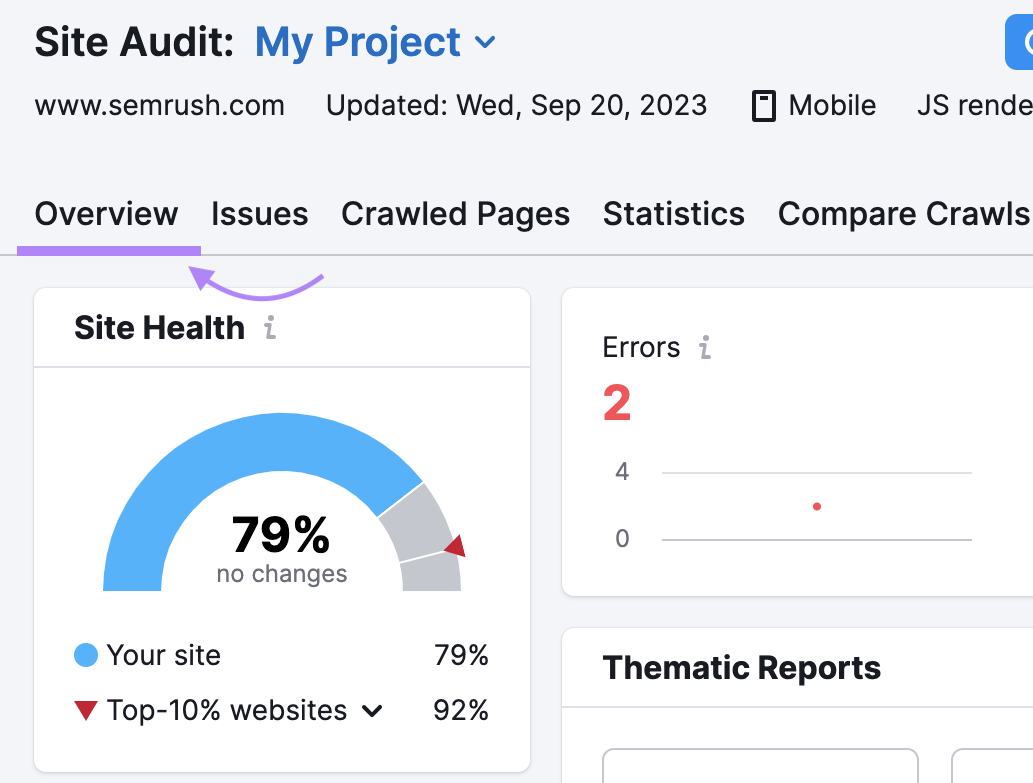

Analizza i risultati

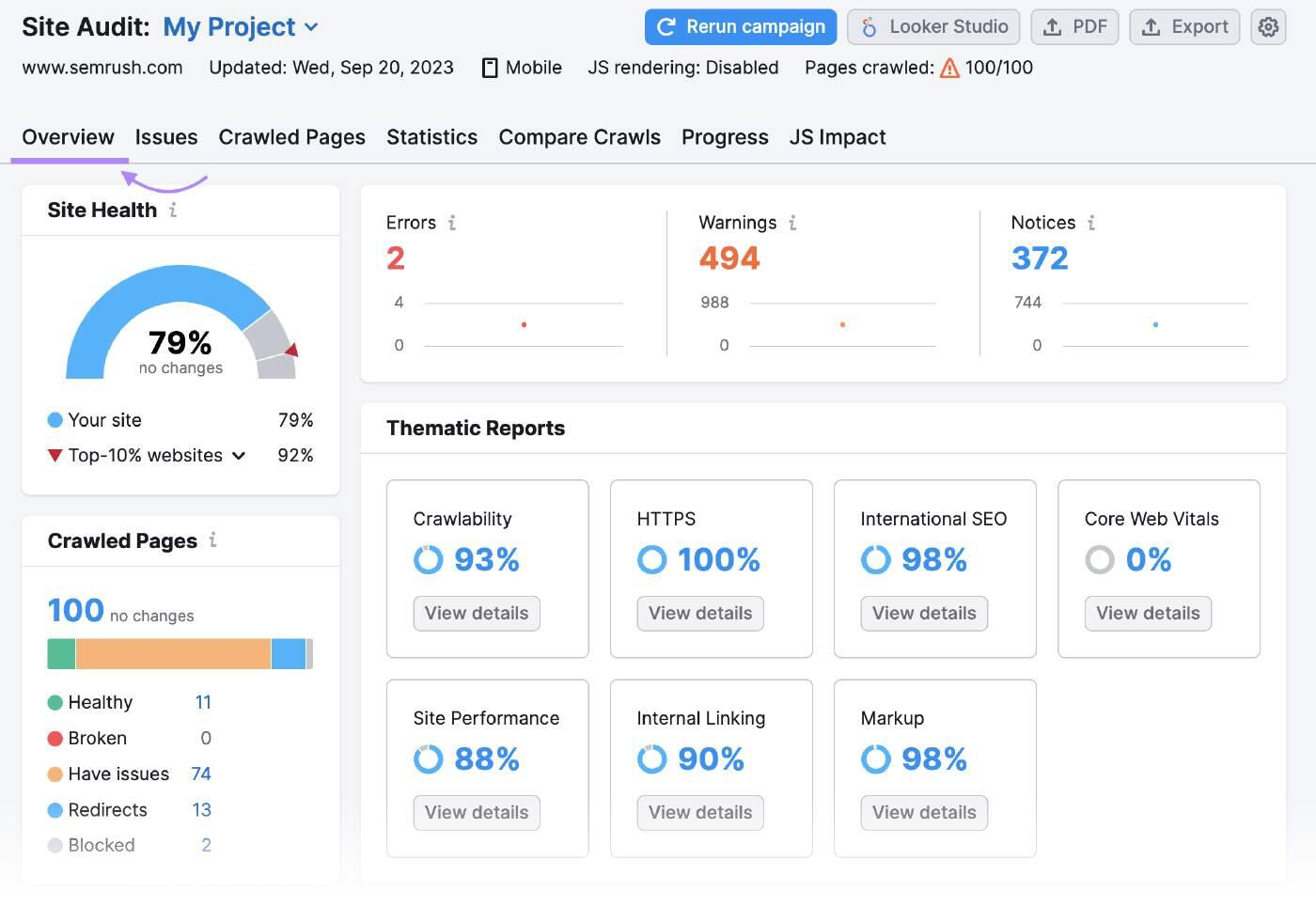

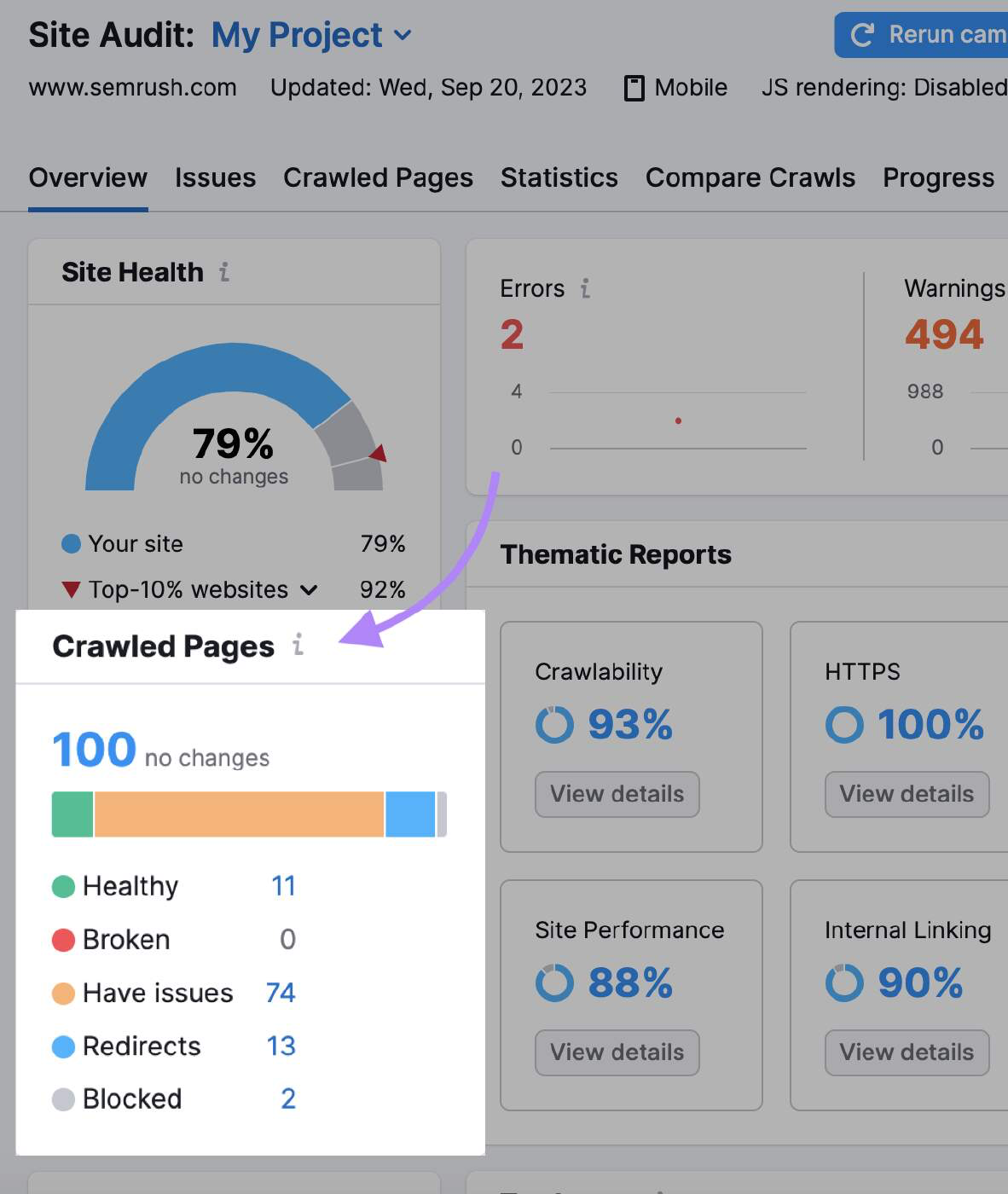

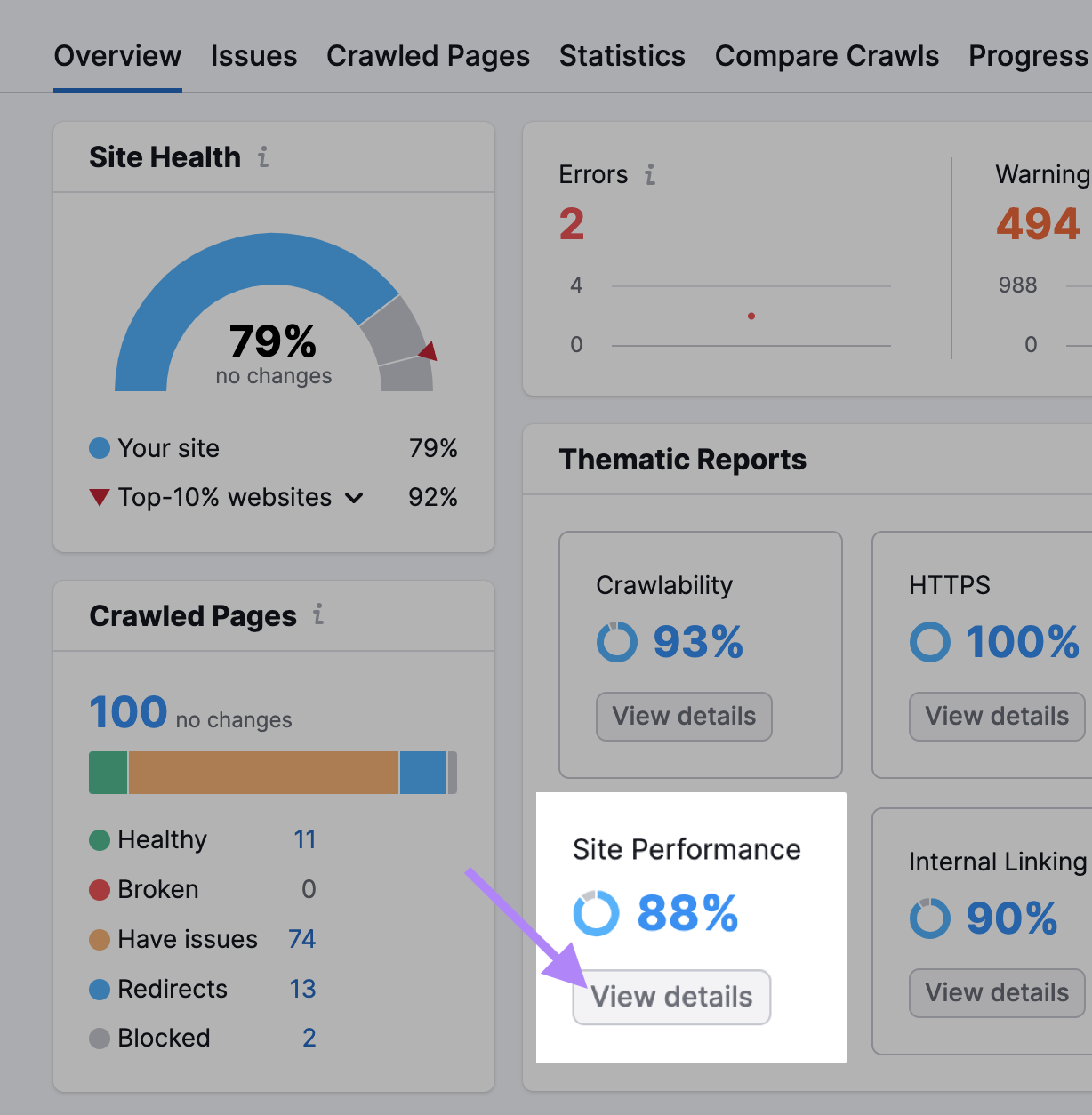

La panoramica dell'audit del sito riassume tutti i dati raccolti dai bot durante il crawling.

La voce "Pagine strisciate" indica quante pagine sono state "Sane", "Rotte" e "Hanno problemi".

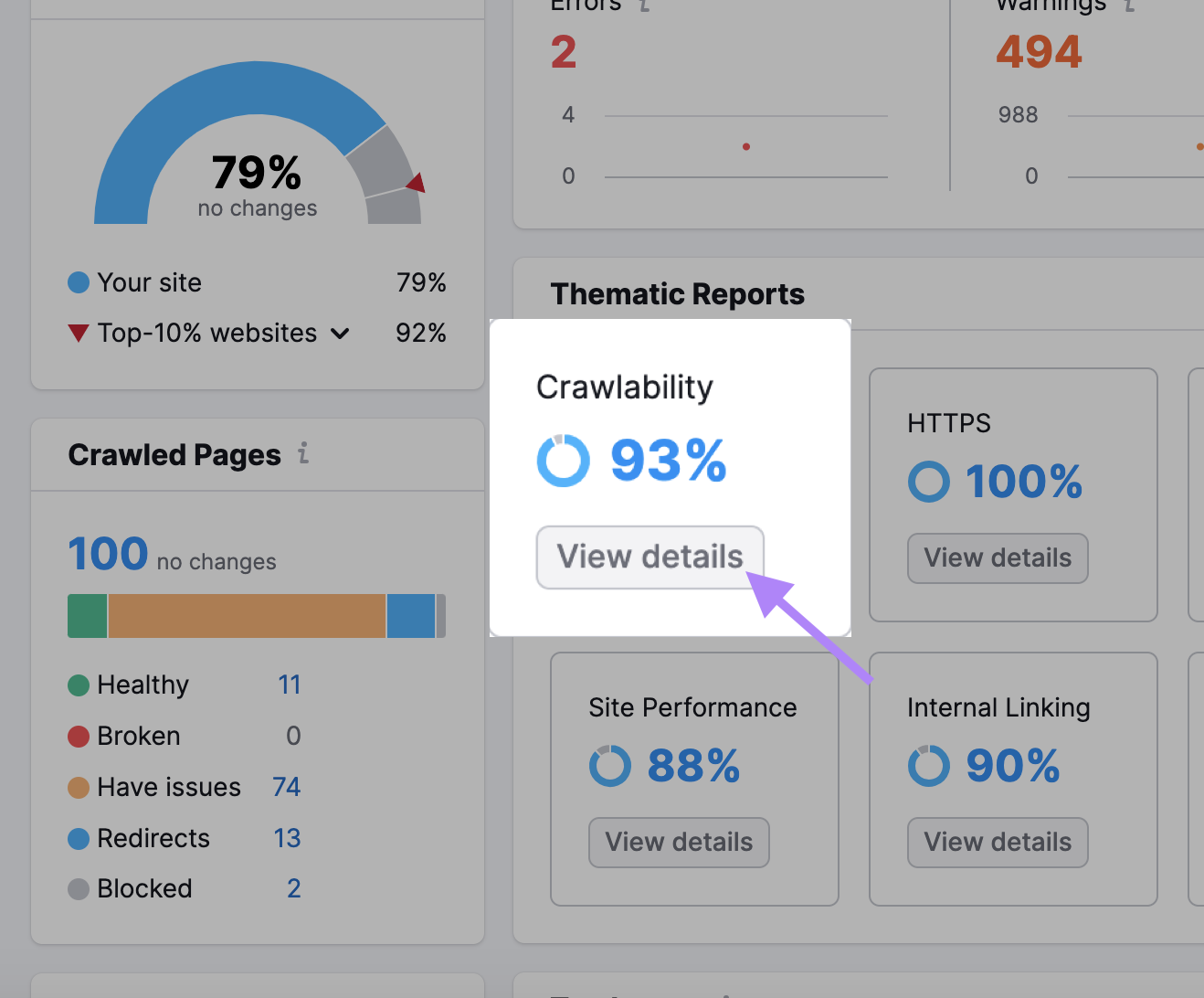

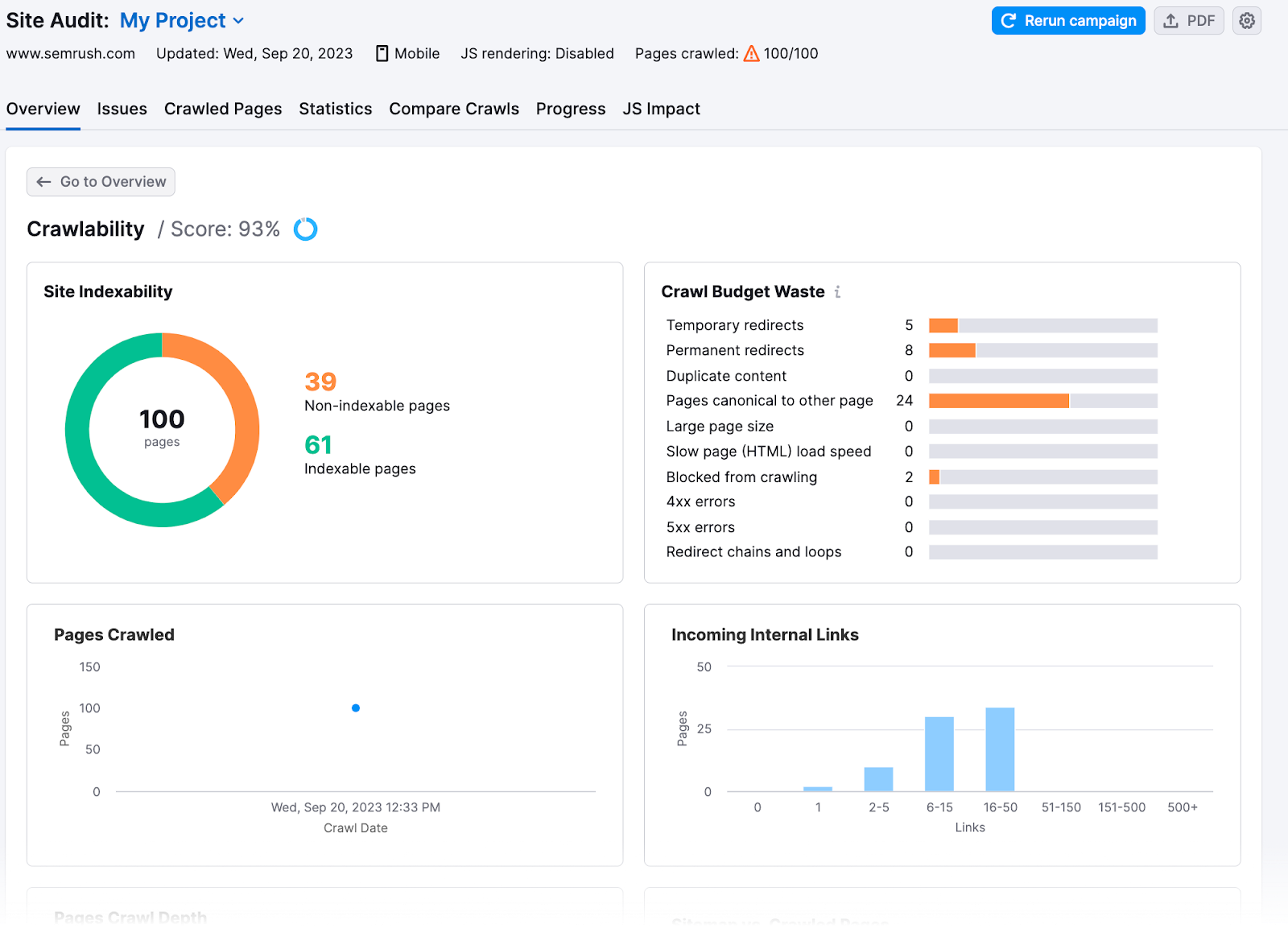

Inoltre, nella sezione "Crawlability" troverai informazioni più approfondite.

Qui scoprirai quanta parte del crawl budget del tuo sito è stata sprecata o ha avuto problemi di crawl budget.

8 consigli per l'ottimizzazione del budget del crawl

Una volta conosciuti i problemi del tuo sito, potrai risolverli e massimizzare l'efficienza del crawling. Ecco come ottimizzare il tuo budget per le strisciate:

Controlla la velocità del tuo sito

Il crawling di Google è limitato dalla larghezza di banda, dal tempo e dalla disponibilità di risorse del Googlebot. Se il server di un sito web risponde più velocemente alle richieste, Google potrebbe scansionare più pagine.

Aumenta la velocità del tuo sito per migliorare l'esperienza dell'utente(UX) e aiutare Google a scansionare il tuo sito più velocemente.

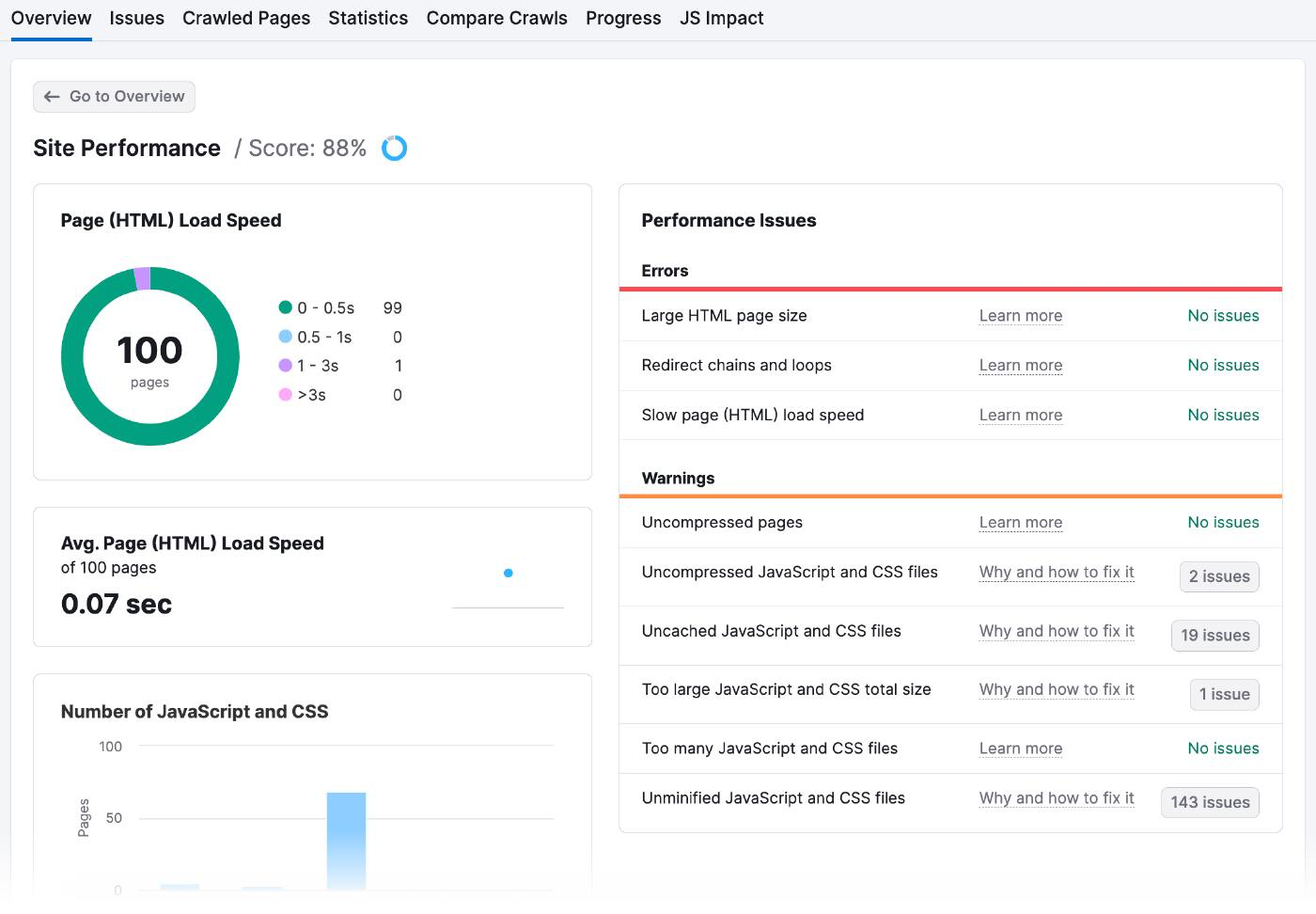

Vai ai risultati della verifica del sito per controllare i tempi di caricamento delle pagine e gli eventuali problemi di performance.

Ecco come si presenta la pagina delle prestazioni del sito:

Esistono molti modi per migliorare la velocità delle pagine, tra cui:

- Ottimizzare le immagini: Usa strumenti online come Optimizilla per ridurre le dimensioni dei file senza pixelarli. Assicurati che le immagini siano dimensionate correttamente e scegli il tipo di file appropriato (come JPEG, PNG o GIF).

- Ridurre al minimo il codice e gli script: Esamina il codice del tuo sito web per rimuovere tutto ciò che è superfluo o ridondante. Inoltre, consolida più file in uno solo e utilizza la cache del browser per memorizzare i dati sul computer dell'utente in modo che non debbano essere ricaricati ogni volta.

- Utilizzando una rete di distribuzione dei contenuti (CDN): Un CDN è una rete di server in diverse parti del mondo. Quando qualcuno tenta di accedere al tuo sito web, la CDN gli invia automaticamente il contenuto dal server più vicino a lui, il che significa che si carica più velocemente. Dovrai iscriverti a un servizio CDN come Amazon Cloudfront, caricare i contenuti del tuo sito web sui loro server e configurare il tuo sito web in modo che utilizzi gli URL del CDN invece dei tuoi.

Aumenta il linking interno e le sitemap delle pagine

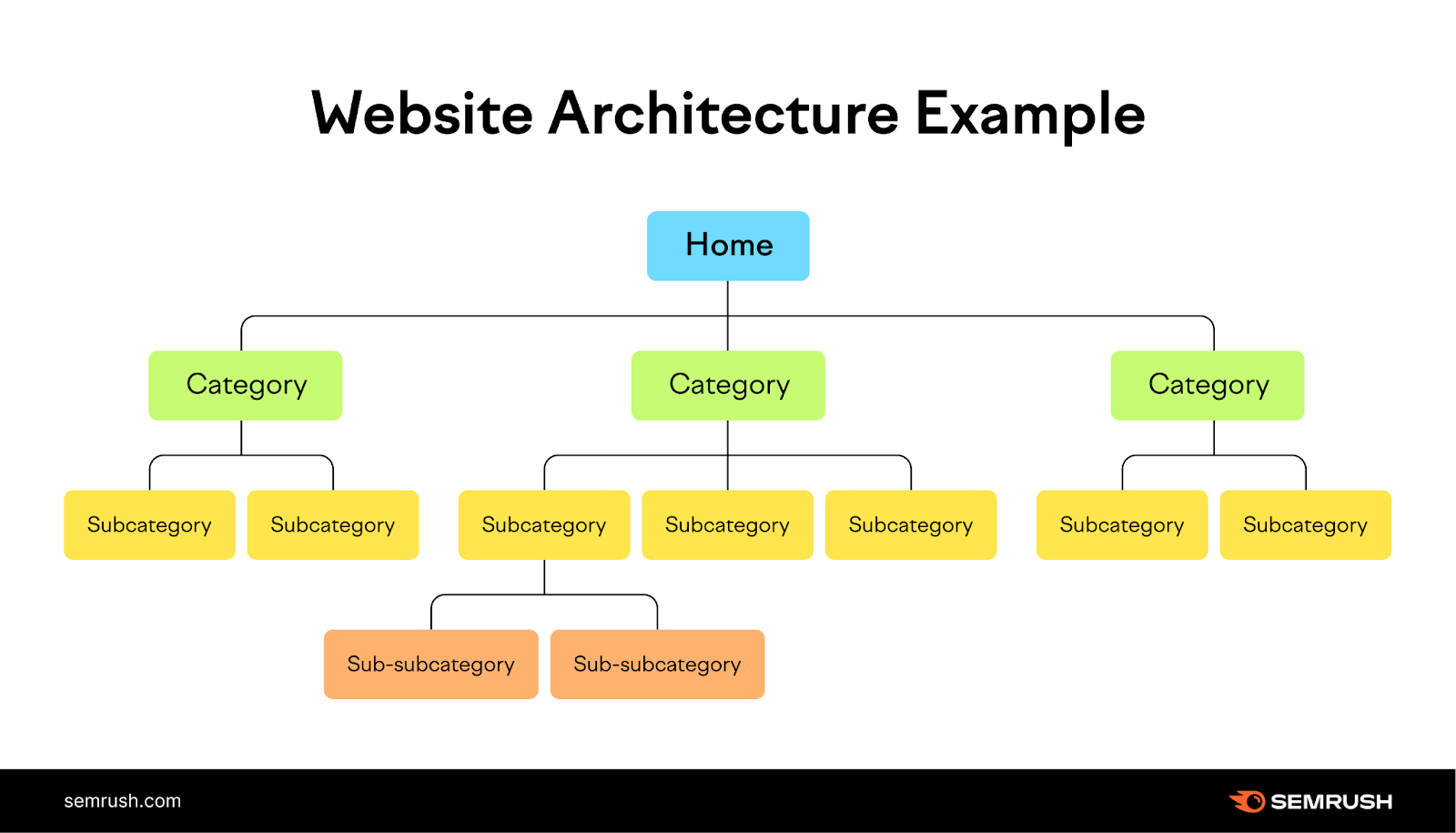

L'aggiunta di una struttura logica di link interni e di una sitemap fornisce ai bot indicazioni su quali pagine indicizzare.

I link interni forniscono un percorso naturale ai crawler dei motori di ricerca per scoprire e classificare nuove pagine, mentre le sitemap li aiutano a capire la struttura e la gerarchia dei tuoi contenuti.

Immagina il tuo sito web come un albero, con la homepage in cima e i rami che rappresentano le diverse categorie. Ogni ramo deve condurre a foglie più piccole (pagine) ad esso correlate, creando una struttura chiara e logica per il tuo sito web che sia facile da navigare per gli utenti.

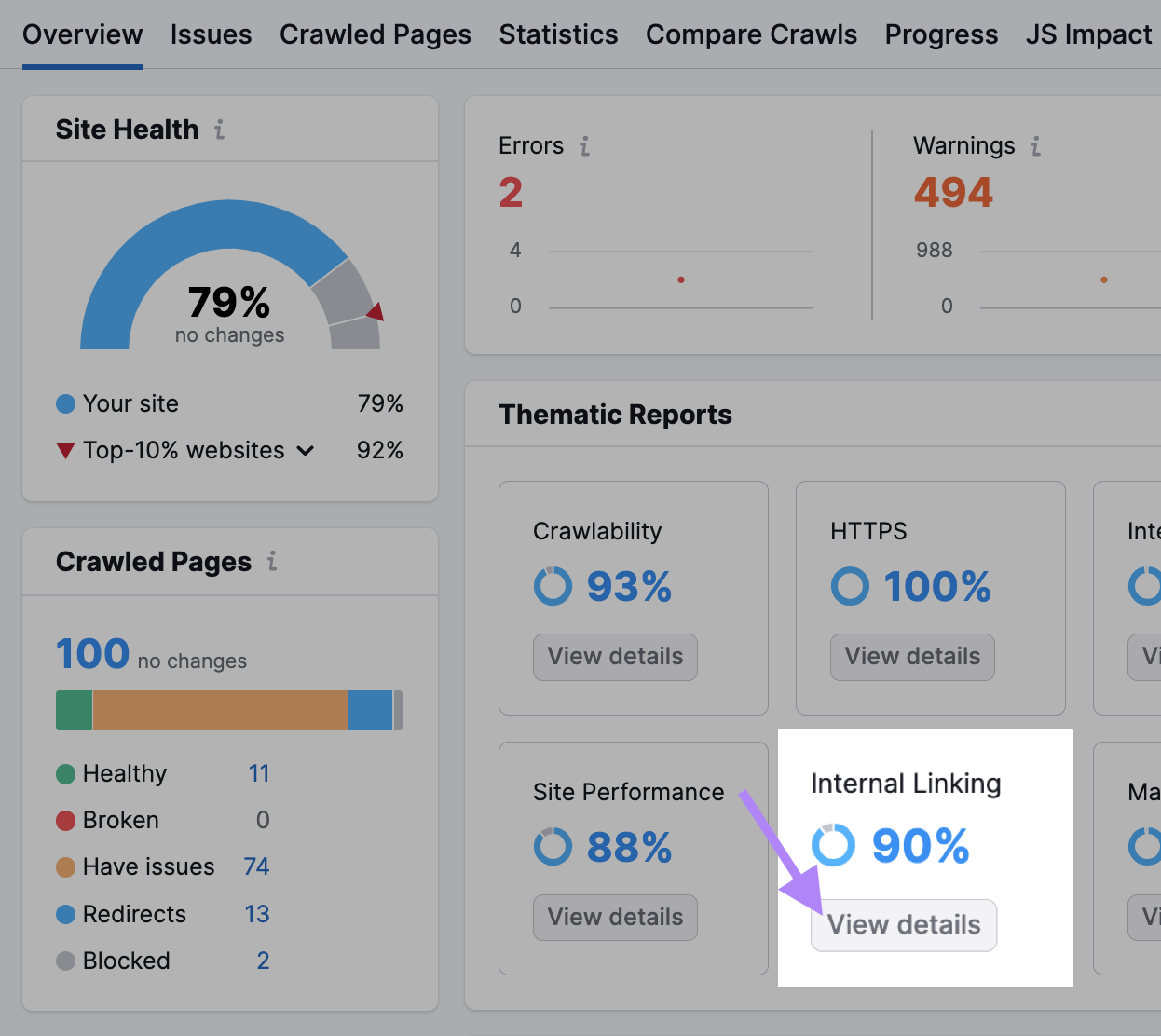

Controlla la sezione Link interni del tuo Site Audit per avere un'idea di quanto bene hai fatto.

Quando hai questi dati, ecco come puoi migliorare la tua struttura di linking interno:

- Le barre della Struttura dei Collegamenti Interni ti dicono quali sono le tue pagine forti, quelle mediocri e quelle che richiedono un miglioramento. Aggiungi altri link interni alle pagine delle ultime due categorie.

- Crea dei cluster di argomenti raggruppando le pagine correlate sotto un unico argomento e collegandole tra loro. Supponiamo che tu gestisca un blog che parla di vita sana. La tua pagina principale potrebbe essere "Vita sana" e i tuoi gruppi di argomenti potrebbero essere "Nutrizione", "Fitness" e "Salute mentale".

- Google molto probabilmente effettuerà il crawling delle pagine con molti link interni. Sono quelli nuovi e che non hanno abbastanza link interni che puntano a loro che possono avere problemi. Ad esempio, se hai recentemente aggiunto un articolo sulle "Previsioni di marketing per il 2024", rimanda ad esso dalle tue pagine più importanti per attirare l'attenzione e il traffico di Google.

Nascondi gli URL che non desideri nei risultati di ricerca

Contrassegnare le pagine di pagamento, le pagine di destinazione degli annunci, le pagine di login e le pagine di ringraziamento come "noindex" in modo che non appaiano nei risultati dei motori di ricerca. Come altri meta-tag, il tag "noindex" va inserito nell'head <di una pagina web>.

Questo tag è particolarmente utile per le pagine duplicate o per altre pagine che vuoi mantenere private.

Anche se i bot continueranno a strisciare queste pagine per vedere il tag, ne prenderanno nota e ne limiteranno il crawling in futuro.

Per dire ai motori di ricerca di non indicizzare una pagina specifica, usa il meta tag robots con l'attributo "noindex".

Inserisci il seguente tag nell'head <> della tua pagina:

<meta name="robots" content="noindex">Ridurre i reindirizzamenti

I reindirizzamenti inviano automaticamente i bot da una pagina web a un'altra. Se il bot visita una pagina che è stata spostata o cancellata, il reindirizzamento lo porta alla nuova posizione della pagina o a una pagina che spiega perché la pagina originale non è più disponibile.

I reindirizzamenti richiedono più risorse da parte del bot, poiché visitano più pagine del necessario.

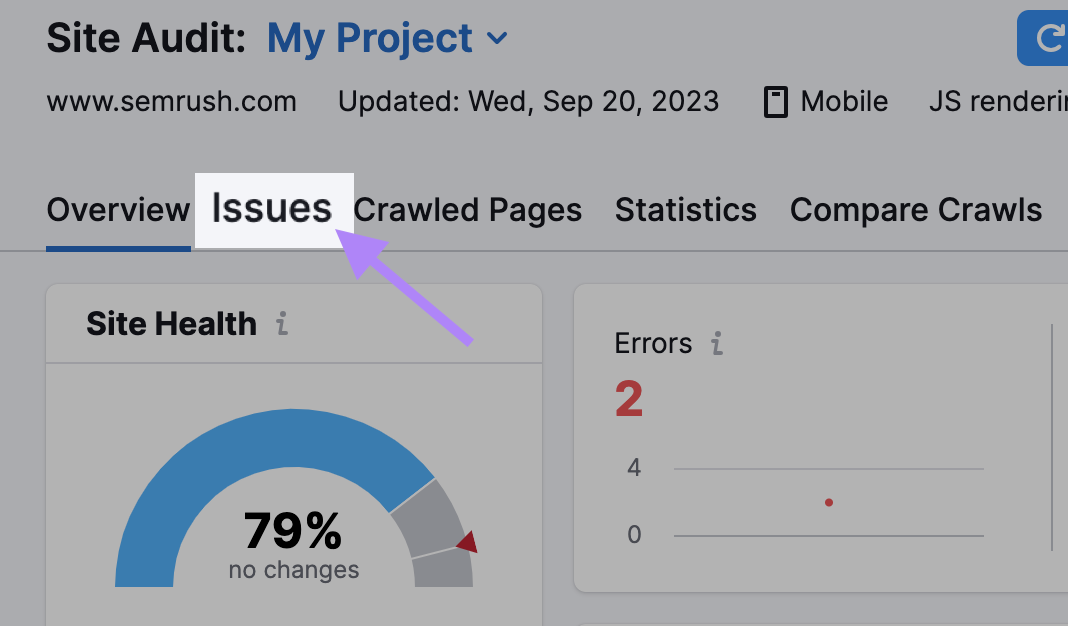

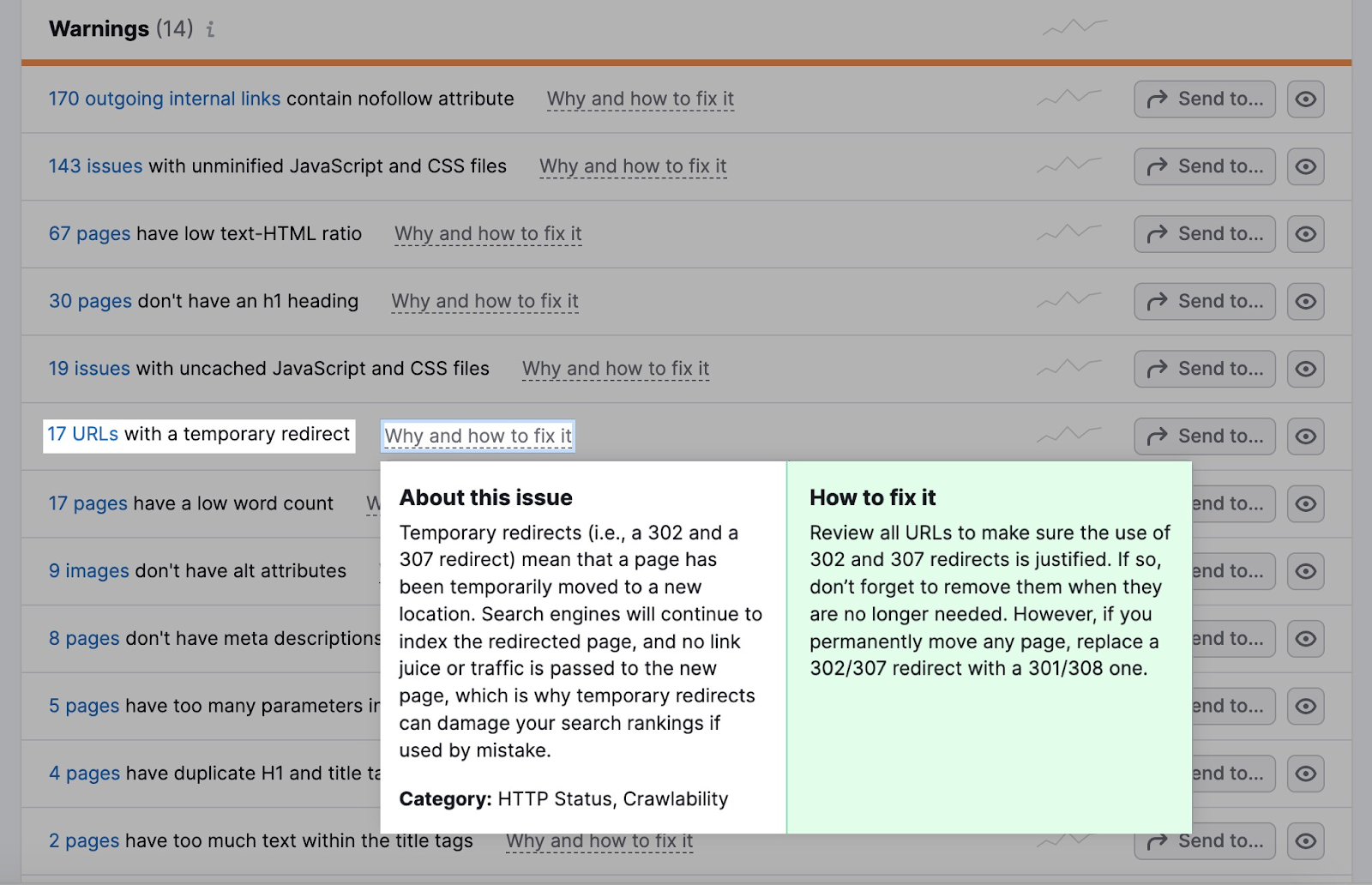

Vai alla scheda Problemi del tuo Site Audit.

La sezione Avvertenze ti dirà quanti URL hanno un reindirizzamento temporaneo.

La maggior parte dei browser segue un massimo di cinque catene di reindirizzamento in un crawl.

Se utilizzi dei reindirizzamenti, assicurati che siano logici.

Supponiamo che un sito web sportivo abbia un articolo su una partita di calcio dello scorso anno con l'URL "example.com/football-game-2022".

Tuttavia, la partita di quest'anno ha un URL diverso: "example.com/football-game-2023".

Per evitare confusione, il sito web può impostare un reindirizzamento in modo che chiunque cerchi di accedere a "example.com/football-game-2022" venga automaticamente reindirizzato a "example.com/football-game-2023".

Questo reindirizzamento sarebbe logico.

D'altra parte, il sito web potrebbe avere più reindirizzamenti non necessari, come ad esempio reindirizzare da "esempio.com/football-game-2022" a "esempio.com/football-game-recaps" e poi a "esempio.com/football-game-2023".

In questo modo si creerebbe una catena di reindirizzamenti che spreca risorse e può danneggiare l'efficienza di crawling del sito web.

Correggi i link rotti

I link rotti sono pagine a cui i bot non possono accedere. Danneggiano la crawlabilità e l'esperienza dell'utente.

Se i bot non possono accedere a una pagina, non possono effettuare il crawling e l'indicizzazione. Troppi di questi errori rallentano il processo di crawling e intaccano il tuo budget per il crawling.

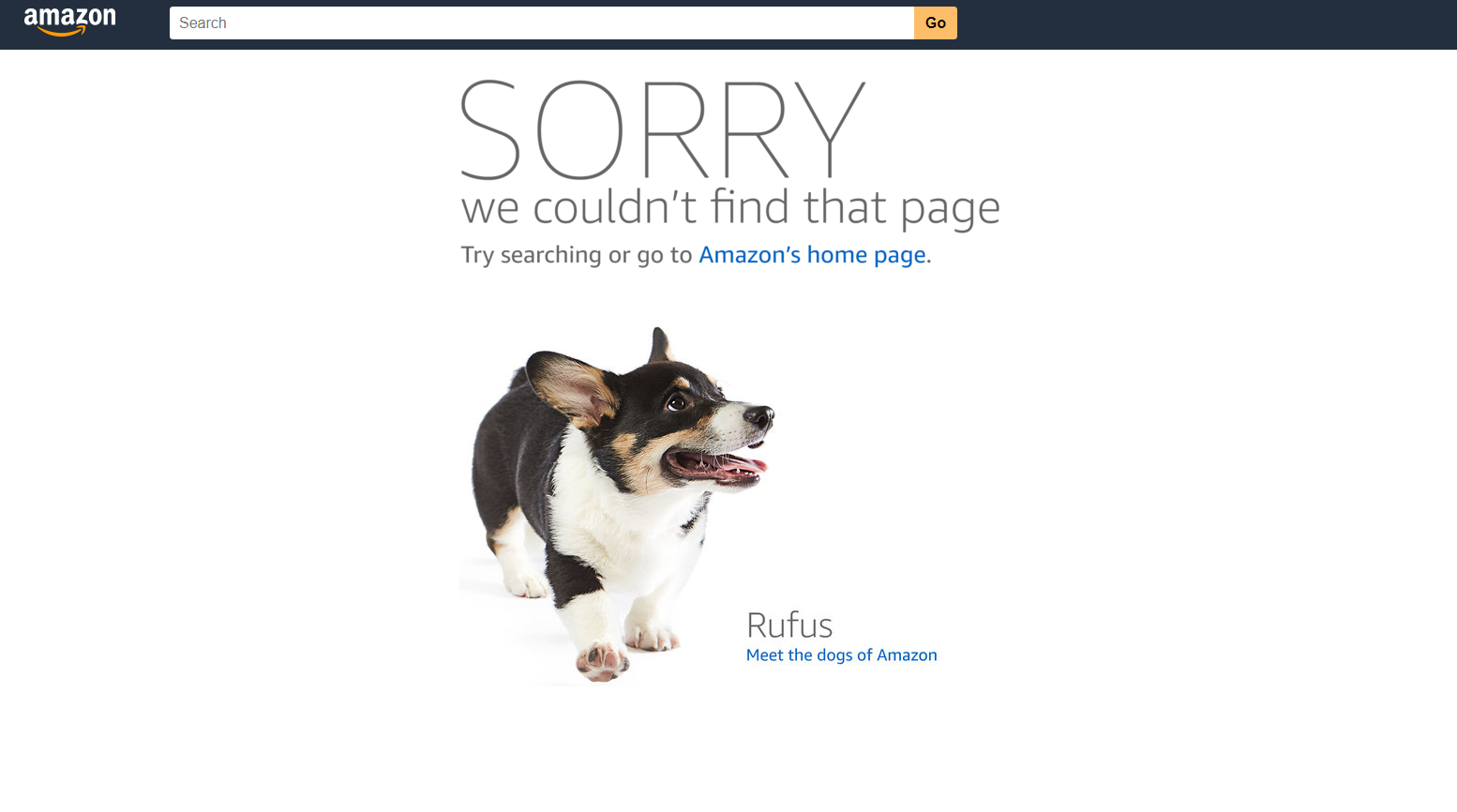

Un errore 404 su Amazon, ad esempio, si presenta così.

Abbiamo tradotto questo articolo dall'inglese. Clicca qui per leggere l'articolo originale. Se noti qualche problema con i contenuti, non esitare a contattarci all'indirizzo report-osteam@semrush.com.

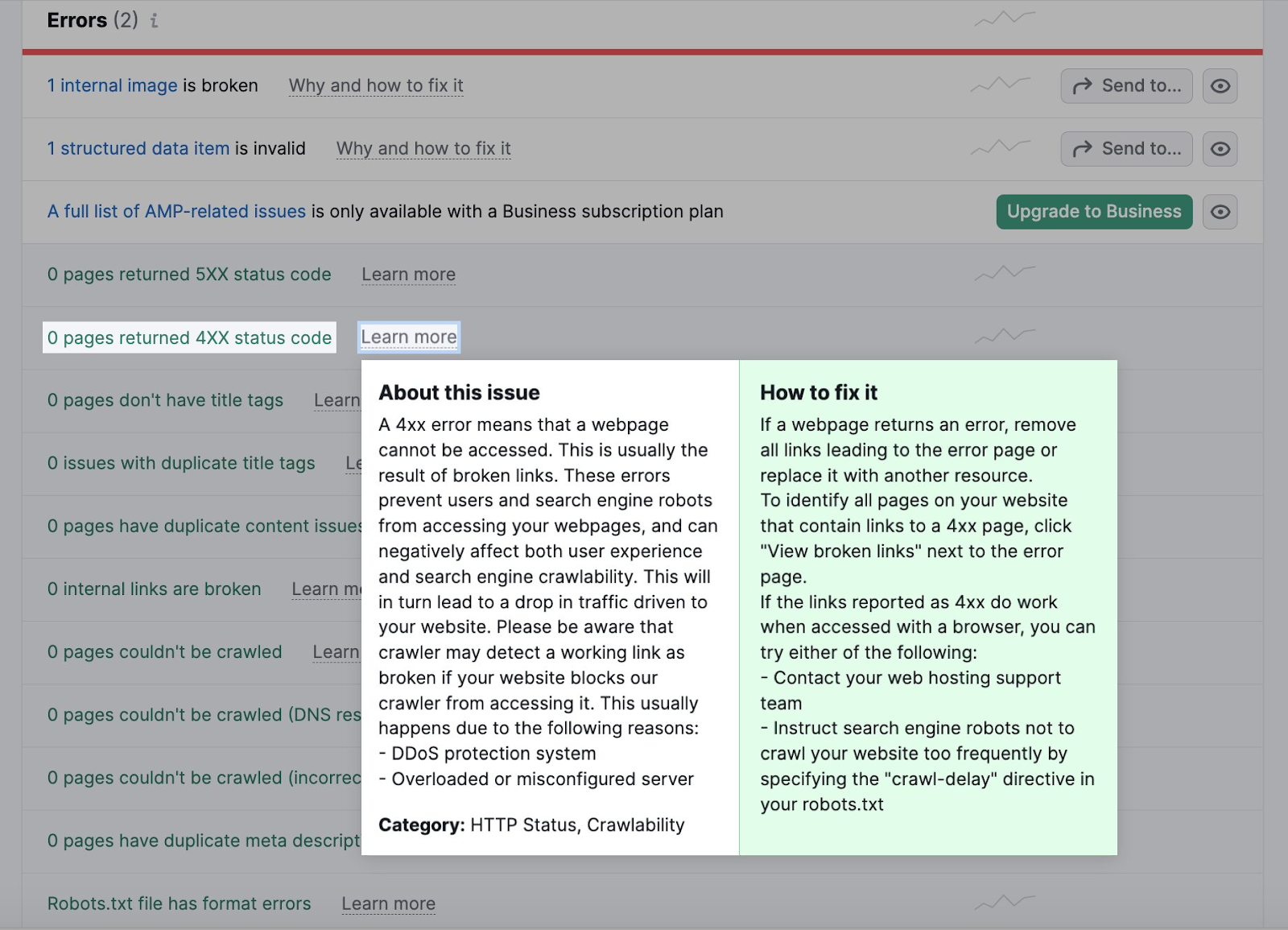

Puoi identificare i link interrotti come errori 4xx nella scheda Issues del tuo Site Audit.

Clicca sul numero di pagine da controllare per verificare la presenza di quelle rotte. Quindi sostituisci tutti i link che portano alla pagina non funzionante con un'altra pagina.

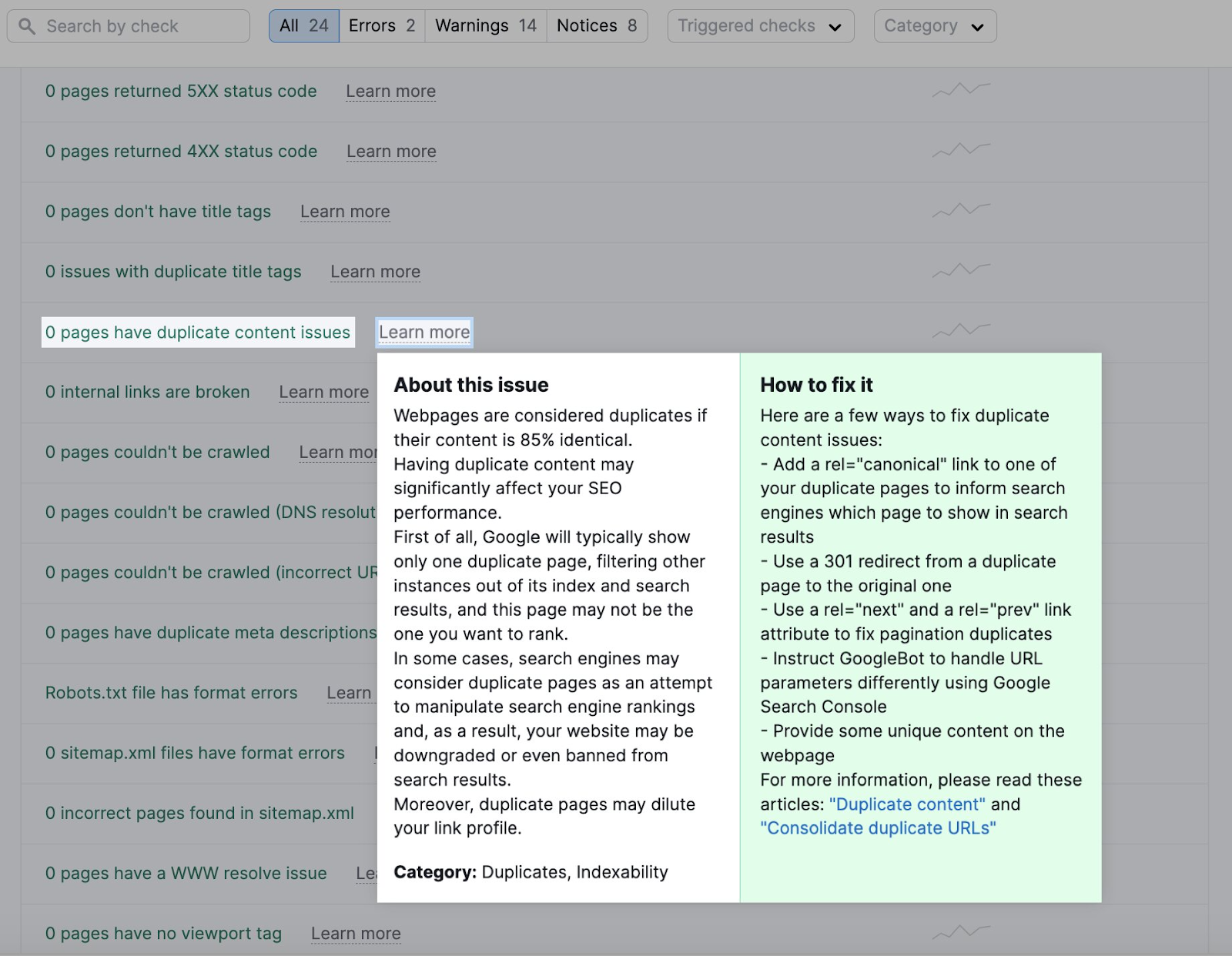

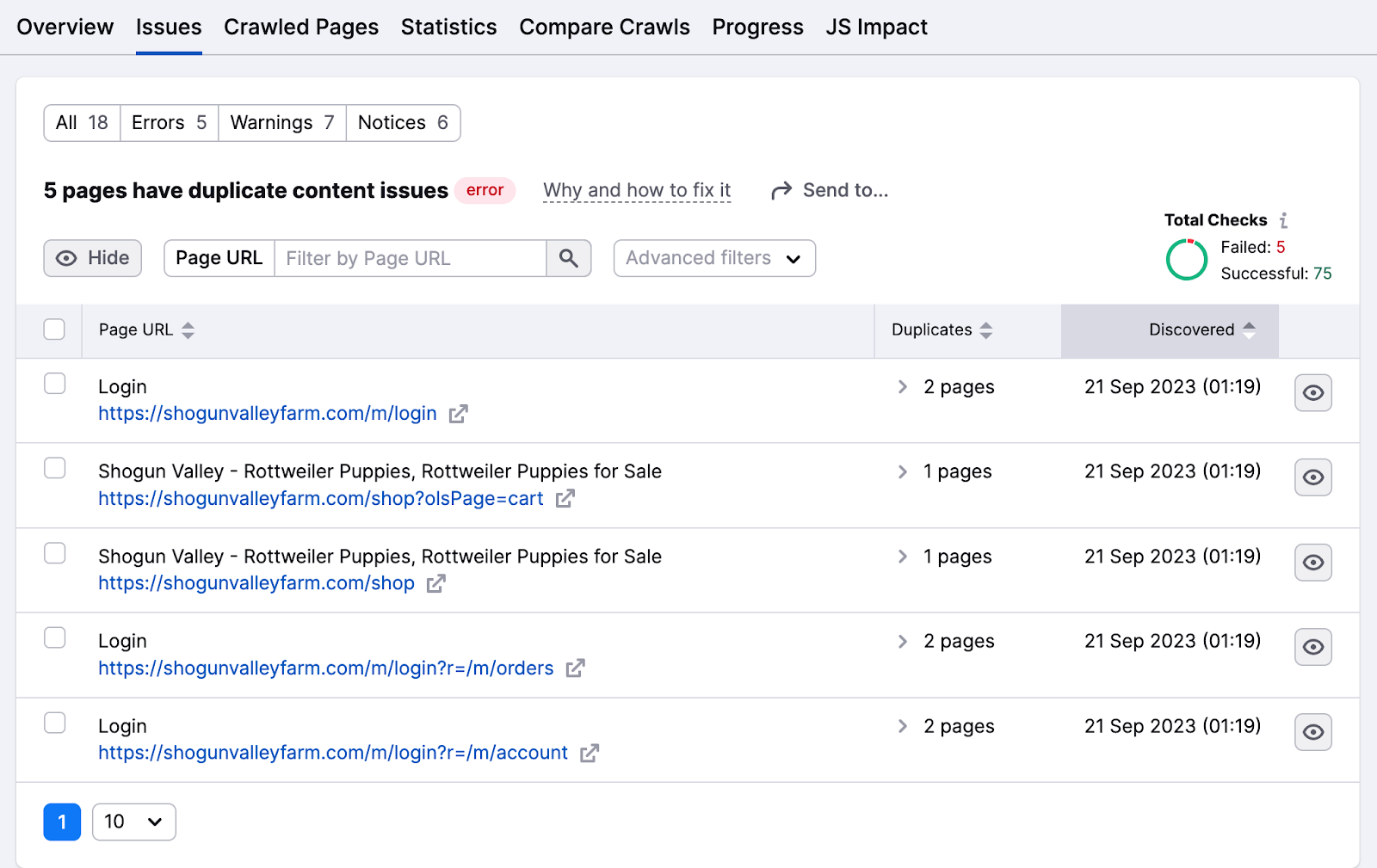

Eliminare i contenuti duplicati

I bot considerano le pagine web duplicate se il contenuto è identico all'85%. Riduci i contenuti duplicati per evitare che i bot si confondano e cerchino la stessa pagina più volte, sprecando tempo e risorse.

I contenuti duplicati influiscono anche sull'indicizzazione, poiché i motori di ricerca possono considerarli una tattica di manipolazione.

La scheda Problemi evidenzia eventuali problemi di contenuti duplicati.

Clicca sul numero della pagina per controllare l'elenco delle pagine con questi problemi.

Alcuni modi per risolvere i problemi di contenuto duplicato includono:

- Rendi il contenuto unico organizzandolo in un gruppo di argomenti o assegnando una parola chiave di riferimento.

- Aggiungi il tag canonico "rel=canonical" nel codice HTML di una di queste pagine per indicare a Google quale pagina vuoi che appaia nei risultati di ricerca

- Aggiungi un reindirizzamento 301 dalla pagina duplicata a quella originale (non è l'idea migliore per ridurre i reindirizzamenti)

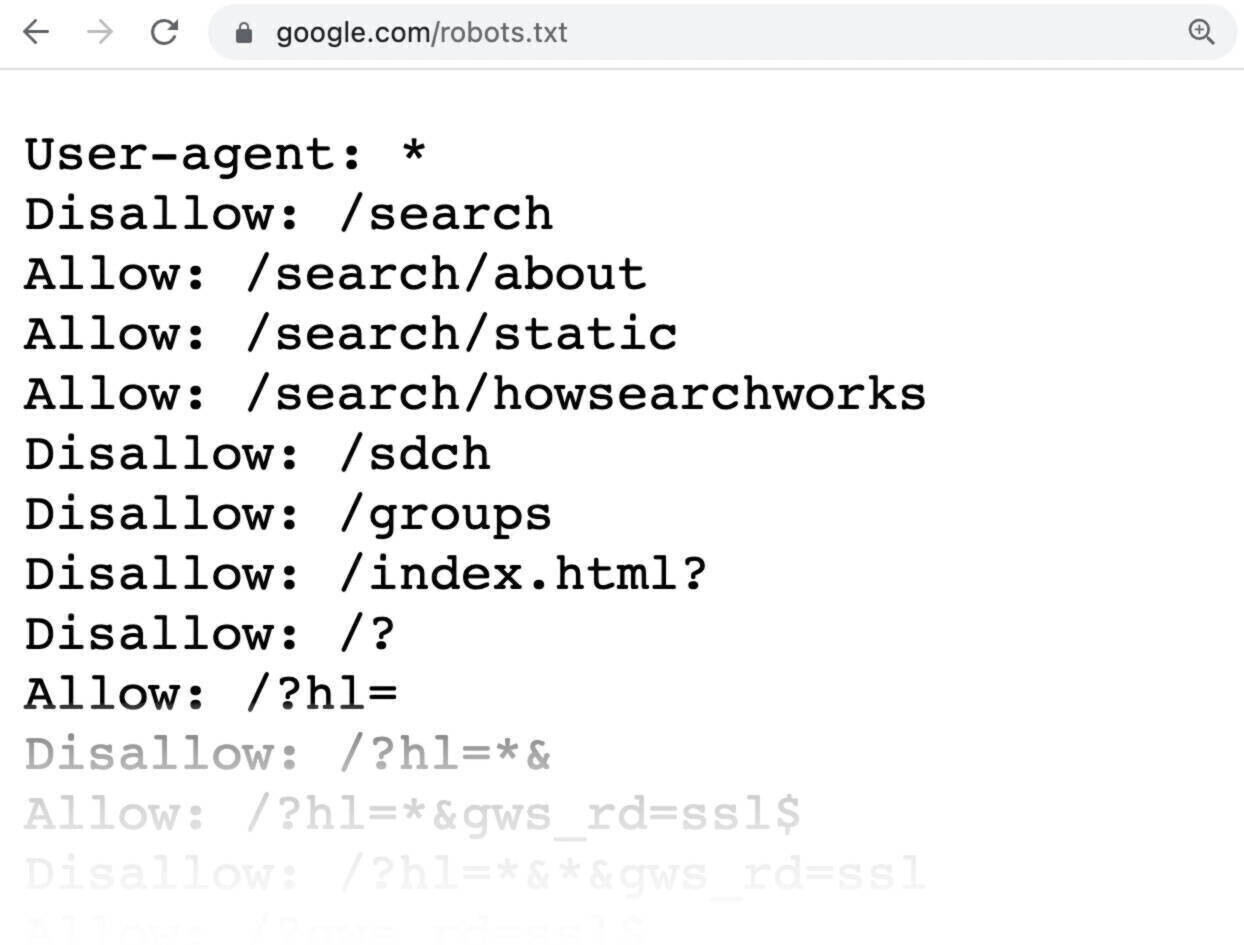

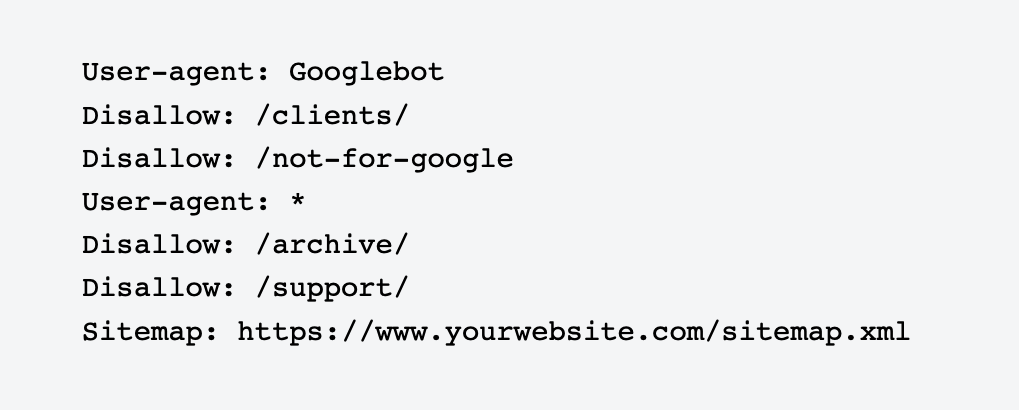

Usa il file Robots.txt

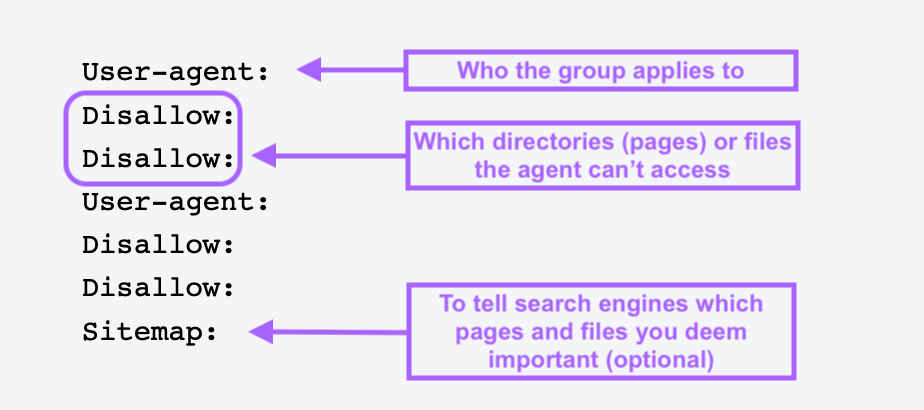

Un file robots.txt è un file di testo da inserire nella directory principale del tuo sito web per indicare ai bot dei motori di ricerca quali pagine o sezioni del sito non devono essere scansionate o indicizzate.

I file Robots.txt ti aiutano a bloccare le pagine non importanti o private come quelle di login. Non vuoi che i bot indicizzino queste pagine e sprechino le loro risorse, quindi è meglio dire ai bot cosa devono fare.

Ecco come si presenta un semplice file robots.txt:

Tutte le pagine dopo Disallow specifica le pagine che non vuoi siano indicizzate.

Per creare un file robots.txt, utilizza uno strumento di generazione di robots.txt. Puoi anche realizzarne uno tu stesso.

Per prima cosa, apri un documento .txt con un qualsiasi editor di testo o browser web e denominalo robots.txt.

Poi aggiungi le direttive, che sono più righe di istruzioni.

Una volta creato il file robots.txt, salvalo e caricalo sul tuo sito. Il processo di caricamento dipende dal tuo hosting web e dalla struttura dei file del sito.

Rivolgiti al tuo provider di hosting o cerca aiuto online per capire come fare. Ad esempio, cerca "upload robots.txt file to Shopify" per ottenere istruzioni specifiche.

Evita le pagine orfane

Le pagine orfane non hanno alcun link interno o esterno che punta a loro. Queste pagine possono essere difficili da trovare per i crawler, quindi è importante collegarle da altre aree del tuo sito.

Una volta trovato l'elenco, collegati a queste pagine da altri domini ad alta autorevolezza del tuo sito web.

Puoi anche collegare tra loro i post del blog, le pagine dei prodotti e le landing page delle categorie per facilitare la ricerca da parte dei crawler.

Massimizza il tuo budget per i crawl con Semrush

Mentre Google è in grado di scansionare facilmente i siti di piccole dimensioni, i siti web più grandi e complessi dovrebbero adottare un approccio proattivo per gestire le loro prestazioni di ricerca.

Ciò significa monitorare e ottimizzare regolarmente i vari aspetti tecnici di un sito per garantire che rimanga accessibile, ben strutturato e ben visibile.

Indipendentemente dalle dimensioni della tua azienda, usa lo strumento Site Audit di Semrush per valutare lo stato di salute del sito web, ottimizzare la crawlabilità e correggere gli errori prima che causino danni. In questo modo, il tuo sito rimarrà un attore forte nelle SERP.